IBM e Cisco hanno messo nero su bianco una delle ambizioni più radicali dell’attuale corsa al calcolo quantistico: gettare le fondamenta di un internet quantistico, una rete di computer quantistici distribuiti e fault-tolerant in grado di lavorare insieme come un unico super-sistema. L’obiettivo dichiarato è realizzare, già entro la fine del decennio, una prima dimostrazione di rete tra più sistemi quantistici e arrivare, nei primi anni 2030, a un’infrastruttura capace di gestire carichi di lavoro distribuiti su decine o centinaia di migliaia di qubit.

Alla base dell’intesa c’è un incastro piuttosto evidente di competenze: IBM porta in dote la leadership nella costruzione di computer quantistici “utili”, con una roadmap aggressiva verso macchine di grande scala e tolleranti agli errori; Cisco mette sul piatto la sua ricerca sul quantum networking e la visione di data center quantistici in cui la connettività è parte integrante dell’architettura, non un’aggiunta successiva.

Dal singolo processore alla rete: perché serve un calcolo quantistico distribuito

Il punto di partenza è la consapevolezza che scalare il calcolo quantistico non potrà significare soltanto costruire macchine sempre più grandi. IBM lo dice chiaramente: la roadmap dell’azienda prevede il rilascio di computer quantistici su larga scala e fault-tolerant entro la fine del decennio, con la capacità di eseguire circuiti profondi e di mantenere la coerenza quantistica per tempi sufficienti a risolvere problemi reali.

Ma oltre una certa soglia di complessità, diventa più efficiente – e più realistico – collegare più sistemi quantistici tra loro, piuttosto che continuare ad aumentare le dimensioni di un singolo elaboratore. È qui che entra in gioco il concetto di calcolo quantistico distribuito: una rete di computer quantistici che condividono risorse di entanglement e si coordinano per eseguire parti diverse di uno stesso algoritmo.

IBM e Cisco si danno un orizzonte temporale preciso: entro cinque anni vogliono dimostrare un primo proof-of-concept di rete che combini più computer quantistici fault-tolerant, capaci di cooperare su elaborazioni che coinvolgono decine o centinaia di migliaia di qubit. In prospettiva, questa architettura dovrebbe permettere di eseguire algoritmi con potenzialmente trilioni di quantum gate, il livello necessario per applicazioni davvero trasformative, come:

- la risoluzione di problemi di ottimizzazione di dimensioni oggi ingestibili, dalla logistica globale al design di reti energetiche complesse;

- la progettazione di nuovi materiali avanzati;

- la simulazione accurata di molecole per la scoperta di farmaci e terapie di nuova generazione.

IBM e Cisco: scala, rete e visione di sistema

La dichiarazione di intenti delle due aziende è accompagnata da messaggi piuttosto espliciti sul cambio di scala richiesto.

Jay Gambetta, Director of IBM Research e IBM Fellow, sintetizza così l’ambizione dell’azienda: “Nel nostro roadmap sono previste la consegna di computer quantistici su larga scala e fault-tolerant prima della fine del decennio. Lavorando con Cisco per esplorare come collegare più computer quantistici di questo tipo in una rete distribuita, vogliamo capire come spingere ancora oltre la capacità computazionale del quantistico. E man mano che costruiamo il futuro del compute, la nostra visione è spingere i confini di ciò che i computer quantistici possono fare all’interno di un’architettura di high-performance computing più ampia.”

L’accento non è solo sull’hardware, ma sull’integrazione dei sistemi quantistici in architetture ibride, in cui il calcolo classico ad alte prestazioni e il calcolo quantistico convivono nello stesso framework di quantum-centric supercomputing.

Dal lato Cisco, Vijoy Pandey, GM/SVP di Outshift by Cisco, sposta l’attenzione sulla dimensione di rete: “Portare il calcolo quantistico su una scala realmente utile non significa soltanto costruire macchine sempre più grandi; significa anche collegarle tra loro. IBM sta costruendo computer quantistici con roadmap aggressive per lo scale-up, e noi portiamo il quantum networking che abilita lo scale-out. Insieme affrontiamo il problema come un sistema completo: l’hardware per connettere i computer quantistici, il software per eseguire i calcoli attraverso di essi e l’intelligenza di rete che li fa funzionare.”

Il messaggio è chiaro: niente silos. Calcolo, rete e software vengono trattati come un problema di sistema end-to-end, non come tre strade parallele che si incrociano solo alla fine.

QPU, QNU e rete quantistica: l’architettura che IBM e Cisco vogliono costruire

Sul piano tecnico, IBM e Cisco intendono esplorare lo sviluppo di hardware e software quantistico per collegare fisicamente molti computer quantistici fault-tolerant in una rete distribuita.

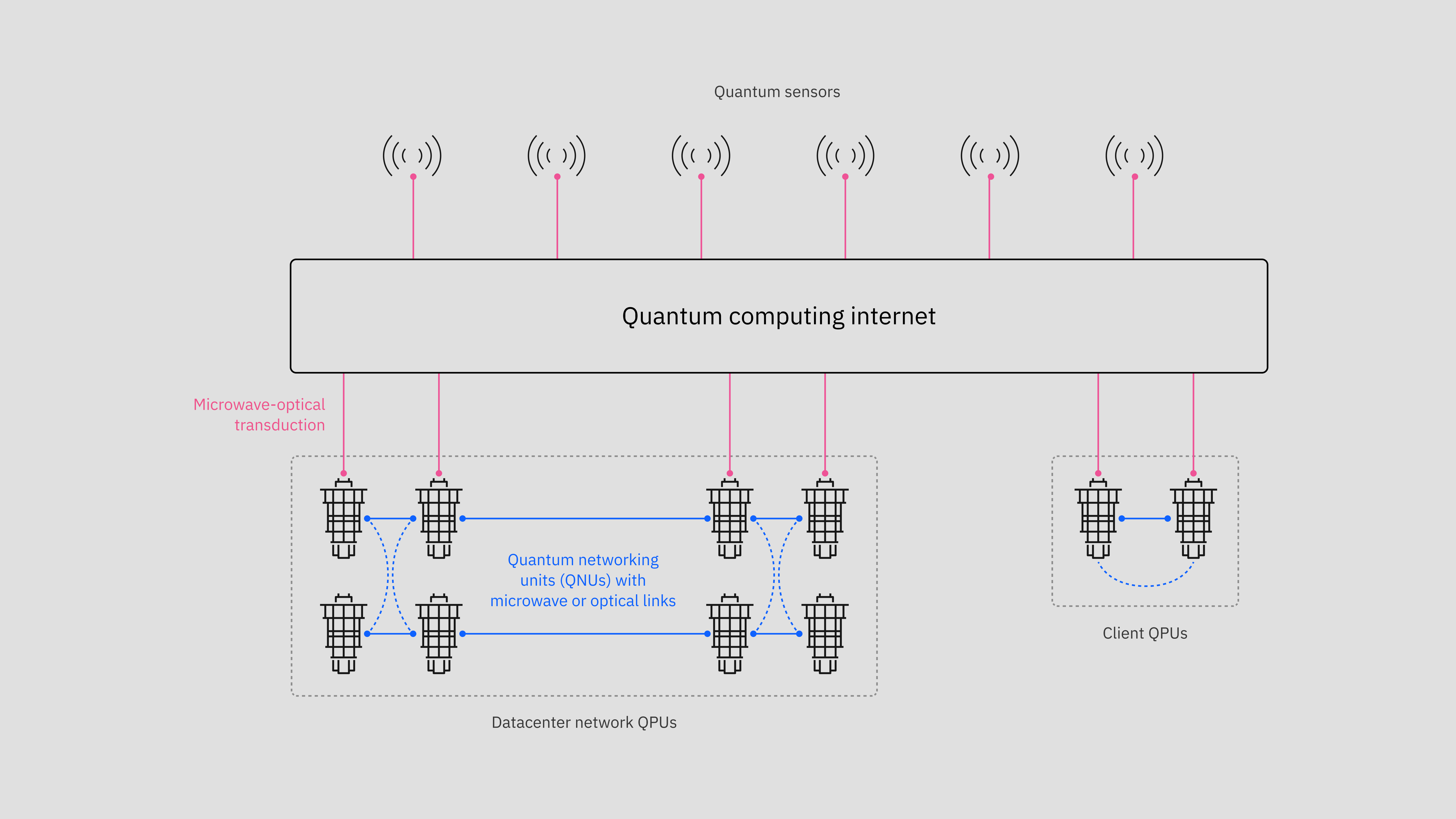

Il cuore computazionale resta la Quantum Processing Unit (QPU), il processore quantistico vero e proprio. Ma per trasformare un computer quantistico in un nodo di rete serve un nuovo componente, che IBM definisce Quantum Networking Unit (QNU). Il ruolo della QNU è quello di interfaccia tra la QPU – dove l’informazione quantistica è “stazionaria”, custodita nei qubit – e la rete, in cui la stessa informazione deve diventare un’entità “volante” (flying qubit) per viaggiare verso altri nodi.

In pratica, la QNU dovrà:

- prelevare l’informazione quantistica dalla QPU;

- convertirla in uno stato adatto a essere trasmesso (ad esempio tramite fotoni in fibra ottica);

- orchestrare l’entanglement e le operazioni di teleportazione quantistica necessarie a distribuire parti dell’algoritmo tra diversi computer quantistici;

- mantenere il tutto sincronizzato su scale temporali dell’ordine del sub-nanosecondo.

Su questa architettura si innesta la visione Cisco di un quantum data center: una struttura in cui l’infrastruttura di rete quantistica non è un’aggiunta a posteriori, ma un livello fondamentale, con una pila hardware e software completa per:

- preservare stati quantistici estremamente fragili;

- distribuire risorse di entanglement tra nodi diversi;

- facilitare la teleportazione tra computer quantistici;

- sincronizzare operazioni distribuite con precisione estrema.

Dal laboratorio al campus, fino ai data center: il problema delle distanze

Oggi un computer quantistico tipico vive in un singolo criostato – un’enorme struttura criogenica in cui la temperatura interna è di pochi millikelvin sopra lo zero assoluto. Collegare direttamente due QPU che non si trovano nello stesso criostato è già una sfida, perché l’informazione quantistica soffre immediatamente di decoerenza.

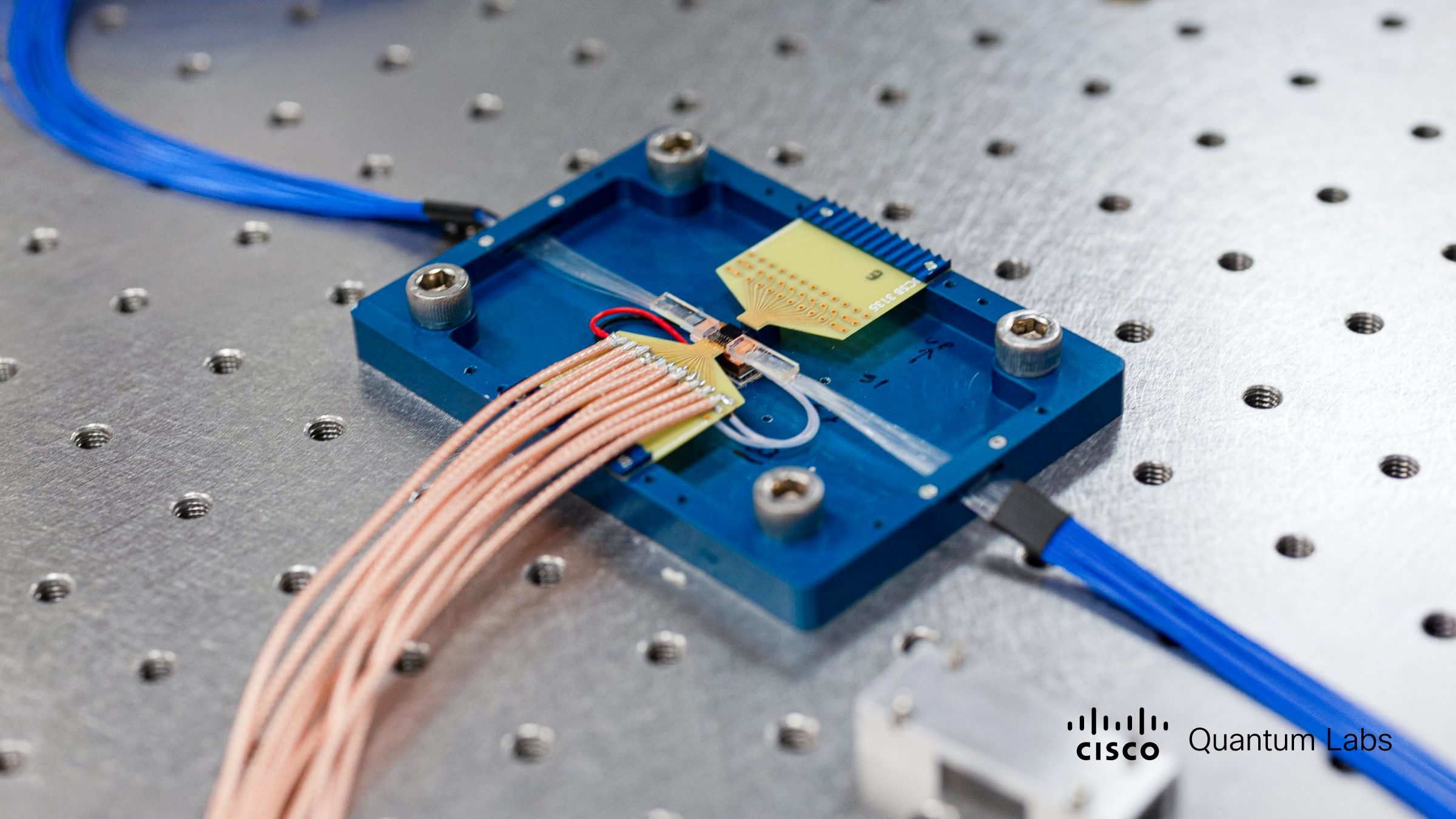

IBM e Cisco prevedono come primo passo una dimostrazione di entanglement tra qubit appartenenti a più computer quantistici separati, ognuno in un proprio ambiente criogenico distinto. Per farlo serviranno nuove tipologie di connessioni fisiche, in particolare dispositivi come i microwave-optical transducer – convertitori in grado di trasformare segnali a microonde provenienti dai qubit in fotoni ottici trasmissibili su fibra, e viceversa.

Una volta dimostrato il collegamento tra sistemi fisicamente vicini – ad esempio all’interno dello stesso laboratorio o data center – il passo successivo sarà estendere la portata al di là di un singolo edificio, fino a collegare computer quantistici tra diversi edifici o addirittura tra più data center.

In questa fase, IBM e Cisco intendono esplorare:

- tecnologie basate su fotoni ottici per il trasporto dell’informazione quantistica;

- l’integrazione dei transducer microonde-ottico in una rete quantistica coerente;

- protocolli per la distribuzione di entanglement a distanza, mantenendo la qualità degli stati quantistici.

Dal punto di vista di rete, Cisco sta sviluppando un framework di protocolli software ad alta velocità che possa riconfigurare in maniera continua e dinamica i percorsi di rete in modo che le risorse di entanglement vengano distribuite ai vari QNU nel momento esatto in cui ciascun nodo termina le sue porzioni di calcolo. In altre parole, la rete diventa “consapevole” dello stato dei calcoli quantistici in corso e si adatta per supportarli.

Il bridge di rete: connettere decine di QPU dentro (e fuori) il data center

Per trasformare questa architettura in qualcosa di praticabile IBM e Cisco prevedono di lavorare su un network bridge composto da nuovo hardware e software open source. Questo bridge utilizzerà nodi di rete quantistici Cisco per collegare numerose QPU IBM all’interno di un data center, sfruttando l’interfaccia QNU.

In futuro, lo stesso approccio potrà essere esteso per collegare QPU residenti in più data center, creando una rete quantistica distribuita su distanze molto maggiori. In prospettiva, questo è il tassello chiave che apre la strada a un vero internet del calcolo quantistico: non più un singolo cluster, ma una costellazione di data center quantistici interconnessi.

All’interno di questa architettura, i computer quantistici IBM collegati alla rete potrebbero affrontare carichi di lavoro estremamente intensivi, che richiedono non solo risorse quantistiche distribuite, ma anche l’integrazione stretta con sistemi di high-performance computing classici. È esattamente il modello di quantum-centric supercomputing che IBM ha iniziato a delineare con piattaforme come IBM Quantum System Two, e che qui viene portato a livello di rete globale.

Partner, centri di ricerca e roadmap intermedie

Per arrivare a un internet quantistico serve una quantità di ricerca di base e sviluppo tecnologico che va oltre le capacità di una singola azienda. Non a caso IBM sta lavorando in parallelo con il Superconducting Quantum Materials and Systems Center (SQMS), guidato dal Fermi National Accelerator Laboratory, nell’ambito dei National Quantum Information Science and Research Centers del Dipartimento dell’Energia degli Stati Uniti.

In questo contesto, IBM e SQMS intendono studiare come utilizzare un numero elevato di QNU all’interno di data center quantistici e pianificano, entro i prossimi tre anni, una prima dimostrazione di più QPU connesse tra loro. Si tratta di una tappa intermedia importante: un banco di prova per protocolli, hardware di interfaccia e software di orchestrazione, prima di estendere la rete su scala geografica.

Parallelamente, IBM e Cisco prevedono di co-finanziare ricerca accademica e progetti collaborativi per far crescere l’ecosistema quantistico in senso lato. La storia delle due aziende, entrambe abituate a lavorare con università e laboratori nazionali, suggerisce che una parte significativa dell’innovazione necessaria arriverà proprio da questi partner.

Che cos’è, in concreto, un internet del calcolo quantistico

La visione di lungo periodo si traduce in un concetto semplice da descrivere, ma complesso da realizzare: un internet quantistico è una rete in cui diverse tecnologie quantistiche – computer, sensori, sistemi di comunicazione – sono collegate e condividono informazioni quantistiche su grandi distanze, inizialmente su scala metropolitana e, in prospettiva, planetaria.

In uno scenario del genere, un internet quantistico potrebbe abilitare:

- comunicazioni ultra-sicure basate su principi quantistici, intrinsecamente resistenti a molte forme di intercettazione;

- reti di sensori quantistici distribuiti per il monitoraggio ad altissima precisione di fenomeni climatici, meteorologici e sismici;

- forme avanzate di sincronizzazione e di distribuzione del tempo, essenziali per infrastrutture critiche;

- nuove applicazioni ancora difficili da immaginare, nate dall’intreccio tra calcolo quantistico, sensing e comunicazioni.

IBM e Cisco collocano la realizzazione di questa visione su un orizzonte che arriva alla fine degli anni ’30, ma i primi passi concreti – proof-of-concept di rete, collegamento tra QPU in data center diversi, primi prototipi di quantum data center – sono attesi già entro questo decennio.