Alla conferenza MAX, Adobe alza l’asticella sull’integrazione tra modelli generativi, strumenti professionali e agentic AI, con un messaggio chiaro: mettere l’intelligenza artificiale al servizio di ogni creator e di ogni fase della content supply chain. Il risultato è un ecosistema coerente che tocca le aree chiave di ideazione, creazione, produzione e attivazione, grazie a tre direttrici principali: nuovi modelli Firefly e partner integrati direttamente nelle app, assistenti conversazionali che operano come agenti contestuali dentro gli strumenti creativi e funzionalità enterprise per scalare contenuti on-brand. In apertura, David Wadhwani ha sintetizzato la visione con una cornice valoriale che resta centrale per il brand: “la nostra AI è fatta per creare e costruita per chi dipinge il mondo con la propria immaginazione”.

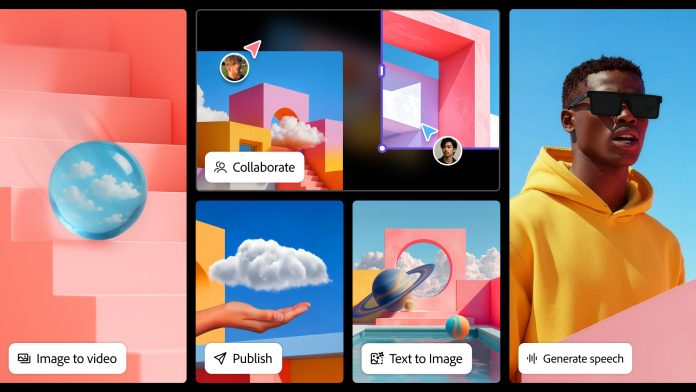

Firefly diventa uno studio creativo all-in-one: modelli di nuova generazione e un editor video timeline

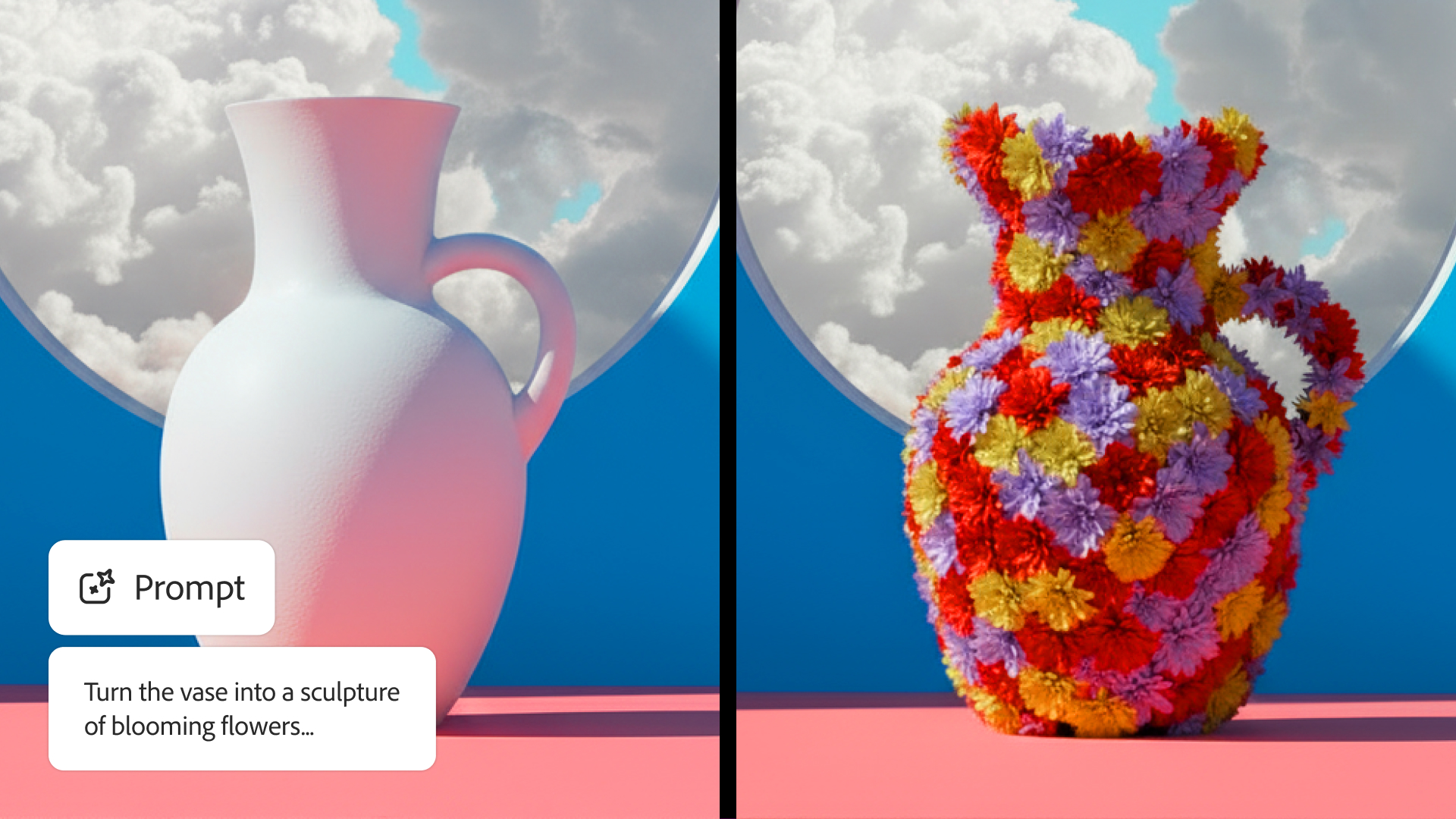

Il cuore dell’offerta consumer e pro è Firefly, che evolve in studio completo capace di generare, editare e pubblicare attraverso modelli proprietari e di partner. Il nuovo Firefly Image Model 5, in public beta, porta la risoluzione nativa a 4MP senza upscaling, con un salto tangibile in fotorealismo, resa anatomica dei ritratti e coerenza su composizioni multi-livello e movimenti naturali. L’integrazione di “Prompt to Edit” fonde generazione ed editing in un unico flusso: l’utente descrive in linguaggio naturale l’intervento desiderato e il modello applica modifiche istruzionali mantenendo l’armonia visiva.

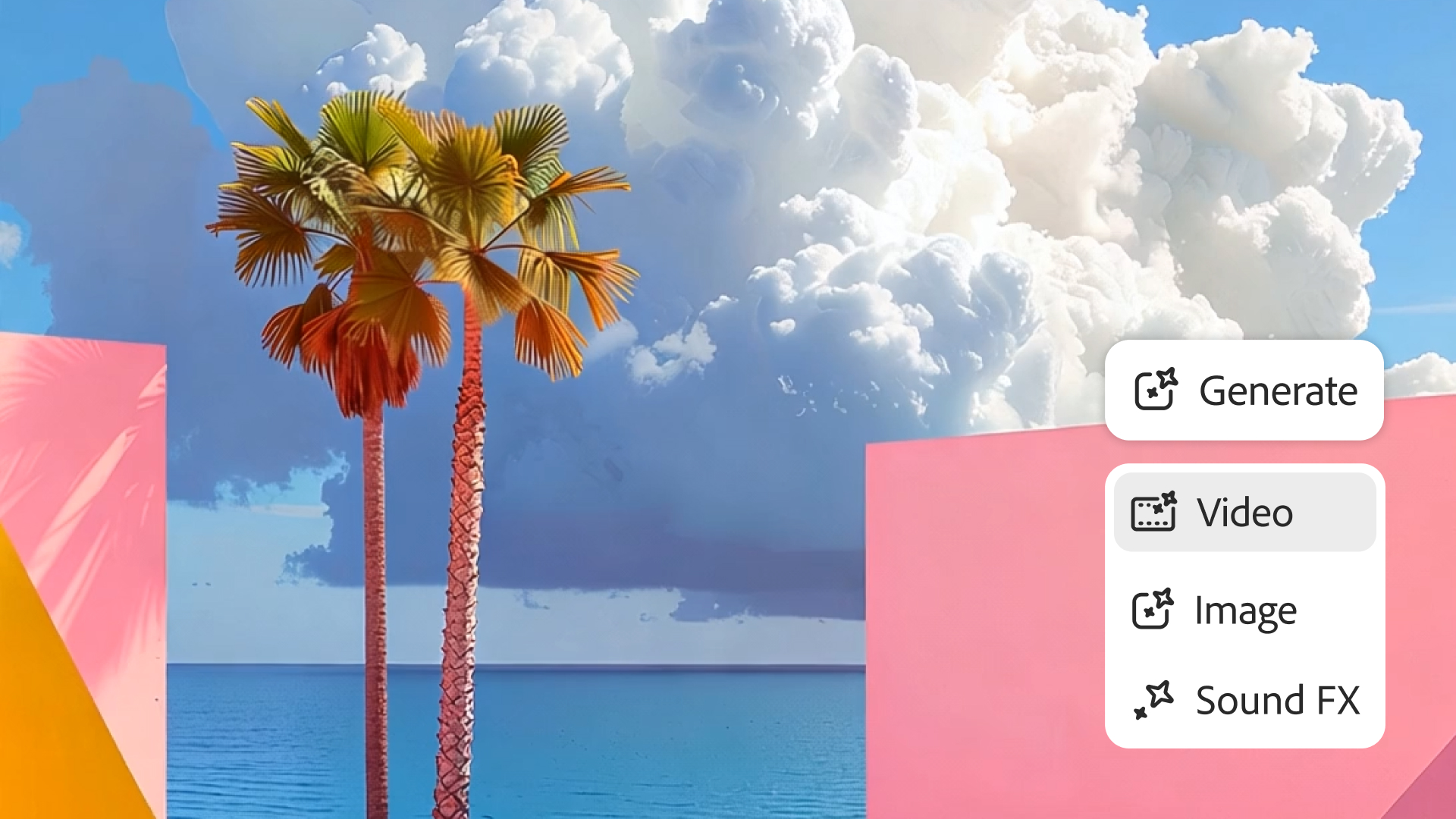

La novità più attesa per i flussi audiovisivi è l’ingresso dell’editing end-to-end in Firefly. “Generate Soundtrack”, alimentato dal modello audio Firefly e da librerie completamente licenziate, compone in pochi secondi tracce originali sincronizzate ai video. “Generate Speech” crea voice-over limpidi con voci multilingua regolabili in tono, ritmo ed enfasi, attingendo al Firefly Speech Model e alle tecnologie ElevenLabs. Il nuovo editor video timeline, oggi in private beta, introduce una multitraccia web-based con sequenziamento, trimming e compositing, accesso diretto alle generazioni salvate, preset di stile e titoli personalizzabili, oltre alla possibilità di caricare media proprietari per unire girato e contenuti generativi in un’unica regia.

Dall’ideazione alla pre-produzione: Firefly Boards accelera brainstorming, varianti e handoff

Sul fronte dell’ideazione, Firefly Boards estende il perimetro collaborativo con funzioni che anticipano il bisogno di controllo visivo. La nuova rotazione di oggetti consente di trasformare immagini 2D in elementi posizionabili e ruotabili per esplorare prospettive e pose. Esportazione in PDF e download massivo semplificano condivisione e versioning, mentre preset di stile e generazione testuale all’interno degli asset riducono il tempo tra moodboard e primo concept. L’obiettivo è chiudere il gap tra brainstorming e pre-produzione con un canvas che collega direzione creativa e asset concreti.

Creative Cloud: più potenza, più controllo e più automazione nei tool di riferimento

La release Creative Cloud introduce un’infusione massiva di AI mirata alla precisione a livello di pixel e al risparmio di tempo in flussi professionali reali. In Photoshop, Generative Fill guadagna una scelta di modelli di punta – dai Firefly Image Models a Gemini 2.5 Flash Image e FLUX.1 Kontext – per edit istruzionali coerenti e controllabili. “Generative Upscale”, potenziato dalla tecnologia Topaz, porta immagini piccole o ritagliate fino al 4K con dettaglio credibile, mentre “Harmonize” gestisce l’inserimento di oggetti e persone in ambienti diversi, adeguando luci, colore e tono per un compositing naturale.

In Premiere, “AI Object Mask” identifica e isola automaticamente persone e oggetti frame-by-frame, facilitando color grading selettivo, sfocature e VFX senza rotoscopia manuale. Nuove maschere geometriche e un “Fast Vector Mask” riprogettato accelerano il tracking, incluso quello bidirezionale e in prospettiva 3D. In Lightroom, “Assisted Culling” introduce filtri intelligenti su fuoco, angolazioni e nitidezza per velocizzare la selezione in grandi collezioni. Il pacchetto arriva con oltre cento migliorie tra performance e UX, includendo automatismi molto richiesti anche in InDesign e Illustrator.

Assistenti conversazionali e agentic AI: dall’azione singola all’orchestrazione multi-app

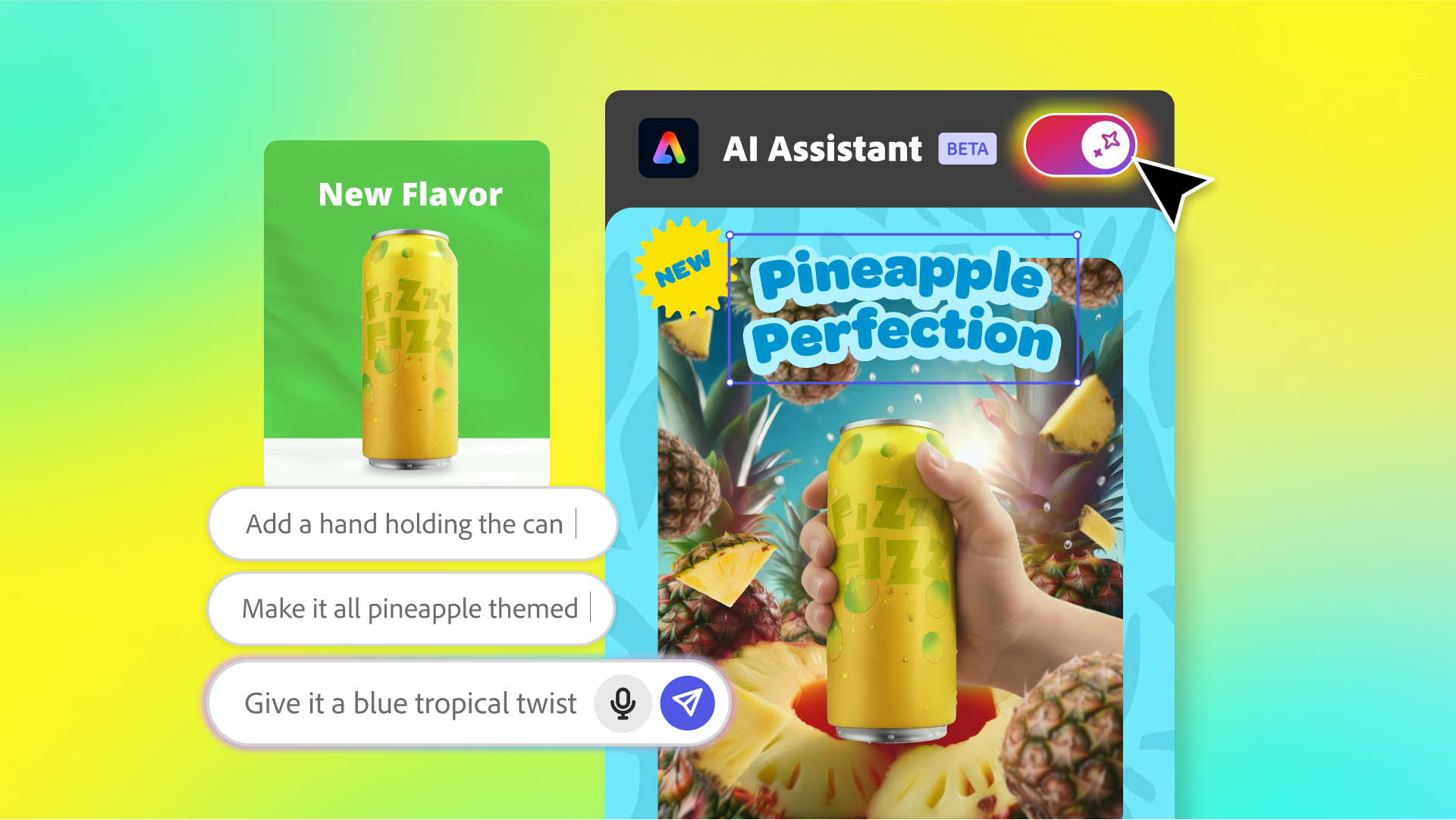

La seconda direttrice è l’arrivo di assistenti alimentati da agentic AI direttamente dentro le app. In Express debutta un AI Assistant in beta, capace di comprendere il contesto di layout, livelli e stile per trasformare i template in tele conversazionali. L’utente può chiedere modifiche vaghe o stilistiche – per esempio “rendilo più tropicale” – e l’assistente risponde sostituendo elementi e proponendo regolazioni pertinenti, fino a suggerire in modo proattivo adattamenti tipografici coerenti.

In Photoshop, l’AI Assistant in private beta sul web si comporta come un compagno operativo: esegue serie di task ripetitivi, propone raccomandazioni personalizzate e guida passaggi complessi, lasciando al professionista il pieno controllo con uno switch immediato tra chat e strumenti manuali. Sullo sfondo, Adobe svela “Project Moonlight”, un’orchestrazione che agisce da meta-assistente collegando librerie Creative Cloud e canali social per portare un’unica intelligenza contestuale dall’ideazione alla pubblicazione, con capacità di analisi prestazionale e suggerimenti strategici per la crescita delle audience.

Modelli partner e Firefly Custom Models: scelta, flessibilità e coerenza stilistica

La terza direttrice riguarda la pluralità dei modelli. Dentro Firefly e nelle app Creative Cloud entrano, oltre ai Firefly Models, modelli di partner come Black Forest Labs, Google, Luma AI, OpenAI, Runway, Ideogram, Pika, Moonvalley e altri, con novità come ElevenLabs Multilingual v2 per i voice-over e Topaz Bloom per l’upscaling. La possibilità di selezione “best model for the job” diventa un principio di progettazione dell’esperienza.

Per la coerenza visiva di serie e campagne, Adobe porta ai creator i Firefly Custom Models in private beta direttamente nell’app Firefly. Il training è pensato per essere semplice e sicuro: si trascinano immagini e asset di cui si detengono i diritti e si ottiene un modello privato che replica stile e scelte estetiche volute, utilizzabile anche in Boards per un’ideazione già “on-brand”. L’autorizzazione è esplicita e controllata da chi crea il modello.

GenStudio e Firefly Foundry: la catena del valore enterprise tra scala, governance e performance

Sul versante enterprise, GenStudio evolve per rispondere alla pressione di domanda che supera le risorse interne. L’app per il Performance Marketing introduce un Content Production Agent in beta in grado di interpretare briefing e generare varianti per canali diversi allineate a obiettivi e brand guidelines, mentre Firefly Creative Production per Enterprise espande il batch editing web con builder di workflow riutilizzabili, integrazioni con Experience Manager Assets e Frame.io e un set di azioni generative e creative che includono controlli di brand safety e compositing.

La novità più strategica è Firefly Foundry, il programma con cui Adobe co-progetta con le aziende modelli generativi privati, profondamente sintonizzati su cataloghi IP proprietari e costruiti sopra i modelli Firefly commercialmente sicuri. Foundry non è solo infrastruttura e training: prevede un team Adobe dedicato con scienziati applicati e ingegneri “forward-deployed” per aiutare a definire use case ad alto impatto, orchestrare l’implementazione, testare la qualità e governare accessi e rollout. L’obiettivo è coniugare precisione creativa, tutela del brand e ROI misurabile, portando output multimodali pronti per campagne, media production e contenuti esperienziali.

Attivazione e misurazione: integrare l’ultimo miglio con i partner media e advertising

GenStudio per il Performance Marketing si arricchisce di integrazioni operative con i principali partner di attivazione e misurazione. Oggi sono disponibili attivazioni dirette per display su Amazon Ads e flussi di esportazione e insight con LinkedIn Campaign Manager, mentre arrivano in beta funzionalità con Innovid per display e, a breve, con Google Campaign Manager 360 per il video. Su TikTok sono in arrivo creazione, attivazione e insight per annunci immagine e video. L’idea è unire creazione e consegna con un circuito chiuso di feedback per ottimizzare la creatività dati alla mano.

Partnership con YouTube: Premiere mobile come corsia preferenziale per gli Shorts

In ottica creator economy, Adobe e YouTube annunciano una partnership che mette la produzione di Shorts al centro dell’esperienza mobile. Dentro Premiere mobile nasce uno spazio dedicato alla creazione e pubblicazione immediata su YouTube Shorts, con effetti, transizioni e preset pensati per il formato, titoli e template riutilizzabili, generazione di asset con Firefly e sound design con effetti sonori generativi. Dal flusso di YouTube si potrà saltare direttamente in “Edit in Adobe Premiere”, con un tap per condividere il risultato finale, accorciando il time-to-publish dal girato allo scaffale pubblico.

Pricing, disponibilità e limiti di generazione: cosa si può usare oggi

Le funzionalità disponibili immediatamente includono Generative Fill con Partner Models, Generative Upscale e Harmonize in Photoshop, le nuove maschere e Object Mask in beta in Premiere e Assisted Culling in beta in Lightroom. In Firefly è generalmente disponibile “Prompt to Edit” con Image Model 5 e modelli partner, mentre Image Model 5, Generate Soundtrack e Generate Speech sono in public beta. Il video editor di Firefly e i Firefly Custom Models sono in private beta con rollout dal mese prossimo e accesso tramite waitlist, così come Firefly Creative Production per clienti con funzionalità generative premium. Fino al 1° dicembre, i piani Creative Cloud Pro e Firefly offrono generazioni illimitate di immagini con tutti i modelli supportati e generazioni video illimitate con il Firefly Video Model, con meccanismi di credito generativo che resteranno parte dell’esperienza a regime.

Un approccio dichiarato: AI al servizio delle persone, con sicurezza commerciale e diritti dei creator

Adobe ribadisce una posizione costante sulla responsabilità dell’AI generativa, sulla sicurezza commerciale dei modelli Firefly e sul rispetto dei diritti d’autore. La trasparenza sugli asset di training, l’adozione di credenziali di contenuto verificabili e il principio di “AI che amplifica, non sostituisce” guidano tanto l’offerta consumer quanto i programmi enterprise come Foundry. È una strategia che vuole tenere insieme tre esigenze spesso difficili da conciliare: velocità, qualità e tutela del brand.

Cosa cambia per creator e aziende: tre impatti immediati

Per i creator individuali, Firefly come studio all-in-one e gli assistenti conversazionali dentro Express e Photoshop riducono drasticamente l’attrito tra idea e prima bozza, senza rinunciare al controllo fine in fase di rifinitura. Per i professionisti, la combinazione tra scelta di modelli, editing a livello di pixel e automazioni intelligenti nei tool di riferimento consente di assorbire meglio il picco di domanda di contenuti senza compromettere coerenza e qualità. Per le imprese, GenStudio e Foundry offrono un percorso concreto dalla sperimentazione al valore, con modelli privati addestrati su IP proprietario e integrazioni che chiudono il cerchio tra produzione e distribuzione multicanale.

Dall’AI che genera all’AI che orchestra

MAX 2025 segna il passaggio dall’AI come motore di singole funzioni all’AI come sistema operativo della creatività e del marketing. La promessa non è soltanto generare immagini migliori o tagliare tempi in timeline più rapide, ma orchestrare l’intero ciclo di vita del contenuto con agenti che capiscono obiettivi, stile e contesto. In questo scenario, la differenza la fanno interoperabilità, governance e qualità coerente su larga scala. È su questi tre assi che Adobe prova a disegnare, oggi, il prossimo standard dell’industria creativa.