Red Hat prosegue nel percorso di innovazione verso un’intelligenza artificiale sempre più operativa e scalabile con il lancio di Red Hat AI 3, l’evoluzione della piattaforma enterprise che unisce Red Hat AI Inference Server, Red Hat Enterprise Linux AI (RHEL AI) e Red Hat OpenShift AI. L’obiettivo è semplificare i flussi di lavoro e permettere alle aziende di passare con rapidità e sicurezza dalla sperimentazione alla produzione, ottimizzando i costi e migliorando la collaborazione tra team e infrastrutture.

In un contesto in cui molte organizzazioni faticano ancora a trarre benefici tangibili dagli investimenti in AI, Red Hat propone una piattaforma unificata, basata su standard aperti, che risponde alle esigenze di interoperabilità e governance dei dati nei diversi ambienti, dal data center al cloud pubblico fino all’edge. L’AI distribuita e cloud-native è oggi una priorità strategica per chi vuole costruire valore concreto dai modelli linguistici di grandi dimensioni e dalle applicazioni agentiche, sottolinea l’azienda.

Dalla formazione all’inferenza: il cuore operativo dell’AI

Con l’avanzare dei progetti di intelligenza artificiale in produzione, le aziende spostano il baricentro dal training all’inferenza, ossia la fase in cui i modelli vengono effettivamente utilizzati per generare valore. Red Hat AI 3 nasce per affrontare questa transizione, offrendo un’infrastruttura scalabile, efficiente e nativamente integrata con Kubernetes.

Fulcro di questa evoluzione è llm-d, una tecnologia che reinventa il modo di eseguire inferenza distribuita su Kubernetes. Basata sul progetto open source vLLM, llm-d trasforma un motore di inferenza a nodo singolo in un sistema distribuito ad alte prestazioni, capace di sfruttare pienamente le risorse hardware disponibili e garantire prestazioni prevedibili, maggiore efficienza e ROI misurabile. L’integrazione con componenti chiave come NVIDIA NIXL e DeepEP MoE permette di supportare modelli complessi, inclusi i Mixture-of-Experts, con un approccio disaggregato e multi-vendor.

Secondo Red Hat, questa architettura consente alle imprese di ridurre i costi di calcolo, semplificare le operazioni e ottenere la massima flessibilità nel distribuire modelli LLM su diversi acceleratori, da NVIDIA ad AMD.

Un’unica piattaforma per la collaborazione sull’AI

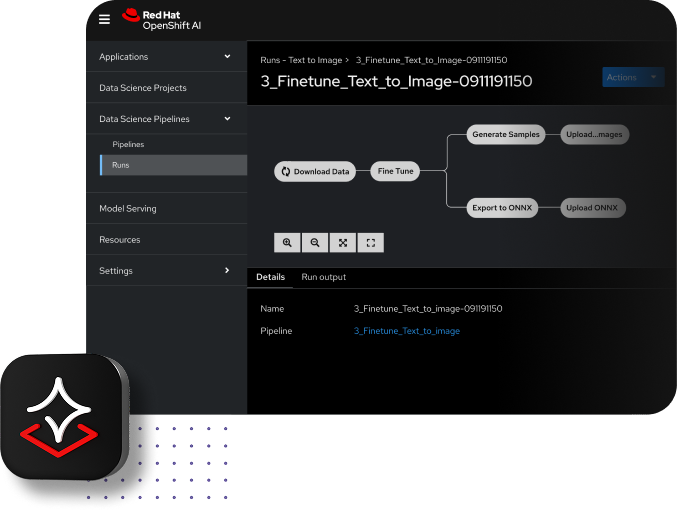

Red Hat AI 3 estende il paradigma della piattaforma unificata introducendo nuovi strumenti progettati per favorire la collaborazione tra sviluppatori, data scientist e team IT. Tra le novità, spiccano le funzionalità Model as a Service (MaaS), che consentono di gestire modelli centralizzati e offrirli on demand agli utenti interni, garantendo controllo sui costi e sicurezza dei dati.

Red Hat AI 3 estende il paradigma della piattaforma unificata introducendo nuovi strumenti progettati per favorire la collaborazione tra sviluppatori, data scientist e team IT. Tra le novità, spiccano le funzionalità Model as a Service (MaaS), che consentono di gestire modelli centralizzati e offrirli on demand agli utenti interni, garantendo controllo sui costi e sicurezza dei dati.

L’hub AI integrato offre un catalogo curato di modelli convalidati, un registro per il ciclo di vita dei modelli e un ambiente di implementazione gestito su OpenShift AI. A ciò si aggiunge Gen AI Studio, un ambiente interattivo in cui gli ingegneri possono prototipare rapidamente applicazioni generative, sperimentare prompt e ottimizzare parametri per casi d’uso come chat e retrieval-augmented generation. L’obiettivo è portare l’AI generativa dallo sviluppo alla produzione con strumenti aperti e integrati, mantenendo al contempo una governance solida.

Il catalogo di modelli ottimizzati da Red Hat comprende anche soluzioni open source come gpt-oss, DeepSeek-R1, Whisper per la trascrizione vocale e Voxtral Mini per agenti vocali, semplificando ulteriormente l’adozione di applicazioni basate su AI multimodale.

Con Red Hat AI 3, offriamo una piattaforma open source di livello enterprise che riduce al minimo gli ostacoli operativi, afferma Joe Fernandes, vice president e general manager AI Business Unit di Red Hat. Grazie all’inferenza distribuita con llm-d e a una base per l’AI agentica, aiutiamo le organizzazioni a operare con maggiore sicurezza, secondo le proprie esigenze e su qualsiasi infrastruttura.

Le fondamenta dell’AI agentica

Guardando al futuro, Red Hat OpenShift AI 3.0 pone le basi per la prossima generazione di agenti intelligenti, sistemi autonomi in grado di coordinare attività complesse e prendere decisioni in tempo reale. Per abilitare questa evoluzione, Red Hat introduce un livello API unificato basato su Llama Stack, compatibile con standard come OpenAI, e adotta il Model Context Protocol (MCP), emergente riferimento per l’interoperabilità tra modelli e strumenti esterni.

A supporto degli sviluppatori, la piattaforma include un toolkit modulare ed estensibile per la personalizzazione dei modelli, basato sulle funzionalità di InstructLab. Le nuove librerie Python e i progetti open source come Docling semplificano l’elaborazione di dati non strutturati e la generazione di dataset sintetici, mentre un hub di valutazione integrato consente di monitorare la qualità e l’affidabilità dei risultati. Questo approccio, spiega l’azienda, permette di sfruttare i dati proprietari in modo sicuro e di ottenere inferenze più precise e contestualmente rilevanti.

Con Red Hat AI 3, la società rafforza la propria visione di un ecosistema aperto, collaborativo e scalabile, capace di supportare il nuovo ciclo di vita dell’intelligenza artificiale: dalla formazione all’inferenza, fino agli agenti autonomi del futuro.