Con il nuovo Ascent GX10, Asus entra nel segmento emergente dei personal AI supercomputer: sistemi compatti progettati per offrire capacità di calcolo su scala petaFLOP in formato desktop.

L’obiettivo è chiaro: portare la potenza delle architetture NVIDIA Grace Blackwell nei laboratori di sviluppo, nei centri di ricerca e persino negli uffici tecnici, dove la possibilità di addestrare o ottimizzare modelli AI in locale sta diventando un’esigenza concreta per ragioni di sicurezza, latenza e controllo dei costi.

Architettura e potenza computazionale

Il cuore del sistema è il superchip NVIDIA GB10 Grace Blackwell, un’unità che fonde su un unico die una CPU ARM v9.2-A Grace a 20 core e una GPU Blackwell, connessi tramite NVLink-C2C, che fornisce un modello di memoria coesivo CPU+GPU con una larghezza di banda cinque volte superiore a quella di PCIe 5.0, eliminando il tradizionale collo di bottiglia tra CPU e GPU, consentendo la condivisione diretta dei dati e riducendo sensibilmente la latenza di inferenza e training.

Grazie a questo approccio, Ascent GX10 raggiunge fino a 1 petaFLOP di potenza AI in un volume di appena 150 × 150 × 51 mm. Le prestazioni lo avvicinano a quelle di un server rack dedicato, ma con un consumo energetico notevolmente inferiore e una gestione termica 1,6 volte più efficiente rispetto ai sistemi compatti di generazione precedente.

La memoria unificata LPDDR5x da 128 GB garantisce una banda di comunicazione ad alta coerenza, permettendo di gestire modelli fino a 200 miliardi di parametri — un traguardo che apre la strada a scenari di fine-tuning e inferenza di modelli multimodali, come i Vision-Language Models (VLM) o le reti neurali per robotica avanzata.

Il design scalabile del GX10 consente inoltre di collegare due unità tramite interfacce NVIDIA ConnectX-7, raddoppiando la potenza a 2 petaFLOP e portando la memoria complessiva a 256 GB. È, di fatto, un micro-cluster personale, in grado di eseguire simultaneamente pipeline di training, validazione e inferenza in un ambiente completamente locale.

Software e integrazione con l’ecosistema NVIDIA

Dal punto di vista software, il GX10 adotta la piattaforma NVIDIA DGX OS e l’ambiente NVIDIA AI Software Stack, una combinazione che replica in scala ridotta l’infrastruttura dei sistemi DGX impiegati nei data center.

Questo approccio “full-stack” permette di utilizzare in modo nativo framework e toolkit come NVIDIA TensorRT, per l’ottimizzazione e l’inferenza dei modelli o NVIDIA NeMo e Triton Inference Server, per la gestione e l’esecuzione di modelli linguistici e multimodali oltre a NVIDIA AI Enterprise, per orchestrare i carichi di lavoro su cluster locali o ibridi.

L’integrazione nativa riduce i tempi di configurazione e consente di mantenere la consistenza operativa tra ambienti cloud e on-premise, un aspetto cruciale per i team che desiderano validare localmente i modelli prima del deployment in produzione.

Inoltre, la compatibilità con la suite CUDA-X e PyTorch assicura interoperabilità con le pipeline di sviluppo esistenti, rendendo il GX10 adatto anche come nodo sperimentale in infrastrutture distribuite.

Efficienza termica e ingegnerizzazione meccanica

Per GX10 Asus ha progettato un sistema di raffreddamento a doppia ventola con cinque heat pipe e controllo della velocità su sette livelli, in grado di adattarsi automaticamente ai carichi computazionali senza penalizzare le prestazioni o generare rumore eccessivo.

Le ventole da 140×80 mm, disposte in configurazione push-pull, aspirano aria dal fondo e la convogliano verso l’alto, creando un flusso verticale che mantiene temperature uniformi anche durante carichi di training prolungati.

È una soluzione più vicina alla filosofia dei server edge che non a quella dei PC consumer, segno della convergenza tra il mondo del personal computing e quello dell’HPC.

Configurazioni di storage e connettività

Asus propone tre configurazioni di archiviazione, differenziate per capacità e interfaccia:

- 1 TB PCIe 4.0 x4 per applicazioni di test e prototipazione;

- 2 TB PCIe 4.0 x4 per ambienti di sviluppo con dataset medi;

- 4 TB PCIe 5.0 x4 per workload su larga scala o modelli multipli in esecuzione parallela.

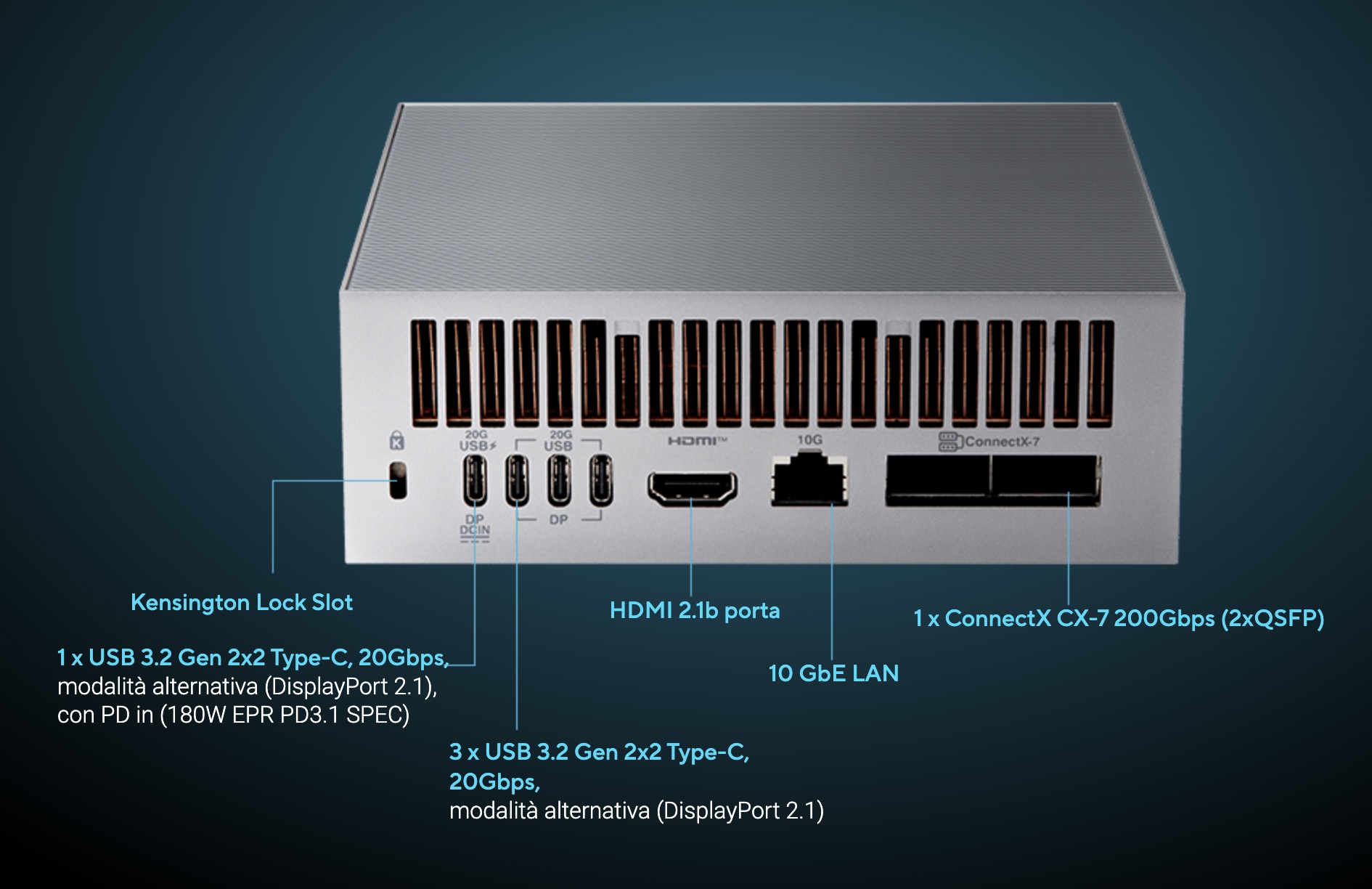

La connettività è completa: Wi-Fi 7 (Gig+), Bluetooth 5, una porta LAN 10 Gbps, tre USB 3.2 Gen 2×2 Type-C da 20 Gbps e una HDMI 2.1.

L’alimentazione via USB-C PD 3.1 EPR (fino a 240 W) garantisce compatibilità con alimentatori compatti e setup mobili, rendendo il sistema idoneo anche per ambienti di ricerca portatili o dimostrativi.

Tra edge AI e cloud ibrido

L’Ascent GX10 non è un prodotto di nicchia, ma parte di una strategia coerente di estensione dell’AI computing verso l’edge.

Asus sta progressivamente costruendo un portafoglio che va dalle infrastrutture basate su NVIDIA HGX e GB300 NVL72 ai sistemi MGX Server Edition con GPU RTX PRO 6000, fino a soluzioni desktop come il GX10.

Questa diversificazione riflette una tendenza del mercato: le organizzazioni non vogliono più scegliere solo tra cloud e data center, ma adottare modelli ibridi o distribuiti, in cui i dati sensibili restano in locale e le elaborazioni vengono eseguite in prossimità delle fonti informative.

Per Asus, la sfida è duplice, sia tecnologica, nel garantire che un sistema compatto mantenga coerenza prestazionale con le piattaforme enterprise, sia commerciale, nel posizionare il GX10 come soluzione economicamente sostenibile per laboratori, università e PMI che operano nel campo dell’AI applicata.

Il valore aggiunto risiede nella riduzione della barriera d’ingresso al calcolo AI. Un laboratorio di ricerca o una software house possono accedere a potenza di calcolo tradizionalmente riservata a infrastrutture costose, mantenendo però pieno controllo su privacy e compliance (GDPR, data sovereignty).

I segmenti di utilizzo e le prospettive di adozione

I potenziali scenari di impiego del GX10 si collocano su tre livelli: ricerca accademica e scientifica, dove la possibilità di addestrare o riaddestrare modelli AI su dati riservati è cruciale. Il GX10 consente di simulare ambienti di training cloud in locale, riducendo la dipendenza da servizi esterni; sviluppo industriale e manifatturiero: le aziende che utilizzano AI per controllo qualità, visione artificiale o manutenzione predittiva possono eseguire l’inferenza direttamente vicino ai macchinari, sfruttando la latenza ridotta; AI generativa e design computazionale. Studi di progettazione e team di sviluppo software possono sfruttare il sistema per l’esecuzione di modelli linguistici o di generazione immagini, mantenendo i dataset proprietari in-house.

Nel medio termine, sistemi come il GX10 potrebbero rappresentare la base di un ecosistema edge collaborativo, in cui nodi locali scambiano parametri o modelli parziali senza mai trasferire i dati originali – una delle visioni più promettenti dell’AI distribuita.

Le specifiche

| Componente | Caratteristiche |

| CPU | NVIDIA Grace 20 core (ARM v9.2-A) |

| GPU | NVIDIA Blackwell (GB10 integrata) |

| Memoria | 128 GB LPDDR5x unificata |

| Prestazioni AI | fino a 1 petaFLOP |

| Storage | fino a 4 TB NVMe PCIe 5.0 |

| Rete | ConnectX-7, 10G LAN, Wi-Fi 7, Bluetooth 5 |

| Sistema operativo | NVIDIA DGX OS con AI Software Stack |

| Dimensioni / Peso | 150 × 150 × 51 mm / 1,48 kg |