Rilasciato da OpenAI all’inizio di agosto, gpt-oss è una famiglia di modelli linguistici open-weight all’avanguardia che è possibile eseguire anche localmente su un Mac, in modo semplice, grazie a un’applicazione come LM Studio.

O meglio: gpt-oss-20b, la variante da 20B, altamente compatta ed efficiente, con soli 3,6 miliardi di parametri attivi alla volta e grazie alla quantizzazione MXFP4 nativa per il livello MoE è in grado di operare su sistemi desktop con 16 GB di memoria, spiega il team: anche se, per un’esperienza ottimale, è solitamente consigliato un quantitativo di almeno 24 o 32 GB.

Anche la variante gpt-oss-120b, è molto efficiente in proporzione alle sue capacità: funziona con 5,1 miliardi di parametri attivi per token, grazie all’architettura a Mixture-of-Experts (MoE), e può funzionare anche su una singola GPU, però richiede una GPU della fascia ad esempio di una NVIDIA H100 con 80 GB di VRAM.

Cos’è LM Studio e a cosa serve

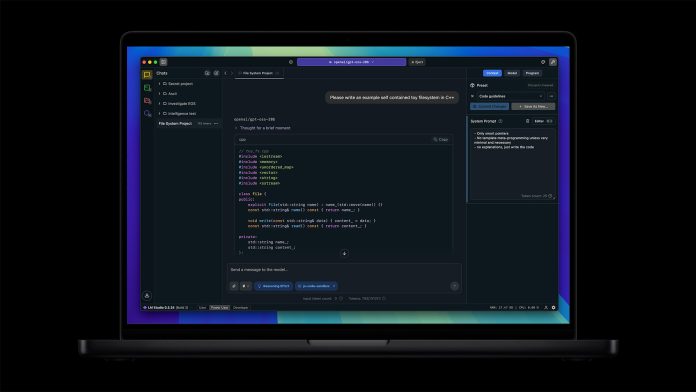

LM Studio è un’applicazione multipiattaforma disponibile per macOS, Windows e Linux, progettata per scaricare ed eseguire localmente modelli linguistici di grandi dimensioni (LLM, Large Language Model) in un’interfaccia user-friendly simile a ChatGPT, direttamente sul proprio computer. Per evidenziare le prestazioni dei chip della famiglia M4 di cui sono dotati gli ultimi MacBook Pro e Mac Studio, Apple ha utilizzato proprio LM Studio per i benchmark sull’utilizzo degli LLM.

In sostanza, LM Studio consente di utilizzare potenti modelli di intelligenza artificiale open source – quali Llama di Meta, DeepSeek, Gemma di Google e, ora, anche gpt-oss di OpenAI – senza bisogno di connettersi a servizi cloud esterni. Tutte le operazioni avvengono in locale, una volta scaricato e installato il modello, e ciò garantisce maggiore privacy e controllo sui dati, poiché le conversazioni e i prompt rimangono sul computer dell’utente e non vengono inoltrati a server remoti.

Lo stesso team che sviluppa l’applicazione sottolinea che uno dei motivi principali per cui si ricorre a un LLM locale è per l’appunto la privacy e LM Studio è stato progettato proprio per questo. Per le sue funzionalità core, LM Studio non richiede alcuna connessione a Internet per operare. Determinate opzioni di utilità – tra cui ad esempio la ricerca e il download dei modelli – richiedono invece la connessione a server esterni. Nella documentazione online, sono descritte le operazioni che non richiedono alcuna connessione e quelle che invece lo richiedono.

LM Studio consente di utilizzare i principali modelli LLM open e si basa su alcuni componenti software open source, ma in sé non è un’applicazione open source. Il suo utilizzo è comunque gratuito, non solo a casa ma – dopo una recente modifica ai termini di utilizzo – anche al lavoro. L’azienda che sviluppa e mantiene LM Studio, Element Labs, oltre al piano personale gratuito, denominato Community, ne offre anche uno Enterprise, commerciale, ideato per grandi aziende o organizzazioni che necessitano di controlli di amministrazione, implementazioni custom e assistenza. È da poco disponibile anche un piano Teams, intermedio tra i due.

Intelligenza artificiale su desktop, resa semplice

Intelligenza artificiale su desktop, resa semplice

Installare e configurare i componenti che consentono di eseguire e gestire in locale gli LLM non è necessariamente un’operazione semplice e fluida per tutti. LM Studio nasce per semplificare l’accesso ai large language model aperti più avanzati, rendendoli fruibili anche a chi non ha competenze di machine learning o non vuole usare il terminale, compilare, configurare l’ambiente e così via.

LM Studio agisce da ponte operativo tra gli strumenti di inferenza open source e l’utente finale: automatizza l’installazione dei componenti necessari per eseguire i modelli (engine, dipendenze e pesi) e aggiunge un layer d’interfaccia grafica intuitiva che orchestra download, caricamento e chat con un semplice clic.

L’app presenta inoltre una sezione che semplifica e velocizza la ricerca e il download da Hugging Face degli LLM supportati, oltre a una selezione di modelli selezionati dallo staff. Per questi motivi può essere adatta sia per scenari personali che professionali, a maggior ragione per il fatto di essere gratuita per uso privato e per lavoro (senza le feature aziendali e per team), permettendo anche alle organizzazioni di testare LLM localmente, senza costi eccessivi o necessità di abbonamenti cloud, almeno in una prima fase sperimentale, per poi scalare le proprie implementazioni AI in base alle esigenze.

LM Studio può dunque essere utile per esplorare l’AI in locale – che sia per creare un assistente tipo ChatGPT personalizzato, provare modelli di generazione di codice, o semplicemente comprendere come funzionano gli LLM – il tutto con una interfaccia facile da usare e tempi di configurazione minimi.

Installazione di LM Studio su Mac e requisiti di sistema

Come abbiamo visto anche nel nostro articolo su come usare Ollama per macOS, eseguire gli LLM in locale è un task estremamente impegnativo per un computer. Prima di installare LM Studio sul Mac, è quindi importante verificare che il proprio sistema soddisfi i requisiti minimi. LM Studio supporta ufficialmente solo i Mac con chip Apple Silicon (M1, M2, M3, M4, al momento in cui scriviamo) e richiede macOS 13.4 o successivo (macOS 14 o superiore per sfruttare appieno le funzionalità avanzate, con i modelli MLX). Quindi, diversamente da quanto accade per Ollama, almeno al momento i Mac con processore Intel non sono supportati.

Sempre dal punto di vista hardware, è consigliato un quantitativo di memoria RAM di almeno 16 GB per avere un po’ più di flessibilità. Su Mac con 8 GB è comunque possibile utilizzare LM Studio, spiega il team, ma conviene limitarsi a modelli di dimensioni ridotte e con contesti meno estesi, per evitare rallentamenti o esaurimento della memoria. Anche lo spazio su disco non va trascurato: i file dei modelli LLM possono pesare svariati gigabyte ciascuno, quindi è meglio assicurarsi di avere abbastanza spazio libero per scaricarli. Per lo stesso motivo serve inoltre una connessione Internet veloce almeno per la fase di download dei modelli, dopodiché l’uso potrà avvenire offline.

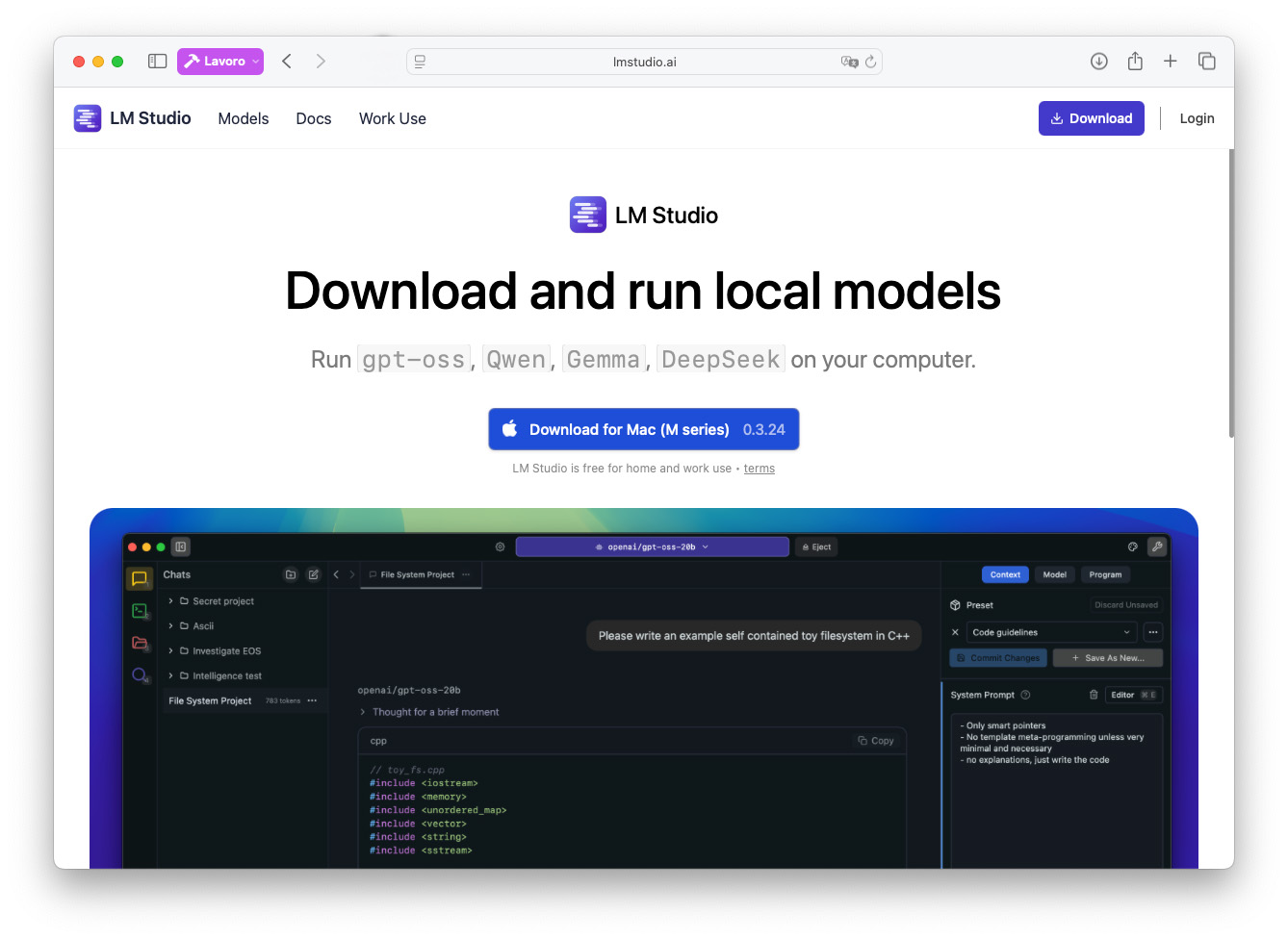

Per quanto riguarda l’installazione vera e propria, il processo è semplice e simile a quello di qualsiasi applicazione Mac di terze parti al di fuori dell’App Store: per prima cosa, occorre collegarsi al sito ufficiale di LM Studio e scaricare il pacchetto per macOS.

La versione adatta al sistema su cui stiamo operando dovrebbe essere proposta di default già nella home page del sito. Se così non fosse, possiamo accedere alla pagina Download e selezionarla manualmente.

Il team ha collaborato con OpenAI per poter offrire agli utenti il supporto per gpt-oss in LM Studio già dal giorno del lancio del modello open dell’azienda di ChatGPT. L’applicazione può eseguire localmente questo modello sin dalla release 0.3.21.

Aggiornamenti successivi hanno apportato miglioramenti in tutta l’applicazione e anche in alcuni aspetti della gestione del modello gpt-oss. Questo tutorial si basa sulla versione 0.3.24 di LM Studio.

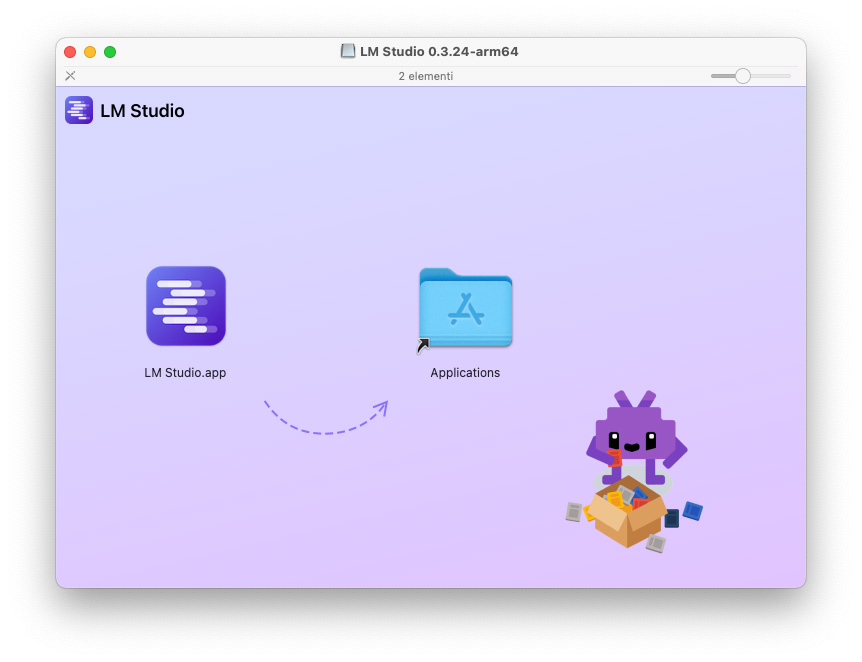

Al completamento del download, si ottiene un file .dmg contenente l’applicazione: quindi, basta aprirlo e trascinare l’icona di LM Studio nella cartella Applicazioni del Mac. Una volta copiato, è possibile avviare LM Studio come una qualsiasi altra applicazione Mac.

Al completamento del download, si ottiene un file .dmg contenente l’applicazione: quindi, basta aprirlo e trascinare l’icona di LM Studio nella cartella Applicazioni del Mac. Una volta copiato, è possibile avviare LM Studio come una qualsiasi altra applicazione Mac.

Alla prima apertura, macOS potrebbe mostrare un avviso di sicurezza di un’app scaricata da Internet: sarà necessario confermare l’operazione con un clic su Apri, se desideriamo procedere e utilizzare LM Studio. Inoltre, al primo avvio l’applicazione ci conduce attraverso una breve procedura guidata.

Il primo passo della procedura guidata è puramente introduttivo. Attraverso un link presente nella parte inferiore della schermata, possiamo consultare i termini di utilizzo prima di procedere oltre.

Se intendiamo procedere, possiamo fare clic su Get Started.

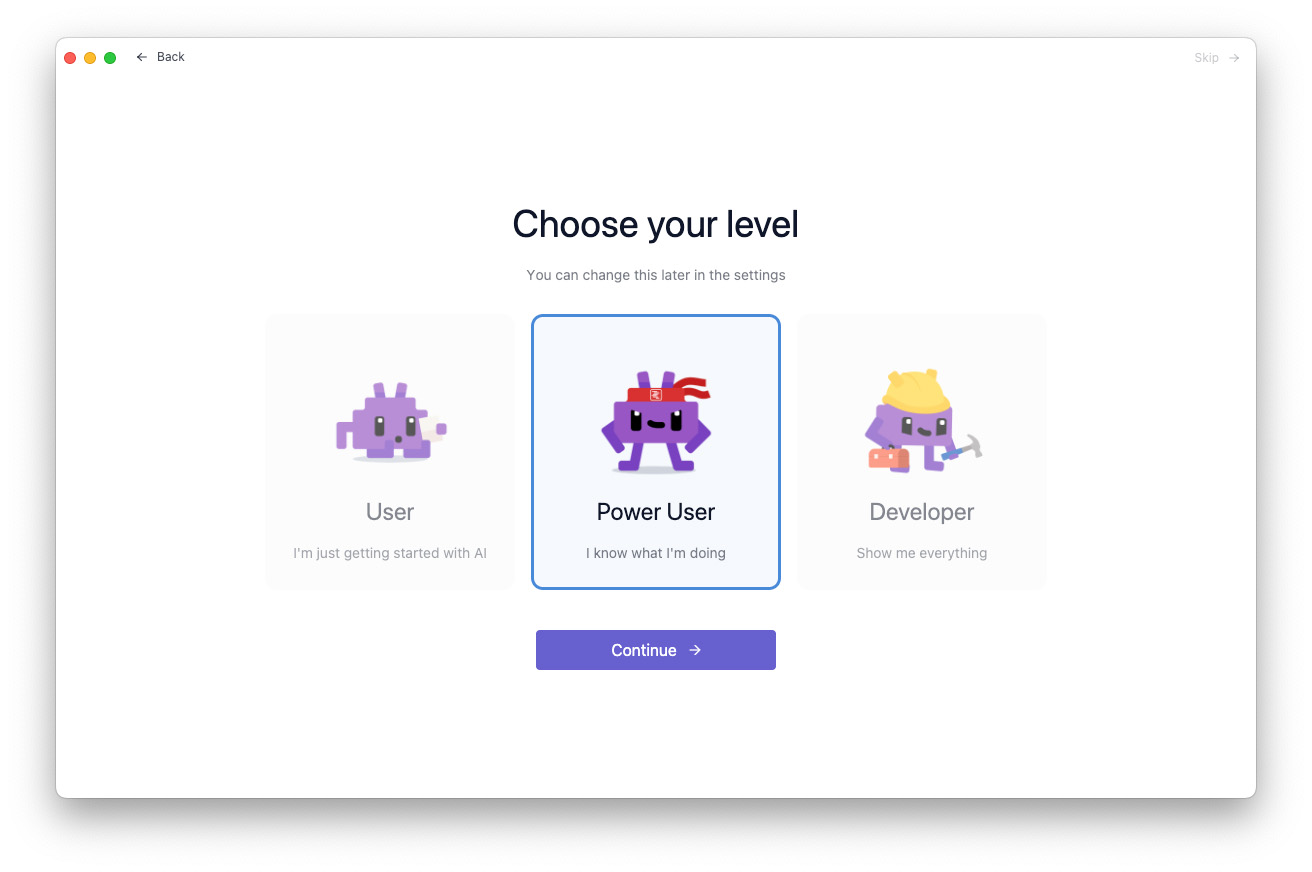

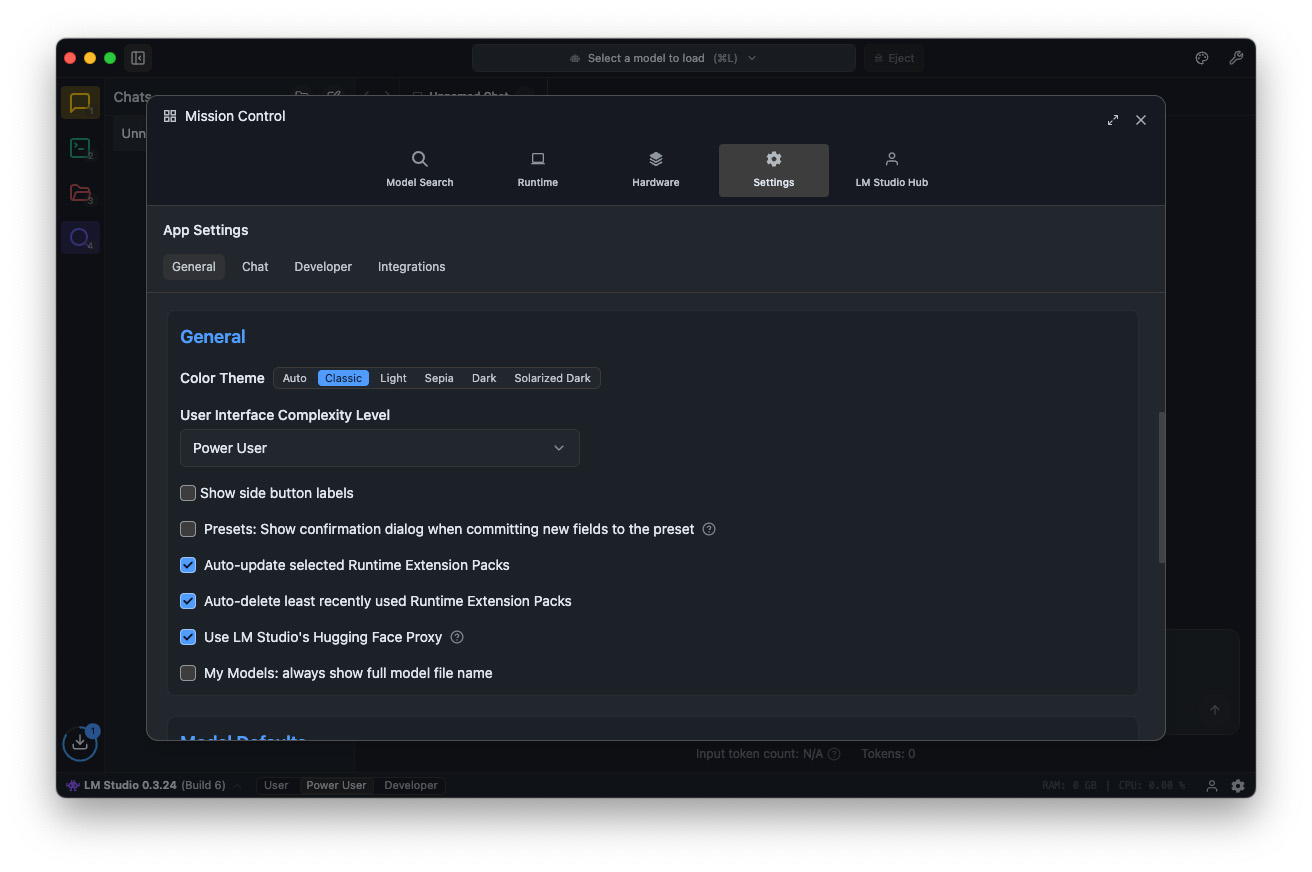

Procedendo, LM Studio presenta una schermata in cui ci chiede di selezionare il nostro livello di confidenza con l’applicazione e con la materia: la scelta determinerà il livello di complessità dell’interfaccia utente. Ci sono tre scelte: User, Power User e Developer.

Per il nostro esempio, abbiamo lasciato selezionato il livello che veniva proposto di default, quello intermedio, Power User.

Possiamo in ogni caso cambiare anche successivamente questa impostazione, in qualsiasi momento, all’interno dell’applicazione. Così come potremmo tornare alla schermata precedente (Back) o saltare del tutto la procedura guidata (con Skip), per poi scaricare manualmente il modello.

La procedura guidata è comunque una modalità veloce, comoda e facile per ottenere con pochi clic un ambiente di lavoro subito pronto all’uso.

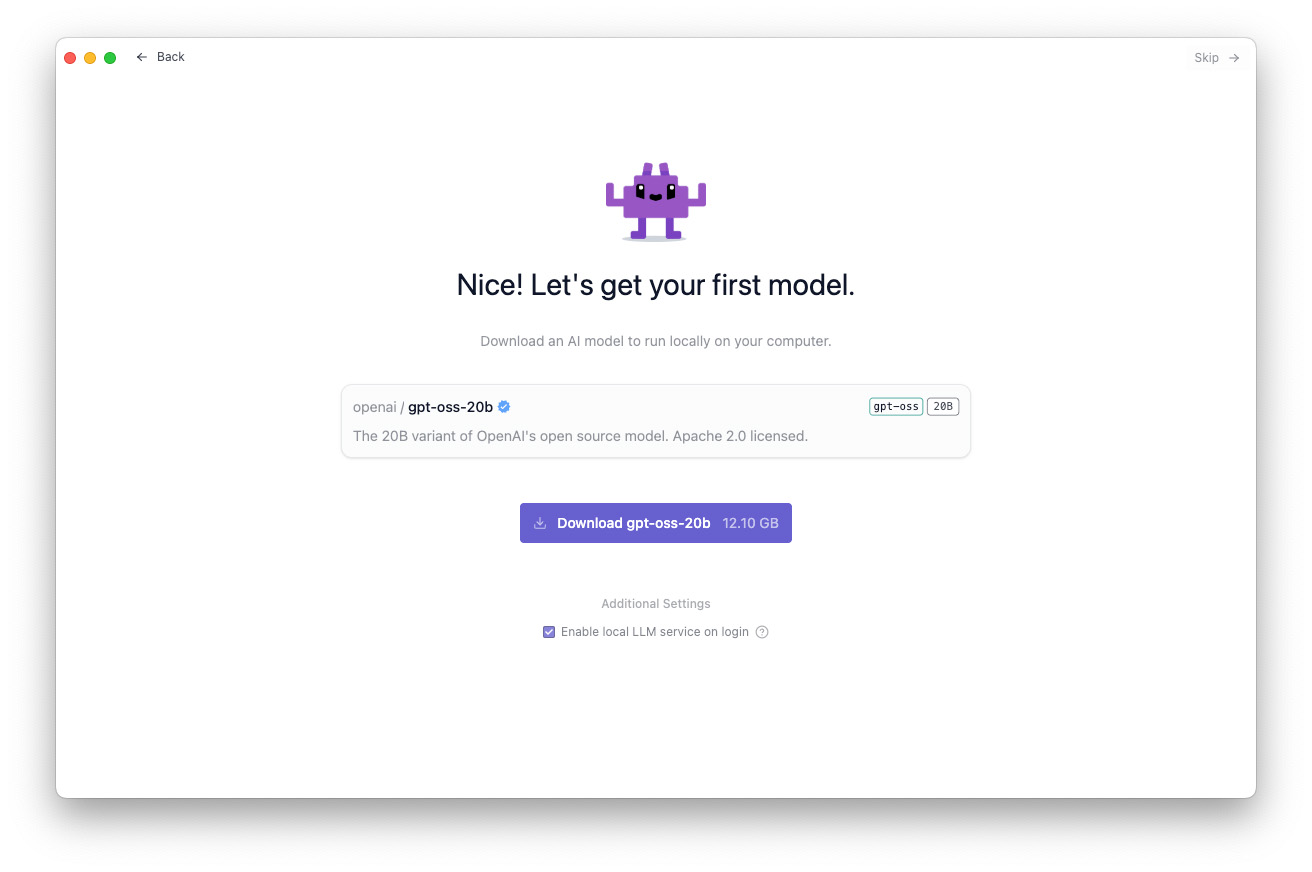

Continuando, LM Studio ci propone un primo LLM da scaricare in locale sul computer e nelle ultime versioni dell’applicazione (se la configurazione del Mac lo consente) questo modello è proprio gpt-oss-20b di OpenAI.

È un passaggio condivisibile, a nostro avviso, perché – soprattutto per chi sta muovendo i primi passi nel mondo degli LLM – evita di far approdare l’utente in un ambiente completamente vuoto, senza sapere da dove iniziare.

Come dicevamo, nel nostro esempio ci viene proposto il modello gpt-oss-20b di OpenAI in automatico e per impostazione predefinita, ma presumiamo che questa configurazione possa cambiare con l’arrivo di nuove versioni e a seconda della macchina su cui LM Studio è in esecuzione.

Abbiamo dunque scaricato il modello proposto, con un clic sull’apposito pulsante, e abbiamo lasciato attivo il checkbox Enable local LLM service on login. Questo consente di utilizzare il server LLM anche senza dover mantenere aperta l’applicazione LM Studio. Questa scelta aggiunge LM Studio agli elementi di login del Mac, che possiamo gestire in qualsiasi momento in Impostazioni > Generali > Elementi login ed estensioni.

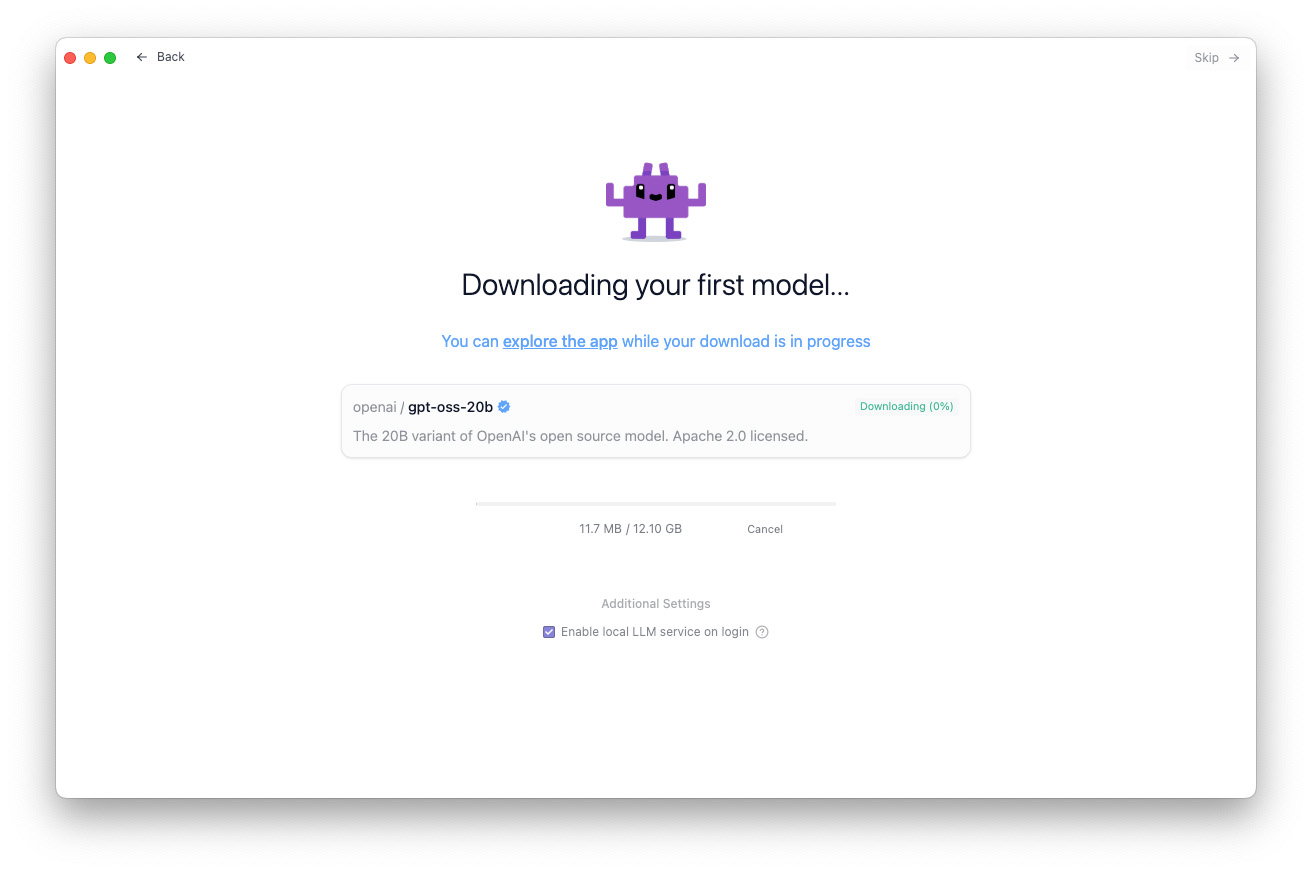

Fatto partire il download, visto che i modelli possono pesare molti GB – per la precisione 12,10 GB nel caso di gpt-oss-20b, ci avvisa l’app –, LM Studio ci consente di iniziare a esplorare l’ambiente operativo dell’applicazione, mentre lo scaricamento è in corso.

L’interfaccia di LM Studio

Diamo un primo sguardo, allora, all’interfaccia di LM Studio.

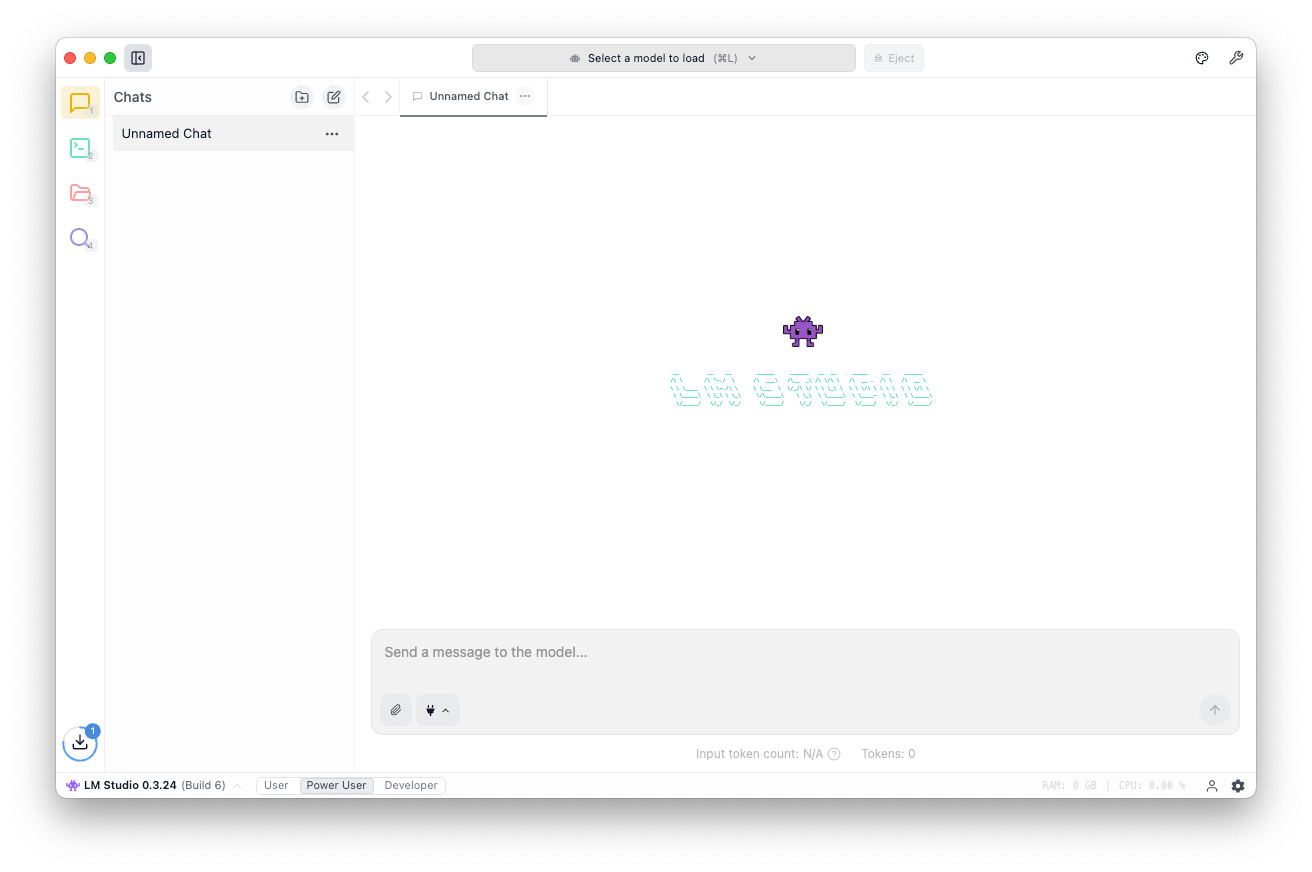

La barra superiore dell’applicazione ospita, al centro, il selettore dei modelli, che serve per selezionare il modello da caricare in memoria e con cui chattare. Se ancora non è stato scaricato un modello o, come nel nostro esempio, il download non è ancora completo, non è possibile selezionare alcun LLM.

Nella barra inferiore della finestra possiamo notare le tre opzioni per l’interfaccia di LM Studio che abbiamo già incontrato nella procedura guidata della prima configurazione: User, Power User e Developer, con il secondo (quello da noi scelto in fase di prima impostazione) selezionato.

Nell’angolo in basso a destra c’è il pulsante App Settings, che consente di accedere alle impostazioni di LM Studio.

Per chi ama personalizzare il proprio ambiente di lavoro, tra i setting troviamo ad esempio la possibilità di selezionare un tema per l’interfaccia dell’applicazione (nel nostro esempio, è selezionato Classic), il livello di complessità dell’interfaccia stessa (che, come già detto, nel nostro esempio è Power User), la lingua (che abbiamo lasciato in inglese) e tante altre opzioni.

Le impostazioni non riguardano solo le opzioni di personalizzazione dell’interfaccia, ma anche diversi altri ambiti, come il canale per gli aggiornamenti (solo quello stabile o anche le beta), vari aspetti della chat, nonché parametri per gli sviluppatori e per l’uso dei tool.

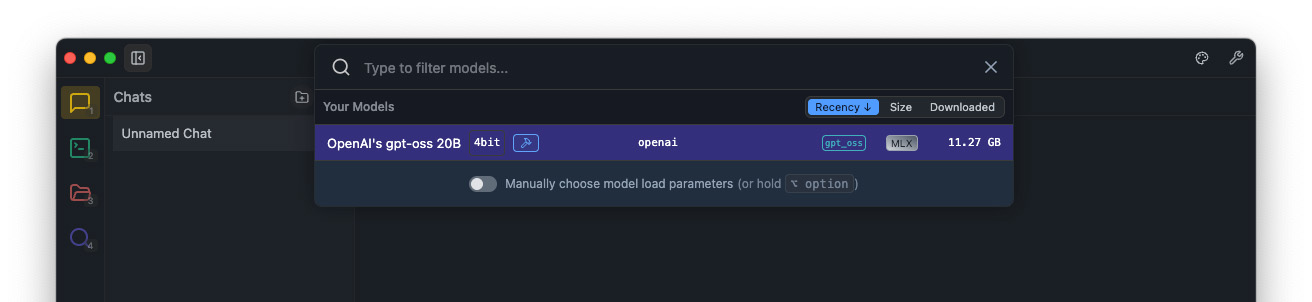

Dunque, una volta scaricato il modello sul computer, possiamo caricarlo in memoria facendo clic su Select a model to load nella barra superiore della finestra oppure con la scorciatoia da tastiera Comando + L.

Dal menu che si apre – in cui LM Studio visualizza la lista dei modelli disponibili in locale, con una serie di informazioni – selezioniamo gpt-oss 20B.

Per inciso, se non avessimo già scaricato il nostro primo modello durante la procedura guidata, LM Studio ci avrebbe proposto in questo menu a tendina il download di gpt-oss-20b (o altro modello preimpostato).

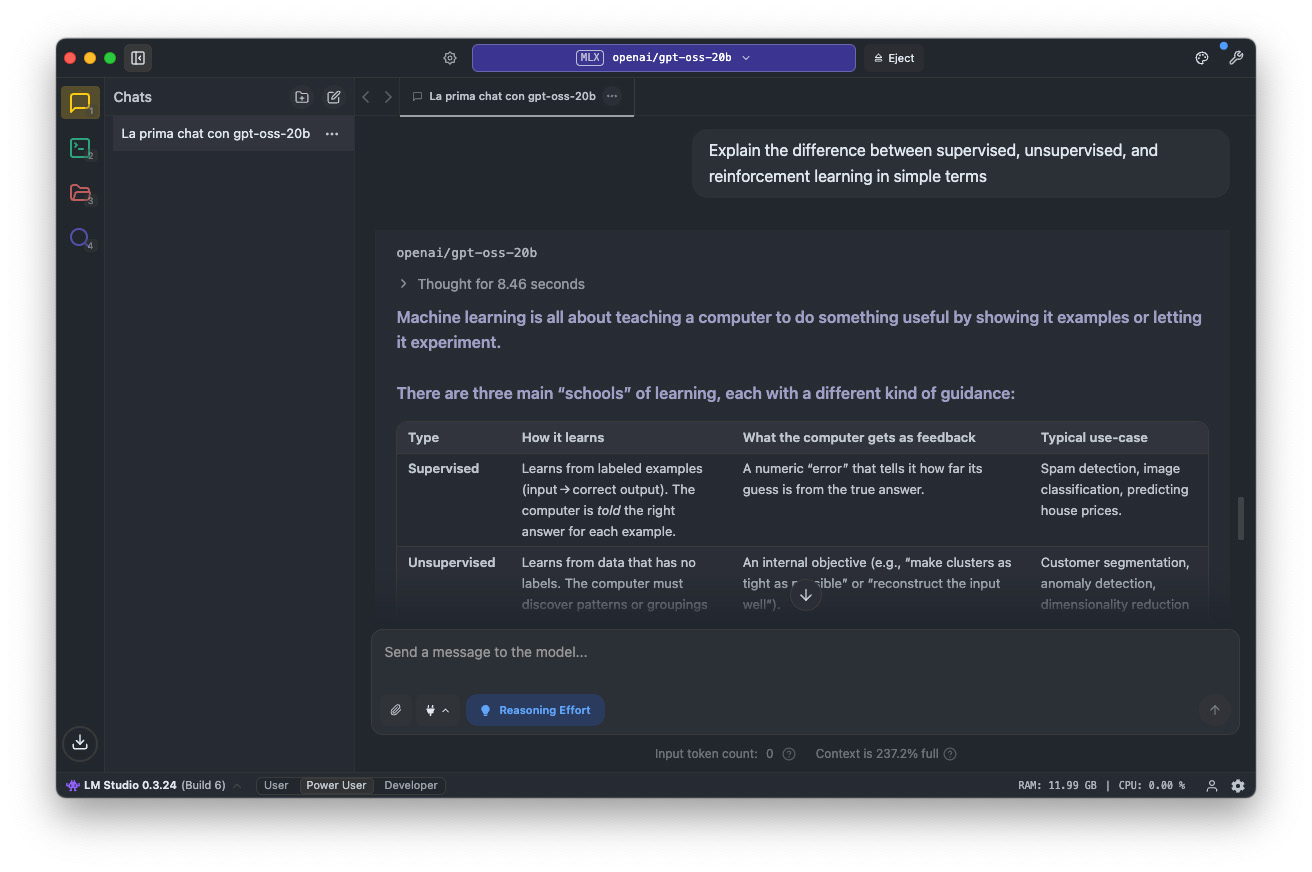

A questo punto, il selettore dei modelli nella barra superiore della finestra indica che il modello gpt-oss-20b di OpenAI è attualmente caricato in memoria: possiamo ora porre ad esso le nostre domande, digitandole nel campo del prompt all’interno della finestra della chat.

Chattare con gpt-oss-20b di OpenAI

Poter testare le capacità di un modello da 20 miliardi di parametri sul Mac in locale – memoria permettendo, il solo modello occupa circa 12 GB –, peraltro un LLM open-weight basato sulla tecnologia OpenAI e con una licenza flessibile Apache 2.0, è un risultato notevole.

Bisogna però tenere sempre presente che, seppur si tratti di un modello grande, è comunque ben più leggero e compatto rispetto agli LLM tipici dei cloud, e c’è da considerare anche gli effetti della quantizzazione. Inoltre, OpenAI spiega di aver addestrato i modelli gpt-oss “su un set di dati di testo di alta qualità, principalmente in inglese, con particolare attenzione a STEM, programmazione e cultura generale”.

Il modello gpt-oss-20b è multilingue e comprende e produce output anche in italiano, ma, nella nostra lingua, durante le nostre prove è emersa qualche imprecisione. Con un Mac con chip Apple M4 Max e 36 GB di memoria unificata, l’operatività si è dimostrata fluida e rapida.

Con un livello di reasoning medio, il throughput ha spesso superato i 90 token al secondo e non è mai sceso sotto i 60 token al secondo, con il primo token tra un minimo di 0,17 secondi a un massimo di 1,66 secondi, con una serie di prompt in inglese che hanno messo alla prova capacità quali: comprensione di testi e concetti complessi, ragionare su problemi logici, scrittura creativa, scrivere codice funzionante, gestire contesti lunghi senza “dimenticare” i dettagli.

Nei prossimi articoli esploreremo le principali funzionalità di LM Studio per l’esecuzione del modello gpt-oss-20b sul Mac, così come per la ricerca, installazione e gestione in locale di altri LLM.