ll mainframe è tutt’altro che un residuo del passato: continua a evolversi per affrontare le sfide dell’intelligenza artificiale, della cybersicurezza e della sostenibilità. In questa intervista, Andrea Corbelli, Director, WW IBM Z & LinuxONE Technical Sales, ci racconta come le nuove generazioni di piattaforme Z e LinuxONE stiano ridefinendo il ruolo del mainframe, puntando su AI integrata, capacità di resilienza eccezionali, protezione quantum safe e apertura verso gli standard open source.

Dall’antifrode in tempo reale ai modelli generativi, dalle architetture containerizzate al confidential computing, la strategia IBM guarda a un futuro ibrido e modulare, dove la potenza classica si integra con acceleratori di AI e, in prospettiva, con unità di calcolo quantistico.

“Il mainframe rimane alla base dei processi transazionali globali”, esordisce Corbelli, aprendo l’incontro con un quadro di insieme. “Oggi circa il 70% del valore delle transazioni mondiali viene elaborato su mainframe, e questo la dice lunga sulla solidità e sulla fiducia che queste piattaforme continuano a garantire”.

E la rilevanza non si limita solo al settore bancario: “Il mainframe è centrale anche per il mondo assicurativo, per la pubblica amministrazione e per tutti gli operatori che gestiscono processi critici come i pagamenti con carta di credito. È una tecnologia che, pur essendo percepita come «storica», risulta più attuale che mai perché risponde a esigenze di affidabilità e continuità operative che non hanno equivalenti”.

“Parliamo di sistemi con uptime del 99,999999%, che significa meno di 300 millisecondi di fermo previsto l’anno. Alcuni nostri clienti non hanno registrato downtime per decenni, grazie all’utilizzo di funzionalità come clustering, disaster recovery e alta affidabilità integrate. Questo livello di resilienza rimane un fattore di differenziazione assoluto nel panorama IT mondiale”. Come termine di paragone, un battito di ciglia dura circa 300 millisecondi.

Evoluzione tecnologica e nuovi workload

Il mercato del mainframe, sottolinea Corbelli, non è affatto statico: “Si muove su un doppio binario. Da un lato ci sono i clienti che sostituiscono periodicamente i propri sistemi, di solito ogni tre anni, aggiornandoli per beneficiare delle nuove funzionalità e delle migliori prestazioni. Dall’altro emergono nuovi clienti, spesso con background Linux, che approcciano il mainframe attraverso LinuxONE, attratti dalla combinazione di sicurezza, affidabilità ed efficienza energetica”.

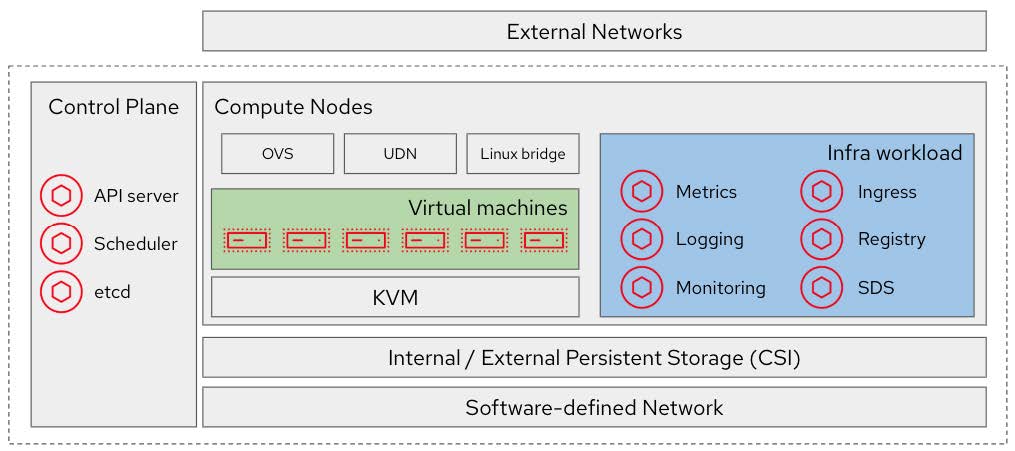

LinuxONE rappresenta infatti un punto di incontro tra la cultura open source e la solidità mainframe: piattaforme capaci di ospitare macchine virtuali Linux tradizionali, ma anche container orchestrati con Red Hat OpenShift, con un’infrastruttura completamente compatibile con tool DevOps come Ansible e Terraform. Corbelli evidenzia che molti clienti scelgono LinuxONE proprio perché possono applicare le stesse pratiche cloud-native già adottate altrove, senza rinunciare alla resilienza, alla cifratura pervasiva e ai tempi di risposta ultrabassi tipici dei sistemi Z.

Un ulteriore vantaggio riguarda la sostenibilità: “Con LinuxONE”, precisa Corbelli, “abbiamo clienti che hanno ridotto del 75% lo spazio fisico del data center e i consumi elettrici, consolidando centinaia o migliaia di workload su un’unica piattaforma. Questo si traduce in un beneficio tangibile anche per gli obiettivi di decarbonizzazione”.

Dal punto di vista della sicurezza, LinuxONE eredita tutte le capacità del mainframe tradizionale: confidential computing, cryptocard con gestione avanzata delle chiavi, cifratura end-to-end e auditing centralizzato. Caratteristiche che lo rendono particolarmente adatto a settori altamente regolamentati come banche, assicurazioni, pubblica amministrazione e sanità, dove la sovranità del dato e la compliance normativa sono vincoli imprescindibili.

Intelligenza artificiale nel cuore del mainframe

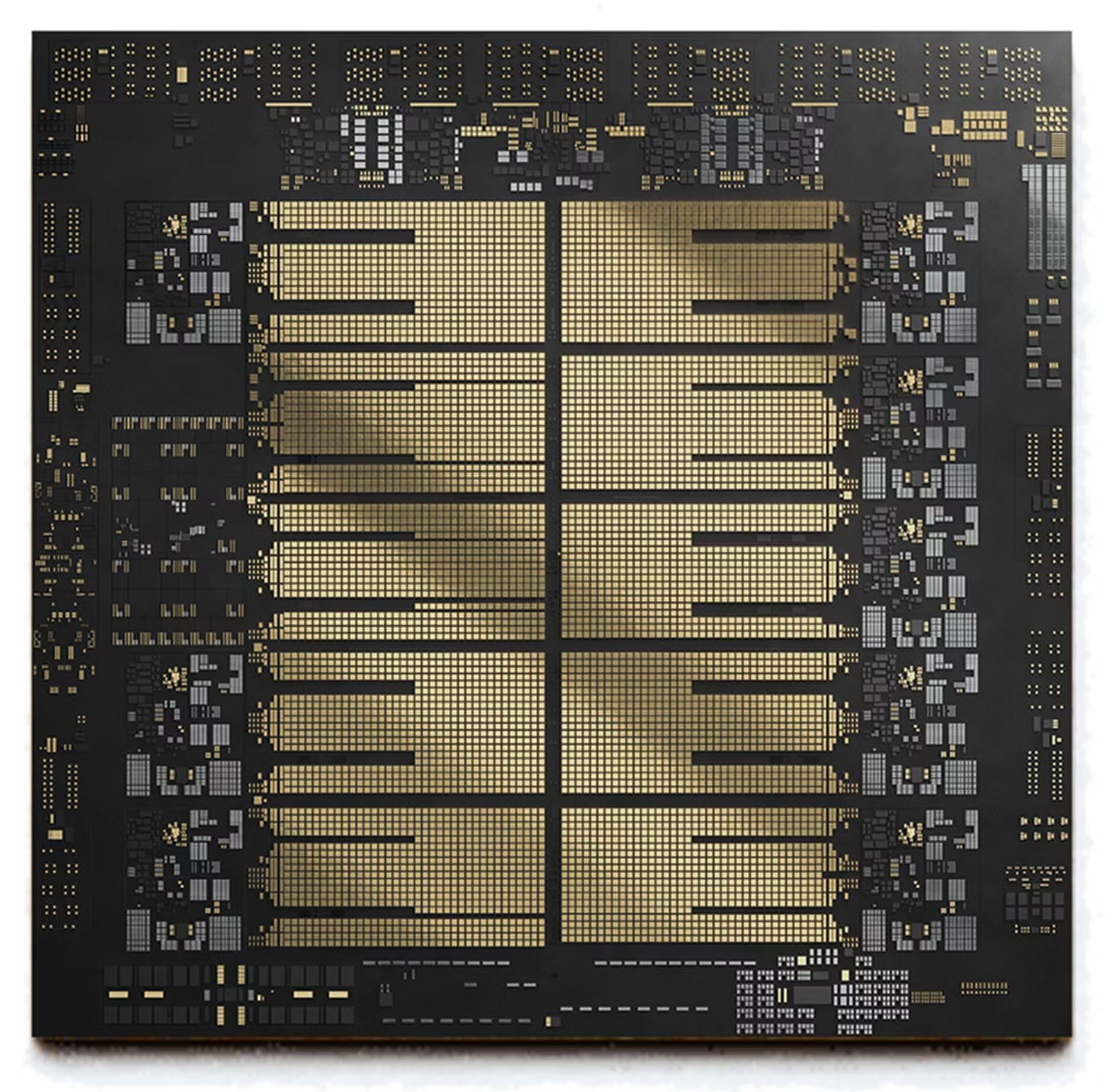

Il capitolo AI rappresenta una delle direttrici più strategiche dell’evoluzione IBM. “Siamo già alla seconda generazione di acceleratori AI integrati nei processori Telum”, evidenzia Corbelli. “Il nuovo Z17 e il LinuxONE 5, grazie anche alle schede PCI, possono arrivare a circa 1.500 acceleratori complessivi. Si tratta di un incremento enorme rispetto ai 32 acceleratori della generazione precedente”.

Questo potenziamento non è solo quantitativo, ma cambia radicalmente la natura dei casi d’uso. “Il mainframe”, spiega Corbelli, “sta diventando il luogo ideale per portare l’AI a livello transazionale. Poter eseguire inferenza durante la transazione, con tempi di latenza inferiori al millisecondo, significa garantire sicurezza, personalizzazione e ottimizzazione del servizio in real time”.

Un esempio concreto? La rilevazione frodi sulle transazioni bancarie. “Oggi è possibile — grazie agli acceleratori integrati — fare analisi predittive e di pattern in tempo reale, bloccando comportamenti anomali prima che la transazione venga approvata. Questo approccio in-line evita false segnalazioni e protegge meglio sia l’istituto finanziario sia il cliente”, chiarisce Corbelli.

Ma non c’è solo il mondo bancario. L’AI a bordo dei mainframe si estende a use case verticali come: analisi dei claim assicurativi, document processing, classificazione di immagini in ambito sanitario, cybersecurity comportamentale.

In questo scenario, la generative AI gioca un ruolo ulteriore, diventando un alleato per la produttività e la modernizzazione del software. “Con Watson Assistant for Z e Watson Code Assistant”, prosegue Corbelli, “l’obiettivo è abilitare nuove forme di automazione: non solo suggerire procedure operative, ma addirittura generare codice o orchestrare task complessi in modo sicuro, direttamente a bordo del mainframe”.

La roadmap IBM punta a estendere progressivamente l’integrazione di modelli linguistici di tipo SLM e LLM, anche con possibilità di deployment su schede PCI, così da incrementare la scalabilità senza esportare dati sensibili su cloud esterni.

AI on chip vs AI su schede acceleratrici: due strategie complementari

IBM, racconta Corbelli, ha voluto bilanciare le esigenze di velocità e quelle di potenza attraverso un’architettura a due livelli: AI on chip e AI su schede PCI.

Gli acceleratori AI integrati nel processore Telum, molto vicini alla cache e ai core di calcolo, permettono di eseguire inferenze immediate con latenza inferiore al millisecondo. Questo è essenziale per casi d’uso inline, come il blocco di una frode nel momento esatto in cui si autorizza una transazione. L’integrazione così stretta riduce drasticamente i tempi di trasferimento dei dati, evitando colli di bottiglia e mantenendo performance elevate su carichi mission-critical.

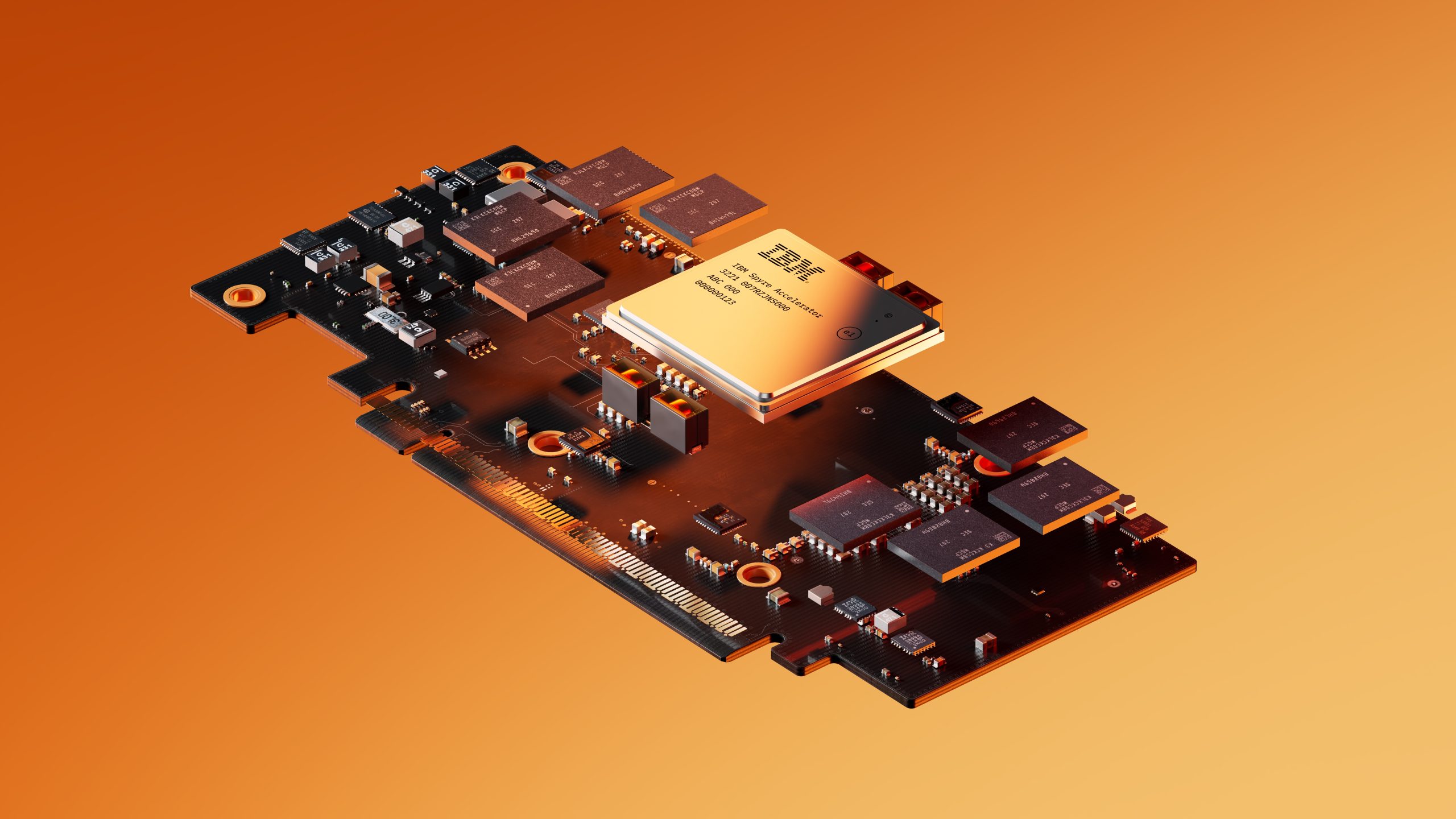

In parallelo, le schede acceleratrici PCI dedicate all’AI offrono capacità computazionale aggiuntiva e scalabile. Ogni scheda può contenere fino a 32 acceleratori, e un sistema Z17 può gestirne fino a 48, per un totale di 1.536 acceleratori complessivi. Questo permette di elaborare modelli più complessi — come Large Language Model o generative AI — che richiedono dataset estesi e calcoli di lunga durata, senza gravare sulla CPU principale.

“Possiamo così mantenere la protezione e la rapidità transazionale a livello di core, e spostare modelli più pesanti sulle schede PCI, modulari e aggiornabili secondo le esigenze del business”, spiega Corbelli.

Questi due approcci non si escludono, anzi: convivono perfettamente nella logica di computing ibrido del mainframe, garantendo la massima efficienza su carichi di lavoro a bassa latenza e su elaborazioni predittive più articolate.

Sicurezza e crittografia

La sicurezza, nella strategia IBM, è molto più di un requisito: è la base stessa dell’architettura. “Il mainframe nasce con una cultura della sicurezza storicamente altissima, ma oggi la stiamo estendendo in chiave quantum safe”, afferma Corbelli. “Questo significa che firmware, boot process e schede crittografiche utilizzano algoritmi di nuova generazione per resistere alle potenziali minacce dei computer quantistici, in grado di forzare la crittografia tradizionale”.

In concreto, il firmware del sistema Z17 è firmato con tecniche post-quantum che rendono impossibile la sostituzione fraudolenta delle immagini di avvio, mentre le crypto card generano e custodiscono chiavi resistenti agli attacchi quantistici.

Corbelli specifica: “Per la cifratura simmetrica dei dati in memoria e sui bus interni utilizziamo AES 256 bit, mentre per la gestione delle chiavi asimmetriche supportiamo i nuovi algoritmi quantum safe ML-KEM e ML-DSA proposti da IBM e standardizzati dal NIST. “Nemmeno un fornitore di cloud può accedere ai dati cifrati, perché la gestione delle chiavi resta totalmente nelle mani del cliente, custodita nelle crypto card”.

IBM consente inoltre l’uso di modelli a doppia chiave, dove una chiave è gestita dal cliente (tipicamente nel proprio data center o sulla crypto card) e l’altra dal provider cloud. Questa doppia firma permette di assicurare che nemmeno il fornitore di servizi cloud pubblico possa accedere ai dati in chiaro senza il consenso esplicito del titolare, garantendo così la sovranità del dato in qualsiasi contesto.

La protezione non si limita alla cifratura dei dati a riposo o in transito: “Con il confidential computing garantiamo la protezione anche dei dati in uso, ovvero mentre vengono elaborati in memoria”, aggiunge. “Ogni core integra un acceleratore crittografico che cifra e decifra in tempo reale i dati, senza pesare sulle prestazioni. Persino i bus interni di comunicazione tra processori o tra cassetti della macchina sono cifrati. Questo crea un ambiente a prova di attacchi, con la possibilità di proteggere anche dall’eventuale tentativo di un amministratore malevolo di accedere ai dati in chiaro”.

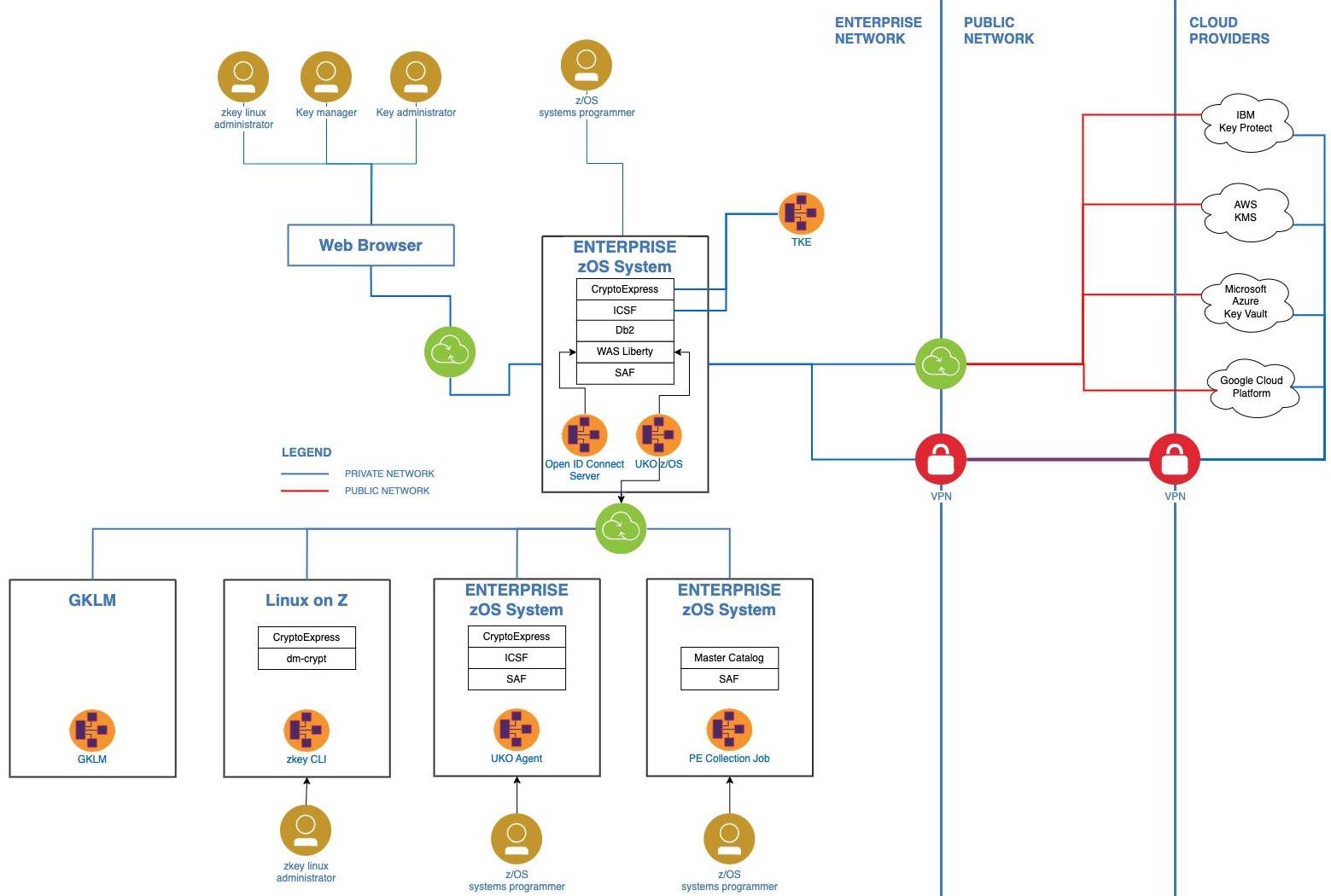

Per orchestrare queste architetture di chiavi distribuite, IBM offre Unified Key Orchestrator, un software in grado di coordinare il ciclo di vita delle chiavi crittografiche, includendo generazione, rotazione, auditing e revoca. Funziona in ambienti multicloud e si integra con i meccanismi di confidential computing, così da mantenere una governance coerente su tutti gli asset digitali.

Accanto a questo, Corbelli cita anche Vault come ulteriore livello di protezione. Derivato dall’universo HashiCorp, Vault amplia la gestione dei segreti. “Se Unified Key Orchestrator permette di governare le chiavi crittografiche”, spiega Corbelli, “Vault estende questo paradigma a tutti gli altri segreti digitali: certificati, token, password, credenziali API”. In pratica Vault centralizza la gestione e il versioning dei segreti, semplificando le policy di rotazione, riducendo il rischio di errori umani e garantendo che le credenziali non rimangano in chiaro all’interno del codice o dei repository.

Vault è progettato per integrarsi con meccanismi di Confidential Computing: può essere eseguito in ambienti protetti dove i dati in uso sono cifrati, così che nemmeno gli amministratori di sistema possano intercettarli, offrendo così un ulteriore livello di difesa per carichi di lavoro altamente sensibili.

“Con Vault”, precisa Corbelli, “si arriva a una gestione dei segreti che rispetta policy di sicurezza enterprise, anche in scenari multicloud e distribuiti”.

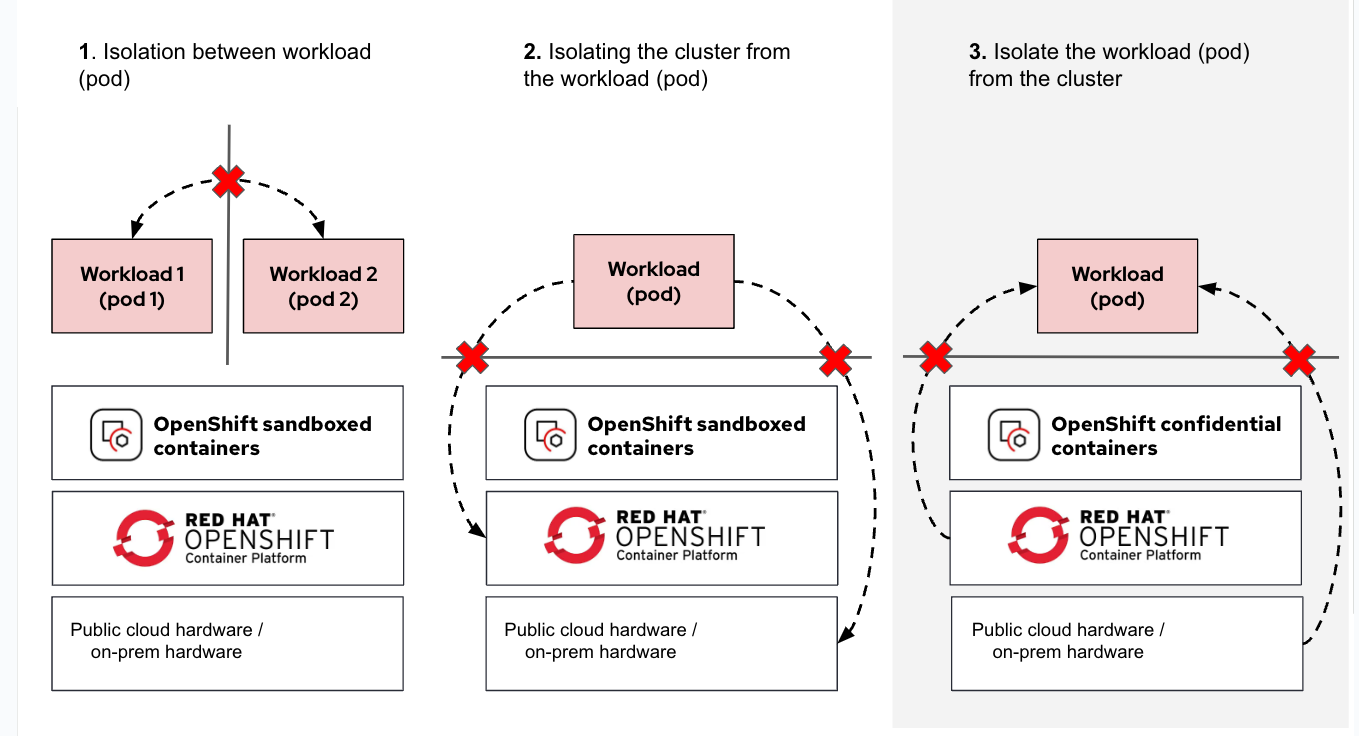

E, nell’ambito del Confidential Computing, un altro tassello riguarda OpenShift Confidential Containers, un’estensione di Red Hat OpenShift che abilita la protezione dei dati all’interno dei container Kubernetes, fino al livello del singolo pod. “Con i Confidential Containers”, evidenzia Corbelli, “si garantisce che anche in architetture a microservizi, tipiche del cloud-native, i dati restino cifrati e protetti durante l’esecuzione”.

Questo approccio completa la visione del confidential computing end-to-end, estendendo la protezione non solo al sistema operativo o alla VM, ma fino all’unità più granulare di orchestrazione, cioè il pod Kubernetes.

A cucire insieme questi elementi è sempre la visione quantum safe by design: dalla generazione delle chiavi al firmware di avvio, fino al ciclo di vita completo di ogni segreto, tutto è progettato per resistere al rischio che in futuro computer quantistici possano rompere gli algoritmi tradizionali.

La nuova frontiera dell’I/O

A corredo dell’accelerazione AI, la generazione Z17 introduce anche una svolta nell’I/O. Corbelli spiega: “Abbiamo inserito un acceleratore di I/O su ciascun core, così da raddoppiare la capacità di connessione delle schede I/O a parità di spazio fisico. In questo modo si possono liberare slot preziosi per le schede PCI dedicate all’AI, mantenendo inalterato il profilo di consumo energetico rispetto alla generazione precedente”.

Questa architettura permette di: ottimizzare i flussi dati, con minori ritardi e maggiore parallelismo, mantenere la scalabilità, perché il numero di schede AI installabili non è limitato da vincoli I/O e sostenere carichi dinamici, come modelli di machine learning che devono ricevere input da sensori, app mobili o dispositivi di pagamento

“Un I/O più efficiente”, sottolinea Corbelli, “significa alimentare continuamente i modelli di intelligenza artificiale senza creare colli di bottiglia, con un vantaggio evidente per casi d’uso come la cybersecurity distribuita o l’antifrode in tempo reale”.

Spostare la gestione I/O vicino al core riduce la latenza, consente più connessioni per unità di spazio e libera risorse per l’intelligenza artificiale. È una base tecnologica chiave per sostenere modelli AI distribuiti su larga scala.

Hybrid by design

Il concetto di “hybrid” è un pilastro della strategia IBM. “Sviluppiamo tre generazioni di mainframe contemporaneamente”, spiega Corbelli, “e ora che Z17 e LinuxONE 5 sono usciti, siamo già al lavoro sullo Z-next, che scenderà a processi produttivi di 2–3 nanometri per liberare ulteriore spazio a nuovi acceleratori, rimanendo nello stesso inviluppo energetico”.

La direzione è chiara: CPU tradizionali, GPU, e in prospettiva QPU (Quantum Processing Units) coesisteranno. “Abbiamo una roadmap precisa sul quantistico”, afferma Corbelli, “con sistemi fault-tolerant da 200 qubit logici entro il 2029 e fino a 2.000 qubit logici entro il 2033, destinati a collaborare con i supercomputer classici per risolvere problemi oggi irrisolvibili”. Un sistema quantistico fault-tolerant integra algoritmi di correzione dell’errore, così da mantenere la coerenza dei qubit anche in presenza di disturbi esterni. È considerato il prerequisito per passare dal calcolo sperimentale a soluzioni industriali affidabili.

“Non immaginiamo un quantum computer isolato in un laboratorio”, puntualizza, “ma un sistema cooperativo dove la parte classica, la parte AI e la parte quantistica condividano dati, workload e policy di sicurezza in un unico ambiente integrato. La sinergia tra Cpu e Qpu si può già ottenere oggi con il nostro software Qiskit, come già evidenziato in collaborazione con il supercomputer del centro Riken in Giappone”.

Semplificazione e strumenti open source

Il terzo asse strategico per IBM è la semplificazione. “Molti clienti vogliono mantenere i dati dentro il perimetro sicuro del mainframe”, ricorda Corbelli. “Per questo portiamo Watson Assistant for Z e Watson Code Assistant direttamente a bordo, senza dover appoggiarsi a server esterni”.

Questa integrazione si completa con strumenti per DevOps e automazione, come Ansible e Terraform. “Grazie all’acquisizione di HashiCorp possiamo proporre infrastruttura come codice sfruttando skill già diffusi nel mondo public cloud”, sottolinea Corbelli.

Ansible, componente Red Hat ormai consolidata, permette di automatizzare la configurazione dei sistemi e delle applicazioni attraverso playbook dichiarativi, riducendo errori umani e velocizzando i processi di deployment. È particolarmente adatto per orchestrare attività ripetitive sul mainframe, come provisioning di ambienti, aggiornamenti o modifiche alla configurazione.

Terraform, invece, introduce un livello ancora più elevato di astrazione, consentendo di definire infrastrutture complete come codice, descrivendo risorse, dipendenze e policy in linguaggio HCL (HashiCorp Configuration Language). “Con Terraform”, precisa Corbelli, “riusciamo a descrivere e replicare infrastrutture complesse, integrandole con ambienti multicloud o ibridi, mantenendo la governance sul ciclo di vita delle risorse”.

Il connubio tra Ansible e Terraform è quindi particolarmente potente: Terraform si occupa di definire e distribuire l’infrastruttura (server, network, storage) mentre Ansible si concentra sulla configurazione e la gestione operativa dei software e delle applicazioni.

Corbelli evidenzia come questa combinazione permetta anche a team che non hanno skill storici sul mainframe di operare con la stessa logica già adottata nel public cloud, facilitando la transizione verso architetture ibride e modernizzate.

“L’obiettivo”, conclude, “è rendere il mainframe più accessibile e gestibile come qualsiasi altra risorsa cloud, sfruttando standard ormai condivisi dalla comunità open source”.

Inoltre, IBM sta rendendo disponibile su LinuxONE e sulla piattaforma Z la technical preview di OpenShift Virtualization, che permette di gestire carichi misti — macchine virtuali e container — con un’unica console, garantendo coerenza operativa anche in ambienti legacy che devono convivere con il cloud-native.

“Queste tecnologie”, conclude Corbelli, “consolidano la missione del mainframe: restare la piattaforma più sicura e resiliente al mondo, senza rinunciare alla modernità e all’apertura verso gli standard più avanzati dell’ecosistema open source”.