Un anno fa, Microsoft ha introdotto i modelli linguistici di piccole dimensioni con il rilascio di Phi-3 su Azure AI Foundry, sfruttando la ricerca sugli SLM (small language model) per ampliare la gamma di modelli e strumenti di intelligenza artificiale efficienti a disposizione dei clienti: ora, l’azienda ha presentato Phi-4-reasoning, Phi-4-reasoning-plus e Phi-4-mini-reasoning.

Secondo Microsoft, questo rilascio segna una nuova era per i modelli linguistici di piccole dimensioni e ridefinisce ancora una volta ciò che è possibile fare con l’IA compatta ed efficiente.

I modelli di ragionamento – sottolinea Microsoft – sono addestrati a sfruttare l’inference-time scaling per eseguire compiti complessi che richiedono una scomposizione in più fasi e una riflessione interna. Eccellono nel ragionamento matematico e stanno emergendo come la spina dorsale delle applicazioni agenziali con compiti complessi e sfaccettati. Tali capacità sono tipicamente presenti solo nei modelli di frontiera di grandi dimensioni.

Microsoft mette in evidenza che i modelli Phi-reasoning introducono una nuova categoria di modelli linguistici di piccole dimensioni. Utilizzando la distillazione, l’apprendimento per rinforzo e dati di alta qualità, questi modelli bilanciano dimensioni e prestazioni. Sono sufficientemente piccoli per ambienti a bassa latenza, ma mantengono forti capacità di ragionamento che rivaleggiano con modelli molto più grandi. Questa combinazione consente anche ai dispositivi con risorse limitate di eseguire compiti di ragionamento complessi in modo efficiente.

Phi-4-reasoning è un modello di ragionamento open-weight a 14 miliardi di parametri che compete con modelli molto più grandi su compiti di ragionamento complessi, afferma Microsoft. Addestrato tramite supervised fine-tuning di Phi-4 su dimostrazioni di ragionamento accuratamente curate da OpenAI o3-mini, Phi-4-reasoning genera catene di ragionamento dettagliate che sfruttano efficacemente il calcolo supplementare in tempo di inferenza. Il modello – secondo Microsoft – dimostra che una cura meticolosa dei dati e dataset sintetici di alta qualità consentono ai modelli più piccoli di competere con le controparti più grandi.

Phi-4-reasoning-plus si basa sulle capacità di Phi-4-reasoning, ulteriormente addestrate con l’apprendimento per rinforzo per utilizzare più calcolo nel tempo di inferenza, utilizzando 1,5 volte più token rispetto a Phi-4-reasoning, per offrire una maggiore precisione.

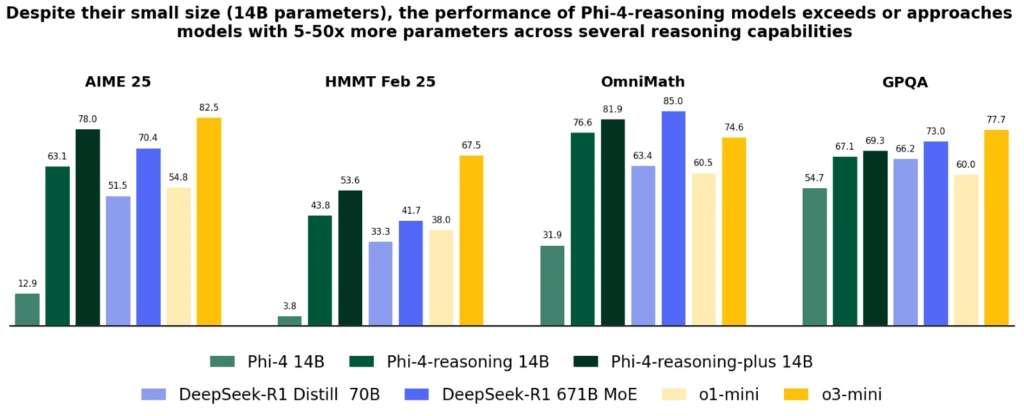

Nonostante le dimensioni significativamente più ridotte, Microsoft afferma che entrambi i modelli ottengono prestazioni migliori rispetto a OpenAI o1-mini e DeepSeek-R1-Distill-Llama-70B nella maggior parte dei benchmark, compresi i ragionamenti matematici e le domande scientifiche di livello dottorato. Hanno ottenuto prestazioni migliori rispetto al modello completo DeepSeek-R1 (con 671 miliardi di parametri) nel test AIME 2025, il test di qualificazione per l’USA Math Olympiad del 2025. Entrambi i modelli sono disponibili su Azure AI Foundry e HuggingFace.

Nonostante le dimensioni significativamente più ridotte, Microsoft afferma che entrambi i modelli ottengono prestazioni migliori rispetto a OpenAI o1-mini e DeepSeek-R1-Distill-Llama-70B nella maggior parte dei benchmark, compresi i ragionamenti matematici e le domande scientifiche di livello dottorato. Hanno ottenuto prestazioni migliori rispetto al modello completo DeepSeek-R1 (con 671 miliardi di parametri) nel test AIME 2025, il test di qualificazione per l’USA Math Olympiad del 2025. Entrambi i modelli sono disponibili su Azure AI Foundry e HuggingFace.

Dal punto di vista di Microsoft, i modelli Phi-4-reasoning introducono un importante miglioramento rispetto a Phi-4, superano modelli più grandi come DeepSeek-R1-Distill-70B e si avvicinano a Deep-Seek-R1 in varie capacità di ragionamento e generali, tra cui matematica, coding, risoluzione di problemi algoritmici e pianificazione, e la relazione tecnica fornisce ampie prove quantitative di questi miglioramenti attraverso diversi compiti di ragionamento.

Phi-4-mini-reasoning è stato progettato da Microsoft per soddisfare la richiesta di un modello di ragionamento compatto. Questo language model transformer-based è ottimizzato per il ragionamento matematico e fornisce una risoluzione di problemi passo-passo di alta qualità in ambienti con limitazioni di calcolo o latenza. Messo a punto con i dati sintetici generati dal modello Deepseek-R1, Phi-4-mini-reasoning bilancia l’efficienza con la capacità di ragionamento avanzata. È ideale per le applicazioni didattiche, il tutoraggio embedded e l’implementazione leggera su sistemi edge o mobili, ed è stato addestrato su oltre un milione di problemi matematici diversi che coprono diversi livelli di difficoltà, dalla scuola media al livello di dottorato. È possibile provare il modello su Azure AI Foundry o HuggingFace, e ottenere maggiori informazioni nel technical report.

L’evoluzione di Phi nel corso dell’ultimo anno – sottolinea Microsoft – ha continuamente spinto questo limite di qualità rispetto alle dimensioni, ampliando la famiglia con nuove funzionalità per rispondere a diverse esigenze. Su tutta la scala dei dispositivi Windows 11, questi modelli sono disponibili per l’esecuzione locale su CPU e GPU.

Mentre Windows lavora per creare un nuovo tipo di PC, i modelli Phi sono diventati parte integrante dei PC Copilot+ con la variante Phi Silica ottimizzata per NPU. Questa versione di Phi, altamente efficiente e gestita dal sistema operativo, è progettata per essere precaricata in memoria e disponibile con tempi rapidissimi di risposta al primo token e un throughput di token efficiente dal punto di vista energetico, in modo da poter essere invocata contemporaneamente ad altre applicazioni in esecuzione sul PC.

È utilizzato in esperienze fondamentali come Click to Do, che fornisce utili strumenti di intelligenza testuale per qualsiasi contenuto sullo schermo, ed è disponibile come API per sviluppatori per essere facilmente integrato nelle applicazioni, già utilizzate in diverse applicazioni di produttività come Outlook, che offre le sue funzioni di riepilogo Copilot offline. Questi modelli, piccoli ma potenti, sono già stati ottimizzati e integrati per essere utilizzati in diverse applicazioni dell’ecosistema PC. I modelli Phi-4-reasoning e Phi-4-mini-reasoning sfruttano le ottimizzazioni low-bit di Phi Silica e saranno presto disponibili per l’esecuzione sulle NPU Copilot+ per PC.

Infine, l’azienda mette in evidenza che, in Microsoft, l’IA responsabile è un principio fondamentale che guida lo sviluppo e l’implementazione dei sistemi AI, compresi i modelli Phi, che sono sviluppati in conformità ai principi dell’IA di Microsoft: responsabilità, trasparenza, equità, affidabilità e sicurezza, privacy e sicurezza e inclusione.

La famiglia di modelli Phi ha adottato un robusto approccio di sicurezza post-training, sfruttando una combinazione di tecniche di Supervised Fine-Tuning (SFT), Direct Preference Optimization (DPO) e Reinforcement Learning from Human Feedback (RLHF). Questi metodi utilizzano vari insiemi di dati, tra cui quelli disponibili pubblicamente e incentrati sulla disponibilità e l’innocuità, oltre a varie domande e risposte relative alla sicurezza. Sebbene la famiglia di modelli Phi sia progettata per svolgere efficacemente un’ampia gamma di compiti, è importante riconoscere che tutti i modelli di intelligenza artificiale possono presentare dei limiti. Per comprendere meglio questi limiti e le misure adottate per risolverli, Microsoft rimanda alle model cards, che forniscono informazioni dettagliate sulle pratiche e sulle linee guida dell’IA responsabile.