Ciao a tutti, sono Vincenzo Lomonaco, ricercatore e docente all’Università di Pisa.

Nella puntata di oggi ci concentriamo su uno strumento davvero interessante e recente su cui abbiamo glissato in realtà troppo nelle nostre recenti puntate di questa rubrica.

Oggi parliamo di Deep Research e di come è possibile usufruire, spesso gratuitamente, di questo servizio per la creazione di report dettagliati a fronte di quesiti complessi di ricerca.

Di cosa si tratta nel dettaglio e come è stato possibile creare uno strumento così potente? Come funziona? Nella pratica si tratta di una funzione offerta solo da Gemini e OpenAI o esistono altre alternative? Scopriamolo insieme in questa puntata di Le Voci dell’AI.

Le funzionalità di Deep Research, di ricerca approfondita basate sull’AI rappresentano un’evoluzione significativa nel modo in cui le informazioni vengono analizzate, ricercate e sintetizzate.

Questi strumenti, introdotti per la prima volta da Google con Gemini Deep Research nel gennaio 2025, sono progettati per automatizzare il processo di ricerca, consentendo di esplorare il web, analizzare fonti accreditate e generare report esaustivi.

Gemini ha segnato un punto di svolta perché non si limitava a restituire semplici risultati di ricerca, ma strutturava le informazioni in modo approfondito, citando le fonti e offrendo analisi contestuali.

Questa innovazione ha portato OpenAI a lanciare, poco dopo, una funzione simile all’interno di ChatGPT Advanced Research, in grado di navigare automaticamente tra studi scientifici, articoli accademici e dati in tempo reale, elaborando risposte basate su correlazioni avanzate e valutazioni critiche delle fonti.

La risposta di altri competitors non si è fatta attendere. Anche Anthropic ha sviluppato Claude Deep Research, con un focus sull’interpretazione semantica avanzata. Grok di xAI ha una sua funzione di search, anch’essa gratuita.

Microsoft ha potenziato Copilot Research integrandolo direttamente con Bing e altri strumenti aziendali e Meta ha introdotto recentemente il suo tool di AI Discovery, specializzato nella ricerca di contenuti social e trend emergenti.

Questi sistemi vanno quindi oltre la ricerca tradizionale, utilizzano modelli di linguaggio multimodali, analizzano il contesto delle fonti per verificarne l’affidabilità e riescono a elaborare ipotesi interpretative su argomenti anche molto complessi.

L’aspetto forse più interessante rivoluzionario è la loro capacità di raffinamento iterativo, che consente di affinare quindi la ricerca in base alle domande, alle richieste specifiche dell’utente, simulando il lavoro di un analista esperto.

Tuttavia emergono anche delle criticità: la trasparenza delle fonti utilizzate, i bias algoritmici e la necessità di verifica umana, che restano comunque temi aperti.

Nonostante questo, la corsa alla leadership dell’AI driven research continua a spingere miglioramenti continui in questa direzione, con nuovi strumenti in arrivo che promettono di ridefinire il concetto stesso di ricerca digitale.

In termini di accessibilità alle soluzioni di Deep Research con AI, variano in qualità tempi di attesa e prezzi.

Google Gemini offre una versione gratuita con ricerche limitate e un piano avanzato a 20 € al mese con risposte in 30-90 secondi per questo tipo di ricerca.

ChatGPT Advanced Research di OpenAI, incluso in ChatGPTPlus a 20 € al mese, elabora dati in 45-120 secondi, Grok di xAI ha una versione di base per la ricerca gratuita e un piano anche premium di 30- 40 $ al mese a seconda delle funzionalità richieste.

Claude, nella sua funzionalità di DeepSearch e Microsoft Copilot Research offrono prove gratuite anch’essi e piani a partire da 30 $ al mese, con risposte sempre in pochi minuti di attesa dipendendo molto dalla complessità della ricerca.

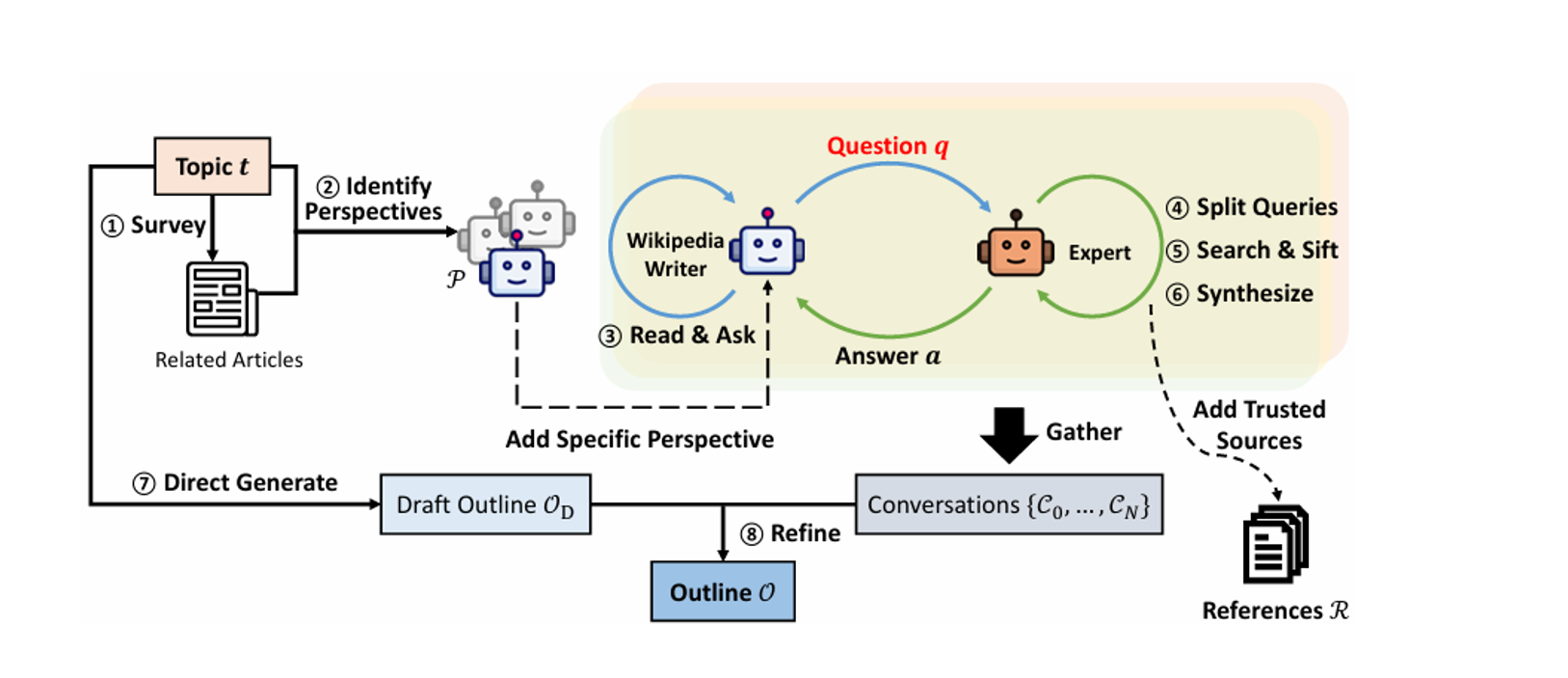

In questa immagine vediamo una possibile implementazione di uno strumento di Deep Research che integra intelligenza artificiale e fonti esperte per produrre contenuti informativi affidabili.

Questa metodologia è alla base di Storm, un’implementazione open source dell’Università di Stanford, inizialmente progettata per aiutare nella scrittura di articoli livello Wikipedia.

Il processo inizia, come vedete, con una fase di Survey, fase uno, in cui vengono analizzati articoli correlati a un certo argomento – topic t.

Successivamente, in fase due vengono identificate diverse prospettive, quindi visioni sullo stesso rappresentate da diversi agenti AI.

la fase tre prevede un’interazione tra questi agenti e modelli, Large Language Models, esperti di diversi argomenti, dove l’intelligenza artificiale formula domande aggiuntive q e riceve risposte a.

Per affinare la ricerca, le domande vengono poi suddivise in domande ancor più piccole della fase quattro e i dati vengono raccolti e selezionati nella fase cinque, per poi essere sintetizzati nella sei, incorporando poi fonti affidabili R che vediamo in basso a destra.

I risultati vengono utilizzati per arricchire una bozza di struttura Od di fase sette, che può essere generata direttamente oppure raffinata ulteriormente attraverso conversazioni da C0 a Cn nella fase otto, ottenendo quindi un sommario definitivo del report da generare.

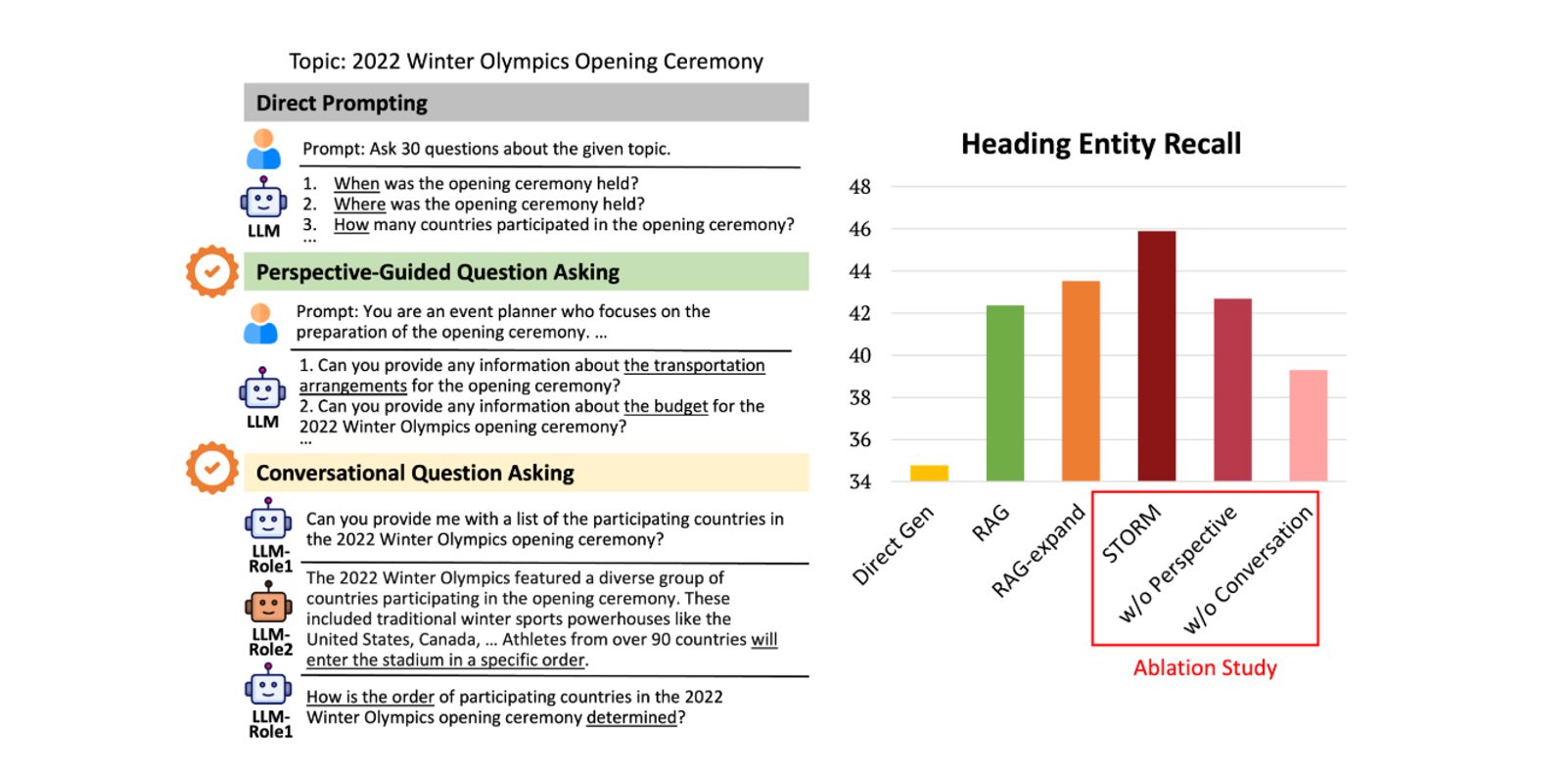

In questa immagine invece, vediamo un esempio di prompting per la generazione di un report sulla cerimonia di apertura delle Olimpiadi invernali del 2022, per esempio, e la valutazione dei risultati, ossia quanto accurato il report risulta in termini di recupero di informazioni chiave rispetto al report generati da umani.

In particolare sono illustrate tre metodologie principali: quella del Direct Prompting, che genera domande semplici e dirette per guidare la stesura del report; il Perspective-Guided Question Asking, che utilizza prospettive e idee specifiche per indirizzare meglio le richieste e il Conversational Question Asking, che simula un’interazione multi turno tra diversi agenti e con ruoli distinti.

Nella parte sinistra dell’immagine vediamo esempi concreti di questi approcci.

Il dare promoting genera domande molto generiche, come quando si è tenuta la cerimonia d’apertura a dove si è svolta senza fornire un contesto specifico.

La Perspective-guided Question Asking, invece, adotta un’ottica più focalizzata: il modello viene istruito come un organizzatore di eventi e formula domande mirate, ad esempio sulla logistica e il budget della cerimonia.

Infine, il Conversational Question Asking simula un interazione tra diversi agenti Large Language Models con ruoli distinti.

Un modello chiede informazioni sui partecipanti e un altro risponde con un riepilogo dettagliato.

Il primo genera domande di follow up, come quella sull’ordine di ingresso delle delegazioni.

Il grafico a destra, invece, confronta le prestazioni di questi approcci, inclusa la generazione diretta di una risposta.

La creazione del report, l’utilizzo di metodologie di Retrieval Augmented Generation – RAG, come spiegato nell’episodio 55 di Le Voci dell’AI e la metodologia Storm appena introdotta.

I risultati evidenziano che Storm ottiene il miglior risultato, quindi confermando che l’integrazione di contesti e dialoghi multi agente migliora la qualità delle informazioni estratte.

Bene, in questa puntata abbiamo discusso di questa tecnologia di Deep Research fino a poco tempo fa davvero impensabile da realizzare con questa qualità.

Oggi quindi, scrivere articoli giornalistici, report scientifici o commerciali complessi scandagliando il web in maniera completamente automatica non sembra più così impossibile.

Soluzioni open source come Storm ci spiegano come sia possibile implementarne uno con metodologie multi agente altamente efficaci e paralelizzate e strumenti come Gemini o OpenAI Deep Search evidenziano come prodotti commerciali possano essere ingegnerizzati per offrire valide soluzioni per ricerche complesse che richiederebbero magari ore di tempo per essere effettuate da professionisti In una manciata di minuti.

Nel futuro mi aspetto significative migliorie nello sviluppo di questi strumenti, soprattutto migliorando le modalità interattive di raffinamento del contenuto generato, visto che la difficoltà più grossa non sembra tanto essere quella della ricerca o scrittura del report, ma far capire esattamente a queste intelligenze artificiali il nostro reale bisogno informativo.

Ciao! Alla prossima puntata di Le Voci dell’AI!