Ciao a tutti, sono Vincenzo Lomonaco, professore associato presso l’Università Luiss Guido Carli e per la puntata di oggi vorrei parlarvi di Embodied AI, AI incarnata o meglio incorporata, in italiano, e di quanto questa idea di dare un corpo all’intelligenza artificiale sia strumentale al suo sviluppo di capacità sempre più sofisticate? Di cosa si tratta e quanto è vicino questo concetto al mondo della robotica che da sempre cerca di dare un corpo alle macchine? Non è sufficiente andare nella direzione di dispositivi indossabili come gli occhiali intelligenti che possono fungere da ponte tra la realtà percettibile e un cervello digitale onnisciente e connesso a Internet? Scopriamolo insieme in questa puntata di Le Voci dell’AI.

Come sapete, recentissimamente all’AI Meta Connect 2025, l’azienda di Zuckerberg ha presentato la nuova generazione di occhiali intelligenti, un passo che va ben oltre la semplice evoluzione dei Ray-Ban storici.

Si tratta di dispositivi pensati per diventare la porta d’accesso quotidiana all’intelligenza artificiale di punta di Meta, ovvero Meta AI e di modelli Llama che abbiamo discusso molte volte in questa rubrica.

Le novità principali includono la possibilità di interagire con l’assistente AI in tempo reale attraverso comandi vocali o gestuali, la traduzione istantanea, la gestione di notifiche contestuali e persino l’assistenza visiva tramite un piccolo display integrato capace di fornire indicazioni passo passo durante attività pratiche come cucinare o muoversi in città.

In questo senso, gli occhiali rappresentano la concretizzazione della visione di Meta: integrare l’AI non soltanto in software e app, ma in un oggetto fisico da indossare, che diventi parte naturale della vita quotidiana e che trasformi il concetto stesso di interfaccia uomo macchina oltre i display digitali.

È un approccio che rispecchia ciò che anche OpenAI sta cercando di fare, ossia legare il proprio modello linguistico avanzato a un hardware personale, così da ridurre la distanza tra l’AI e l’utilizzo diretto.

Questo parallelismo è emerso chiaramente anche nella discussione dell’episodio 115, dove abbiamo sottolineato come la sfida per entrambe le aziende non sia soltanto tecnologica ma anche culturale: convincere le persone ad adottare un nuovo dispositivo come estensione naturale di sé.

Certo, il lancio non è stato privo di imperfezioni, con alcune demo dal vivo che hanno mostrato bug imprevisti e momenti di imbarazzo, quasi a sottolineare l’immaturità del prodotto, almeno ad oggi.

Tuttavia, l’idea di fondo rimane potente: portare l’IA al di fuori dello schermo, dagli schermi e dentro un accessorio quotidiano, incarnando la promessa di un futuro in cui l’assistente virtuale non vive più confinato in una app, ma cammina insieme a noi, silenzioso e sempre pronto a intervenire.

Il lancio degli occhiali intelligenti al Meta Connect rappresenta senza dubbio un passo cruciale nella strategia AI di Meta.

Non soltanto un tentativo di portare l’AI fuori dallo schermo e dentro la vita quotidiana delle persone, ma soprattutto un modo per acquisire una quantità senza precedenti di dati sul comportamento umano, sulle interazioni sociali e sul contesto ambientale in cui ci muoviamo.

Grazie a microfoni, videocamere e sensori, questi dispositivi hanno il potenziale di registrare come gli utenti parlano, agiscono e reagiscono nel mondo reale, creando un flusso di informazioni multimodali che arricchiscono enormemente il processo di addestramento dei modelli di AI.

Tuttavia, per quanto questo rappresenti un vantaggio competitivo in termini di raccolta dati, non si tradurrà automaticamente in un salto qualitativo verso intelligenze artificiali radicalmente più intelligenti delle precedenti.

La ragione è strutturale: questi sistemi, anche quando esposti a esperienze quotidiane attraverso i sensori degli occhiali, rimangono spettatori dalla realtà, si limitano a osservare correlazioni tra ciò che vedono, sentono o leggono e le azioni conseguenti degli utenti. Ma non sviluppano un’autonomia e un’autonoma capacità di inferire le cause profonde degli eventi.

In altre parole, apprendono sequenze e associazioni, ma non costruiscono un vero modello causale del mondo.

Senza questa dimensione l’AI continuerà a migliorare nella predizione e nella reazione, ma resterà confinata entro i limiti di un apprendimento statistico correlativo che non permette di generare vera comprensione o capacità di ragionamento indipendente.

È un po come guardare innumerevoli filmati della realtà. Si diventa molto bravi senz’altro a prevedere cosa accadrà in determinate circostanze, ma non si acquisisce mai la consapevolezza profonda del perché le cose accadono in un certo modo e non altrimenti.

Per superare questo limite servirà un cambio di paradigma in cui l’intelligenza artificiale non si limiti a osservare e correlare, ma sia capace di sperimentare, intervenire, generare ipotesi e verificarle in autonomia. In altre parole, passare dalla statistica alla causalità.

Gli occhiali intelligenti, pur innovativi e strategicamente rilevanti per metà non bastano a colmare questo divario. Sono una finestra più ampia sulla realtà, ma non è ancora lo strumento che permetterà alle macchine di comprenderla davvero.

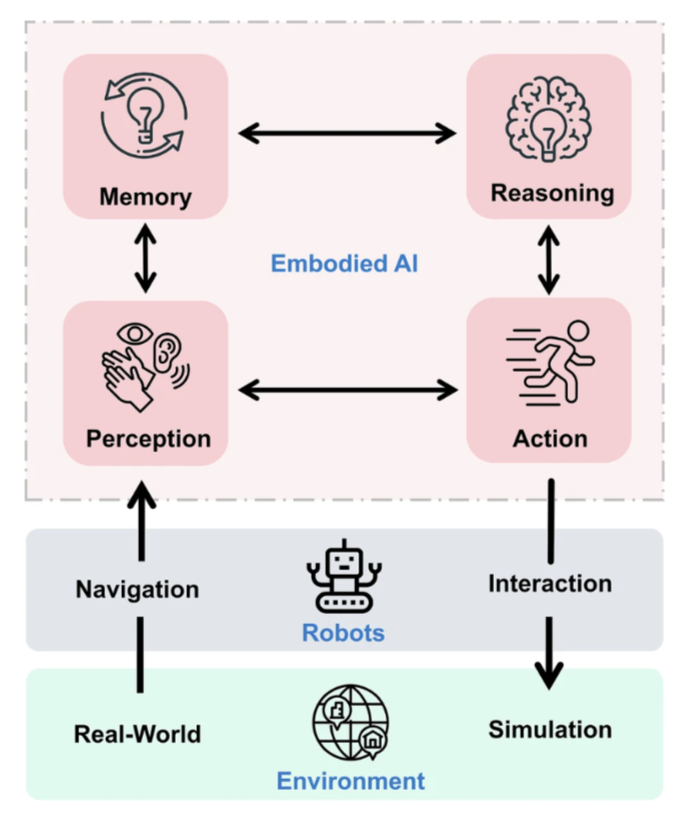

L’immagine che osserviamo sintetizza in modo chiaro il cuore del concetto di embodied AI, un sistema in cui memoria, ragionamento, percezione e azione non sono compartimenti stagni, ma elementi intrecciati in un ciclo continuo di apprendimento.

La parte superiore dello schema mostra come la memoria dialoghi con il ragionamento e come percezione e azione siano collegate tra loro. Insieme formano la mente incarnata delle macchine.

Ma ciò che rende questo approccio radicalmente diverso dai modelli tradizionali è il collegamento diretto con l’ambiente rappresentato in basso. Attraverso la robotica che funge da corpo fisico, l’AI può navigare nel mondo reale e interagire con oggetti e persone, persino sperimentare scenari simulati.

Questo legame tra intelligenza e corpo riproduce in chiave tecnologica il processo che un neonato attraversa quando impara a conoscere la realtà, osserva, interagisce, riceve feedback e costruisce così un modello causale del mondo.

Diversamente dai modelli linguistici o multimodali che restano spettatori passivi, un sistema embodied può risultare migliore, sviluppare comprensione profonda del perché gli eventi accadono e non solo del come si presentano.

L’immagine rende quindi evidente questa dinamica ciclica: percepire, agire, ricordare e ragionare in un loop che col tempo rafforza l’autonomia della macchina.

La robotica, ovviamente, che ha già compiuto progressi straordinari in navigazione e manipolazione, fornisce dunque il terreno ideale perché questa incorporata possa crescere e adattarsi.

Questa riflessione apre scenari di grande potenzialità: macchine che non si limitano a reagire in base a regole preprogrammate, ma che apprendono e si adattano come veri agenti intelligenti.

Tuttavia, è bene sottolineare anche l’altro lato della medaglia più le macchine acquisiscono autonomia, più si rafforza la necessità di gestire i rischi legati a decisioni indipendenti prese in contesti complessi e anche piuttosto importanti.

L’embodied AI in simbiosi con la robotica è la chiave per costruire l’IA del futuro, dotata finalmente di comprensione causale del mondo.

Ma richiederà un’attenzione altrettanto sofisticata alle implicazioni etiche e di sicurezza.

Ciao! Alla prossima puntata di Le Voci dell’AI.