Ciao a tutti, sono Vincenzo Lomonaco, ricercatore e docente all’Università di Pisa.

Nella puntata di oggi cerchiamo di rispondere a un quesito molto interessante: perché OpenAI, una, se non l’organizzazione più importante nel contesto dell’AI moderna sta pensando di sviluppare e costruire un dispositivo fisico? Perché una società che fa principalmente software sta pensando di entrare in un mercato e in una filiera, quella dei dispositivi digitali ed elettronici, così competitiva e complessa? Scopriamolo insieme in questa puntata di Le Voci dell’AI.

Negli ultimi mesi OpenAI è stata protagonista di una serie di vicende che hanno attirato grande attenzione mediatica, sia per le mosse strategiche nel settore dell’hardware, sia per alcune dispute legali che hanno contribuito a svelare in anticipo parte delle sue intenzioni/ Al centro della narrazione c’è la prospettiva di un cosiddetto iPhone moment per l’intelligenza artificiale, ossia il momento in cui un nuovo dispositivo, capace di incarnare in modo semplice e rivoluzionario le potenzialità dell’AI, riuscirà a ridefinire l’esperienza degli utenti, così come l’iPhone di Apple fece nel 2007 con la telefonia mobile.

E in questo scenario OpenAI sta tentando di diventare l’attore determinante, non limitandosi più a offrire software e modelli di AI all’avanguardia, ma cercando di costruire anche un oggetto fisico che possa diventare il punto di incontro naturale tra persone e intelligenza artificiale.

Il passo più significativo in questa direzione è stato l’acquisizione di io Products, start-up hardware fondata dall’ex guru del design di Apple John Ive, operazione, dal valore stimato in circa 6,5 miliardi di dollari, che ha segnato la volontà di OpenAI di affiancare le proprie competenze di ricerca e sviluppo a un know-how di design e progettazione industriale di livello assoluto, dato che Ive è stato l’artefice della filosofia estetica e funzionale dei prodotti Apple degli anni ’90 fino al lancio dell’iPhone e oltre, costruendo se vogliamo, un’eredità che ancora oggi è considerata modello nel settore.

Con questa acquisizione, OpenAI ha dichiarato di voler creare un nuovo ecosistema hardware e software in cui l’AI generativa non sia solo un servizio accessibile via app o browser, ma un’esperienza immediata e pervasiva, integrata in un device dedicato e potenzialmente in grado di affiancarsi o addirittura sostituirsi in alcuni contesti allo smartphone.

Altman ha infatti accennato pubblicamente all’idea che nella vita delle persone si possano affiancare tre dispositivi fondamentali il computer, il telefono e questo nuovo oggetto, ancora non ben identificabile, che potrebbe diventare il terminale privilegiato dell’interazione con l’AI, capace di leggere il contesto, rispondere in tempo reale e agire come assistente sempre presente.

I dettagli del progetto restano avvolti nella riservatezza, ma alcuni indizi sono emersi grazie a una causa per violazione di marchio intentata da una piccola azienda chiamata iyO, che produce dispositivi auricolari intelligenti, la quale ha accusato OpenAI e io Products di confondere i consumatori con un nome troppo simile e potenzialmente concorrenziale.

La disputa legale ha portato quindi alla pubblicazione di documenti in tribunale che hanno chiarito almeno un punto cruciale: il dispositivo di OpenAI non sarà né un auricolare né un indossabile tradizionale, quindi non si tratterà di cuffiette smart o di occhiali di realtà aumentata o virtuale, ma di qualcosa di diverso, un oggetto che può stare su una scrivania o essere portato con sé.

Un compendio, un device capace di fornire interazione contestuale senza la necessità di grandi schermi.

Dunque una tipologia nuova che ambisce a inaugurare una categoria ancora inesplorata.

Secondo indiscrezioni, il design è in lavorazione da oltre un anno, ma non è stato ancora finalizzato e non ci si aspetta un lancio sul mercato prima del 2026, a conferma del fatto che OpenAI e il team di Ive stanno dedicando tempo a rifinire sia l’aspetto fisico sia l’integrazione con i modelli linguistici più avanzati dell’azienda.

L’idea di fondo sembra essere quella di un oggetto semplice e naturale che non imponga all’utente di adattarsi, ma che sappia inserirsi in modo fluido nelle azioni quotidiane.

Proprio per questo l’analogia con l’iPhone è tornata più volte nei commenti di analisti e giornalisti.

Perché, come allora, si trattò di passare da un telefono con tasti e funzioni frammentate a un hub digitale integrato.

Così oggi si ipotizza un passaggio da chatbot e interfacce testuali e vocali a un compagno fisico che renda le app costantemente disponibile.

Va poi considerato che OpenAI si trova in un momento cruciale della propria evoluzione: da un lato insegue il sogno di un dispositivo hardware capace di rappresentare il momento iPhone dell’intelligenza artificiale, dall’altro deve affrontare una necessità strutturale che spesso rimane sullo sfondo, cioè l’accesso ai dati.

I modelli di AI di ultima generazione hanno infatti già sfruttato, come abbiamo detto più volte, in questa rubrica, gran parte dei dati pubblici contenuti nel web e l’ulteriore miglioramento della loro qualità dipende dalla possibilità di raccogliere nuove informazioni fresche, contestuali e soprattutto generate dall’interazione diretta con gli utenti.

Qui emerge sicuramente un divario importante, competitivo che separa OpenAI dai giganti dell’IT come Google, Microsoft o Amazon.

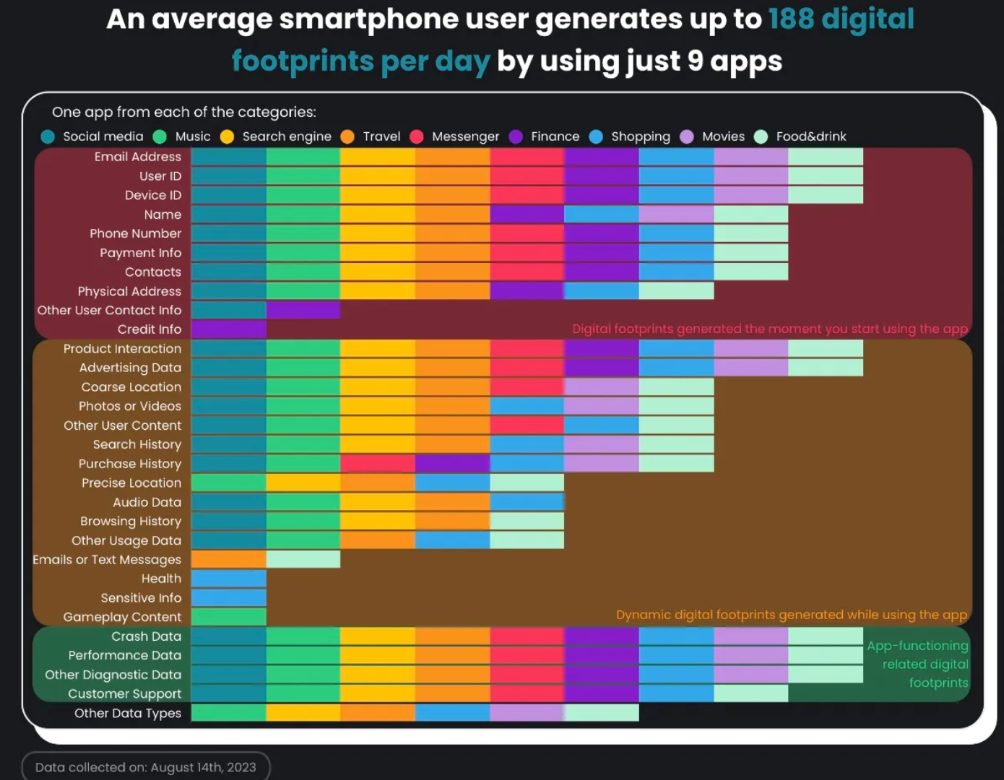

In questa immagine vediamo in modo molto chiaro quanto ogni utente generi una quantità enorme di dati semplicemente utilizzando le app quotidiane sul proprio smartphone, senza quasi accorgersene.

Secondo quest’analisi, bastano appena nove applicazioni diverse tra social media, musica, motori di ricerca, viaggi, messaggistica, finanza, shopping, film e cibo per produrre fino a 188 tracce digitali al giorno.

Ogni app raccoglie infatti una gamma impressionante di informazioni, dalle mail al numero di telefono, dai dati di pagamento alle abitudini di navigazione, dalle foto e i video fino alla posizione precisa ai contatti.

Senza contare informazioni sensibili come salute, cronologia di ricerca, messaggi o interazioni vocali.

A questo si aggiungono i dati tecnici sul funzionamento stesso del dispositivo, come crash report, performance e diagnostica.

In pratica, vivere con uno smartphone oggi significa alimentare costantemente un flusso dinamico di dati che non smette mai di crescere, diventando la linfa vitale per le grandi aziende tecnologiche che basano i loro modelli di AI anche sull’analisi di queste informazioni.

E proprio in questo contesto che si inserisce l’interesse di OpenAI a sviluppare il proprio hardware.

Non si tratta solo di controllare meglio l’esperienza utente, ma di accedere direttamente a una nuova fonte di dati freschi e contestuali, indispensabili per mantenere competitivi i suoi modelli di AI.

OpenAI, quindi, guarda al futuro con una doppia ambizione: da un lato garantire un flusso costante di dati per sostenere e migliorare i propri modelli, dall’altro provare a immaginare un nuovo modo di vivere la tecnologia, superando la mediazione continua degli schermi.

L’idea di un dispositivo che renda l’intelligenza artificiale accessibile in maniera discreta, contestuale, naturale, rappresenta la vera scommessa liberare gli utenti dalla necessità di guardare e toccare un display per ogni interazione, offrendo un’esperienza meno invasiva e più armonica con la vita quotidiana.

Potrebbe questo infatti segnare l’inizio di una nuova era digitale? Ciao! Alla prossima puntata di Le Voci dell’AI.