Ciao a tutti, sono Vincenzo Lomonaco, ricercatore e docente all’Università di Pisa.

Nella puntata di oggi parliamo di GPT-5, l’ultimissimo modello fondazionale e multimodale rilasciato da OpenAI: il modello migliore mai rilasciato da OpenAI, tanto atteso dal pubblico che alimenta l’intelligenza di ChatGPT e che viene descritto dai suoi stessi inventori come a livello di un dottorando in qualsiasi disciplina.

Si tratta davvero di un significativo passo in avanti o di un piccolo avanzamento incrementale? Cosa pensa la comunità scientifica di intelligenza artificiale? È ancora questa la strada che ci porterà all’intelligenza artificiale generale? Scopriamolo insieme in questa puntata di Le Voci dell’AI.

Durante la pausa estiva OpenAI ha annunciato il rilascio di GPT-5, presentandolo come il sistema di intelligenza artificiale più avanzato e utile mai costruito dall’azienda.

Rispetto ai modelli precedenti, questo nuovo passo mostra miglioramenti importanti in diversi ambiti, dalla matematica dove raggiunge risultati paragonabili a quelli di esperti umani, alla scrittura di codice, alla comprensione multimodale, cioè la capacità di interpretare testo, immagini e suoni insieme, fino all’analisi di testi scientifici complessi.

Come siamo già stati abituati in passato, c’è anche una versione Pro, pensata per ragionamenti più lunghi e approfonditi, che porta le prestazioni a livelli davvero notevoli.

GPT-5, inoltre, introduce una novità strutturale: è in grado di decidere autonomamente se rispondere in modo rapido e diretto oppure se attivare una modalità di ragionamento esteso, molto più lenta ma anche più accurata.

Questo lo rende non solo più potente, ma anche più efficiente, perché produce meno parole inutili e allo stesso tempo riduce le cosiddette allucinazioni, cioè le risposte sbagliate o inventate, con un miglioramento stimato dal team di OpenAI tra il 40 all’80% rispetto al modello precedente.

Per arrivare a questo risultato, è bene sottolinearlo, sono serviti oltre due anni di lavoro, se consideriamo che GPT-4 era stato rilasciato nel 2023 e che la prima versione di GPT basata su GPT 3.5 era apparsa a fine 2022.

Ogni passaggio è stato un mattone fondamentale per costruire l’attuale sistema: dal primo GPT, pensate nel 2018, che era ancora un esperimento limitato fino a GPT-2 e GPT-3 che hanno mostrato al mondo la potenza dei grandi modelli linguistici e poi GPT-4 che ha segnato l’ingresso nelle applicazioni quotidiane.

Grazie a ciò GPT-5 non nasce dal nulla: è il risultato di questo lungo percorso evolutivo alla base del successo incredibile di OpenAI.

Tuttavia, dopo l’entusiasmo iniziale, le reazioni a GPT-5 non sono state tutte positive.

Molti osservatori e utenti hanno sottolineato come i miglioramenti, pur reali e misurabili, non rappresentino quel salto epocale che ci si aspettava.

Se il passaggio da GPT-2 a GPT-3 aveva sorpreso e stupito il mondo, mostrando per la prima volta la capacità di generare testi credibili e coerenti, e se GPT-4 aveva ulteriormente consolidato questa impressione introducendo multimodalità e maggiore affidabilità, con GPT-5 la sensazione diffusa è stata diversa.

Alcuni parlano di un’evoluzione più che di una rivoluzione, un aggiornamento incrementale che affina ciò che già esisteva, ma senza aprire scenari radicalmente nuovi.

Questa percezione ha alimentato una certa disillusione. C’era chi immaginava che GPT-5 potesse avvicinarsi davvero all’intelligenza artificiale generale, o almeno mostrare capacità emergenti sorprendenti.

E invece ci si è trovati di fronte a un modello sì più solido, più efficiente, ma sostanzialmente simile a quello precedente.

Da qui nascono anche critiche più profonde e metodologiche: che forse la crescita lineare, tramite il semplice aumento della scala, stia rallentando, che le risorse spese non producano più ritorni proporzionali e che il settore abbia bisogno di nuove idee e non solo di più potenza di calcolo o più dati.

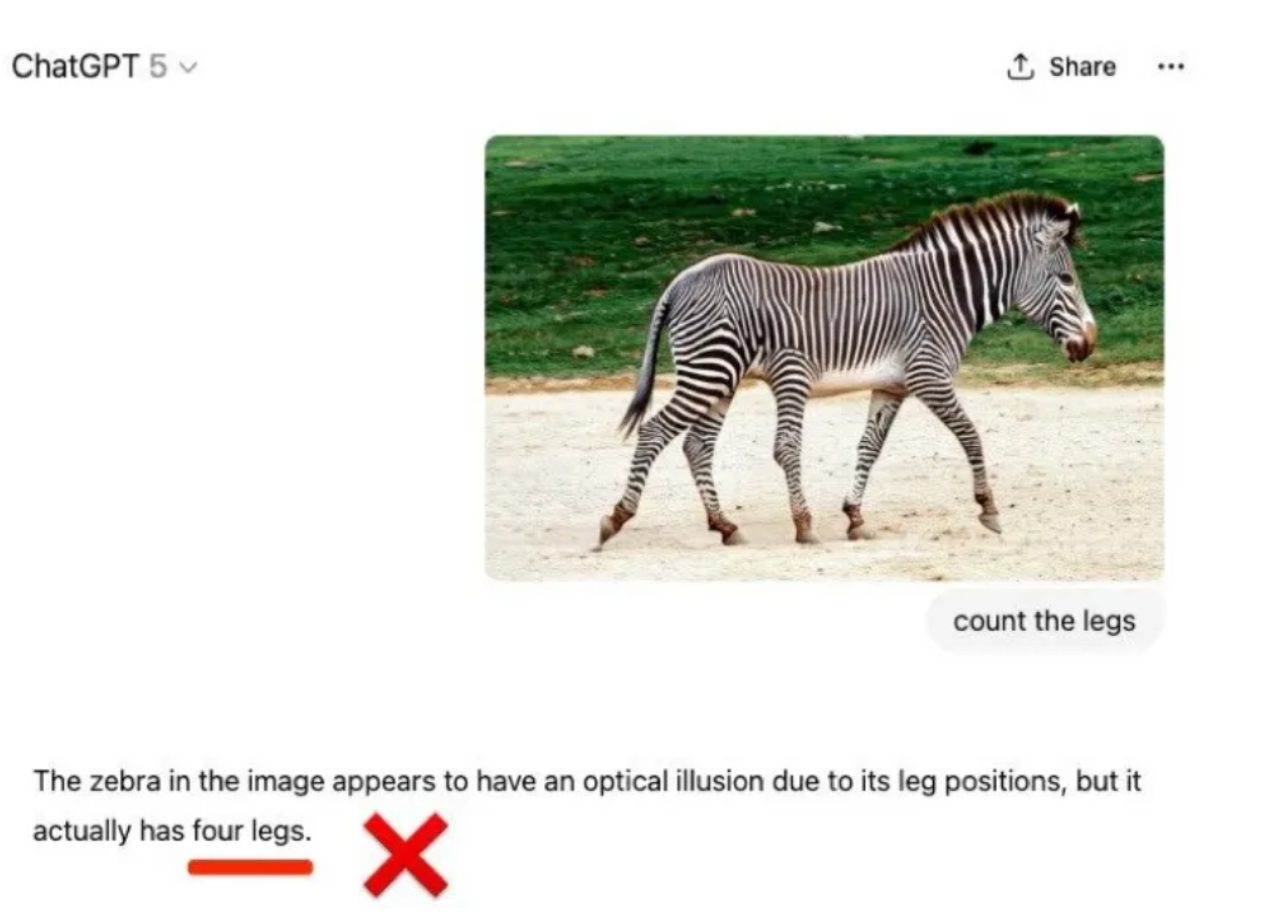

Questa immagine è un esempio interessante per capire i limiti di GPT-5.

Alla richiesta di contare le zampe della zebra, il modello dichiara che l’animale ne ha quattro, attribuendo l’ambiguità a una semplice illusione ottica.

In realtà, osservando attentamente si nota che la foto è stata modificata in modo tale da far apparire più zampe del normale.

Qui non basta ripetere la regola generale: le zebre hanno quattro zampe, servirebbe un’osservazione visiva accurata e un ragionamento logico per distinguere l’anomalia.

L’errore di GPT-5 nasce proprio da questo: il modello non ragiona come un essere umano, ma produce risposte sulla base di correlazioni statistiche tra le parole.

Quando incontra un’immagine che mette in crisi le aspettative, tende a forzare una spiegazione plausibile senza realmente vedere, e contare, in questo caso, e interpretare la scena.

È una chiara dimostrazione pratica del fatto che non possiede comprensione visiva o cognizione del mondo come ci aspetteremmo, ma applica pattern linguistici appresi in fase di addestramento.

Episodi come questo smontano l’idea che GPT-5, per quanto potente, quindi, abbia capacità di ragionamento generale.

Resta uno strumento utilissimo per moltissime applicazioni, ma esempi concreti come questo ci ricordano che non si tratta di un’intelligenza autonoma: è ancora vincolato al suo funzionamento puramente statistico.

Un altro spunto utile per capire i limiti di GPT-5 e dei modelli linguistici più in generale viene da un articolo che ha fatto molto discutere recentemente la comunità scientifica: “Is Chain-of-Thought Reasoning of LLMs a Mirage? A Data Distribution Lens” Lo studio mette in discussione una delle tecniche più usate per migliorare le prestazioni di questi modelli, cioè il cosiddetto Chain-of-Thought, la catena del pensiero che abbiamo già discusso nell’episodio 73 di questa rubrica.

Si tratta di quella strategia per cui al modello si chiede di ragionare passo passo invece che dare subito la risposta finale, con l’idea che esplicitare i passaggi logici attraverso dei processi linguistici lo aiuti ad arrivare a delle conclusioni corrette.

L’articolo però mostra che questa abilità non è reale ragionevolezza, ma piuttosto il risultato di correlazioni statistiche ancora una volta apprese nei dati di addestramento.

In pratica, quando il problema assomiglia a schemi già visti, il modello sembra ragionare, ma quando si discosta dalle sequenze logiche più comuni fallisce anche clamorosamente, producendo catene di pensiero che appaiono sensate ma che portano a risposte errate.

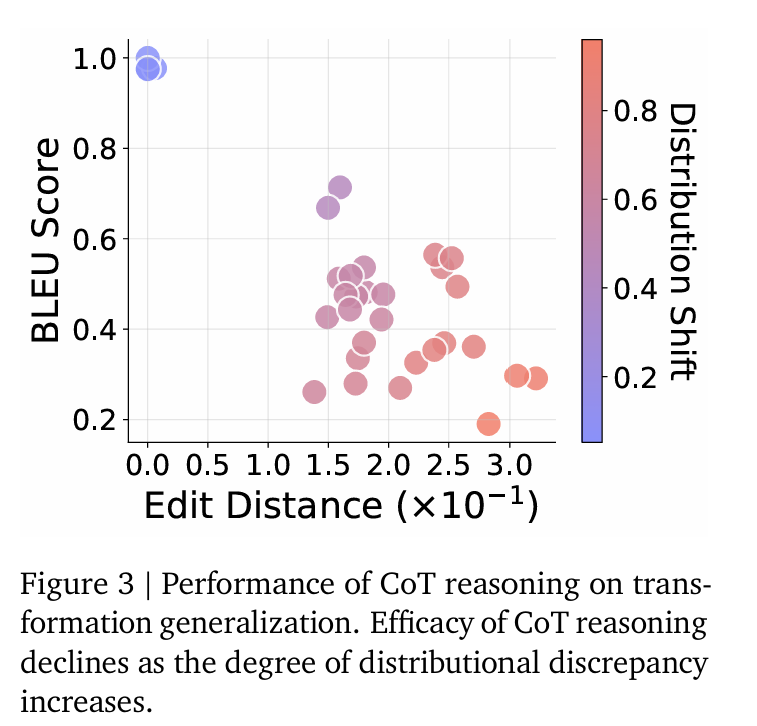

Questa figura, tratta dall’articolo, mostra in modo visivo il punto centrale della critica al cosiddetto Chain-of-Thought.

Sull’asse orizzontale vediamo l’Edit Distance, cioè la misura di quanto un compito si discosti da quelli su cui il modello è stato addestrato.

Sull’asse verticale compare il punteggio BLEU, che qui rappresenta la qualità delle risposte generate.

Il colore dei pallini, invece, indica il livello di distribution shift, cioè di quanto la distribuzione statistica di nuovi esempi di ragionamento si allontani da quella originale dei dati visti dal modello.

Ciò che emerge è molto chiaro quando i problemi sono molto simili a quelli già noti, quindi con bassa distanza e poco cambiamento di distribuzione, il modello ottiene punteggi molto alti, vicini a 1, dando l’impressione di ragionare correttamente; man mano che ci si sposta verso compiti più distanti e meno familiari, la qualità crolla nettamente, scendendo fino a valori attorno allo 0,2-0,3.

In altre parole, l’efficacia del ragionamento passo passo diminuisce drasticamente non appena i dati si discostano dagli schemi abituali.

Questo mette in evidenza un punto cruciale i modelli come GPT-5 non comprendono davvero i problemi, ma imitano stili di ragionamento frequenti nei dati.

È una critica pesante perché ridimensiona l’idea che basti aumentare scala e complessità per ottenere vera intelligenza e per alcuni sembrerebbe decretare la fine di un’era, quella dei modelli basati esclusivamente sul generative retraining – GPT.

Ciao! Alla prossima puntata di Le Voci dell’AI.