Ciao a tutti, sono Vincenzo Lomonaco ricercatore e docente all’Università di Pisa.

Nella puntata di oggi ci concentriamo sulla nuova ondata di entusiasmo per l’AI agentica e di una sua implementazione come collettivo, collezione di modelli e funzioni specializzate, invece di un unico enorme modello di AI con capacità sovrumane.

Si tratta quindi dell’emergere di una nuova direzione di frontiera per lo sviluppo di soluzioni di intelligenza artificiale.

Cosa può suggerirci il recente rilascio di OpenAI Agents SDK, in modalità open source? Scopriamolo insieme in questa puntata di Le Voci dell’AI.

OpenAI ha recentemente annunciato il rilascio di Agents SDK, una libreria open source progettata per semplificare la creazione di applicazioni di agenti.

Questa libreria consente agli sviluppatori e ai programmatori di costruire applicazioni in cui un modello di linguaggio di grandi dimensioni, un Large Language Model può utilizzare strumenti e delegare compiti ad altri agenti o modelli per completare attività sempre più complesse.

Agents SDK fornisce quindi primitive essenziali come gli agenti, che sono Large Language Models configurati con istruzioni e strumenti specifici, le deleghe, che permettono agli agenti di affidare compiti ad altri agenti specializzati e i guardrail che garantiscono la validazione degli input agli agenti.

Questo rilascio rappresenta un miglioramento significativo rispetto al precedente esperimento di OpenAI denominato Swarm, offrendo una soluzione più leggera e ingegnerizzata, facile da usare per orchestrare flussi di lavoro complessi multiagente.

La decisione di OpenAI di rilasciare Agents SDK come open source è strategica e mira a coinvolgere la comunità degli sviluppatori nella risoluzione delle sfide legate all’affidabilità e anche l’efficacia degli agenti di AI di frontiera.

OpenAI sostanzialmente con questa operazione riconosce che la complessità dello sviluppo di agenti affidabili richiede competenze diversificate e intende sfruttare l’innovazione esterna all’azienda per migliorare continuamente la sua piattaforma.

Questo approccio aperto facilita l’integrazione con altri strumenti e promuove la standardizzazione nello sviluppo di agenti di AI, riducendo la frammentazione e semplificando l’adozione da parte delle imprese, senz’altro.

Inoltre, l’open source consente una maggiore trasparenza e collaborazione, accelerando l’evoluzione delle capacità delle aziende e favorendo l’adozione di soluzioni più robuste e efficienti nel contesto aziendale.

Questo quindi, rappresenta un cambio strategico di drammatica importanza per OpenAI.

Il rilascio dell’Agents SDK come open source rappresenta una mossa strategica di OpenAI per consolidare la sua posizione nel panorama delle IAI aziendale, promuovendo l’innovazione collaborativa, laddove altre aziende e realtà come DeepSeek e LangChain, che vedremo dopo, hanno dimostrato che non solo costruire un modello di business redditizio è possibile in questi termini, ma è anche, ad oggi il modo più rapido ed efficace di costruire soluzioni ideali di frontiera.

In questo contesto, LangChain e AutoChain sono due framework di sviluppo che, come il nuovo Agents SDK di OpenAI, mirano a facilitare la costruzione di sistemi e soluzioni basati su agenti multimodali e autonomi.

LangChain è uno dei primi e più popolari framework per la creazione di applicazioni AI basate su modelli di linguaggio di grandi dimensioni e essa fornisce strumenti per collegare Large Language Models a database APi e servizi esterni e altri agenti, permettendo la costruzione di flussi di lavoro complessi.

È particolarmente usato poi per la creazione di chatbot avanzati, motori di ricerca intelligenti e assistenti di AI capaci di ragionamento sequenziale e decision making.

AutoChain, invece, è un altro framework alternativo che sviluppa agenti autonomi e semplifica in realtà il loro sviluppo, con focus però su efficienza e scalabilità.

AutoChain si propone di rendere più facile l’integrazione di modelli di AI con strumenti esterni, riducendo il bisogno anche di un’orchestrazione manuale.

L’introduzione dell’Agents SDK di OpenAI non è quindi un’innovazione assoluta, ma si inserisce in una tendenza chiara ,la creazione di strumenti sempre più sofisticati per sistemi multiagente.

La traiettoria dello sviluppo dell’AI sta andando quindi verso architetture in cui più agenti specializzati interagiscono e collaborano per risolvere problemi complessi.

E questa evoluzione è in realtà più che naturale.

I modelli di AI diventano più potenti non solo migliorando individualmente, ma anche lavorando in sistemi interconnessi.

Con l’Agents SDK OpenAI si posiziona al centro di questo ecosistema emergente, cercando di stabilire standard aperti per la creazione di agenti affidabili e scalabili.

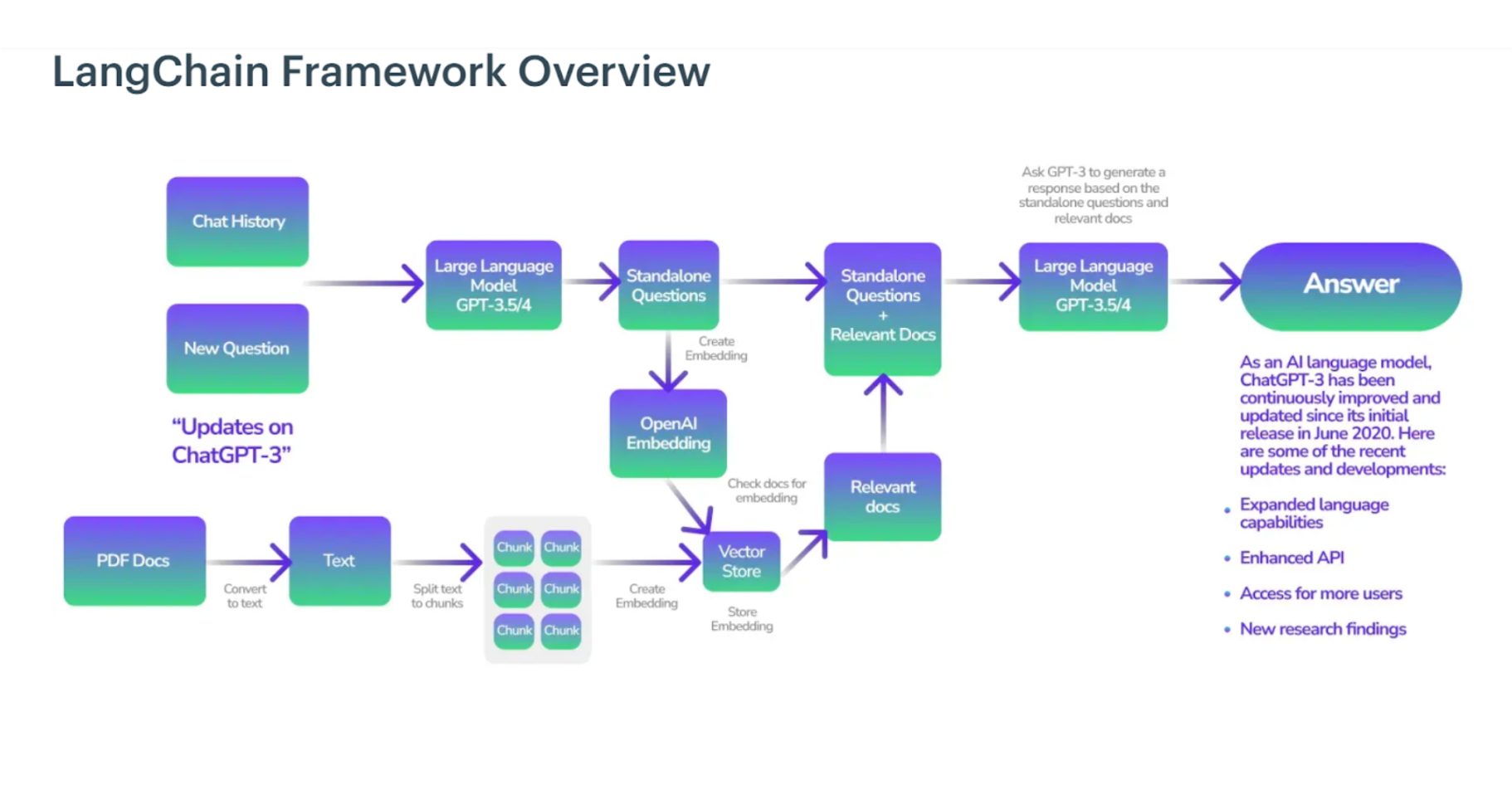

In questa immagine vediamo rappresentato il funzionamento di un sistema di Retrieval Augmented Generation, RAG, implementato con LangChain, evidenziando il processo di recupero e generazione di risposte con Large Language Models come GPT 3.5 o 4.0.

Il flusso inizia, vedete sulla sinistra, con una domanda dell’utente e se necessario, attingendo a dei documenti esterni, una caratteristica fondamentale per i sistemi RAG, al fine di fornire una risposta più contestualizzata.

I documenti, ad esempio in PDF, vengono quindi convertiti in testo, suddivisi in chunk, pezzettini archiviati in un Vector Store, un database per immagazzinare rappresentazioni semantiche di quello che c’è scritto nel testo.

Quando una domanda viene posta, il sistema crea l’embedding della query, la domanda, e recupera documenti rilevanti a livello semantico per contestualizzare meglio la risposta.

Quindi questi elementi, questi embedded, vengono passati al modello di generazione per poi generare la risposta in formato testuale.

LangChain semplifica enormemente l’implementazione di questo sistema a più step, offrendo astrazioni pronte per l’uso e per gestire il recupero di documenti, l’interazione con modelli di AI e l’orchestrazione dell’intero flusso di lavoro. Grazie a strumenti come OpenAI Embedding e Vector Stores anche sviluppatori con poca esperienza possono creare un sistema RAG molto potente con poche righe di codice, e questa facilità d’uso rende LangChain un’opzione ideale per costruire chatbot avanzati, assistenti AI e motori di ricerca intelligenti senza dover sviluppare tutto da zero.

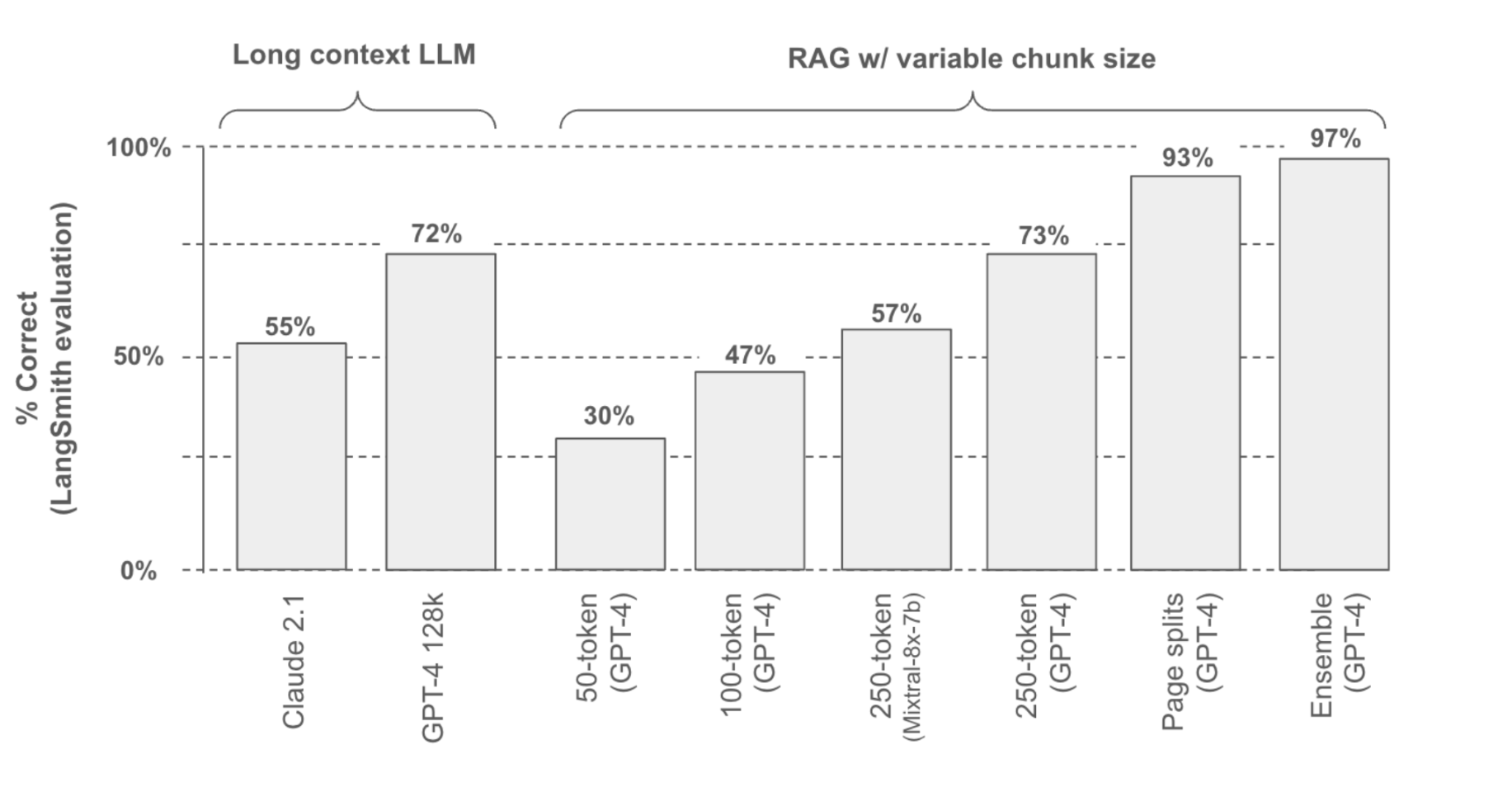

In questa immagine, invece, viene mostrato un confronto tra diversi approcci per l’estrazione di informazioni utilizzando un sistema RAG implementato tramite LangChain.

In particolare, si evidenzia come il metodo giusto possa migliorare drasticamente l’accuratezza delle risposte.

Il test valuta la percentuale di risposte corrette su un task di recupero di informazioni da tabelle, quindi anche uno scenario molto comune in ambienti gestionali aziendali e utilizzando sia un Large Language Model con contesto lungo come Claude 2.1 e GPT-4 128 K sia RAG con chunk di dimensioni variabili.

I risultati mostrano che i modelli con contesto lungo le due prime colonne a sinistra da soli non sono sufficienti, sebbene molto costosi, mentre un RAG ben configurato con chunk più grandi e strategie di fusione delle informazioni può raggiungere prestazioni molto più elevate, fino al 97%.

LangChain semplifica enormemente la costruzione di questi sistemi, anche multimodello, permettendo di gestire il recupero dati, Il chunkling e l’integrazione con database vettoriali, in poche righe di codice.

Quindi grazie a questi strumenti chiunque può costruire un sistema RAG multiagente efficace senza dover progettare un’intera infrastruttura da zero.

Bene, in questa puntata abbiamo discusso di Agents SDK LangChain e AutoChain e di come la nascita di questi framework di sviluppo di sistemi di multi agenti stia suggerendo una direzione molto chiara per il futuro dell’intelligenza artificiale.

Non si cerca più di sviluppare il grande modello monolitico di intelligenza artificiale come GPT-3 o 4 a porte chiuse peraltro, ma con un approccio decentralizzato, open source e collaborativo, attivo verso la creazione di soluzioni multiagenti, dove ogni modulo specializzato dà il suo contributo verso la creazione di una soluzione finale sempre più efficace ed efficiente.

Ciao! Alla prossima puntata di Le Voci dell’AI!