Trasformazione digitale significa soprattutto una nuova impennata nella quantità di dati da trattare e soprattutto nel numero e varietà di dispositivi da dover gestire.

In sintesi, la prospettiva peggiore per un responsabile dei sistemi informativi, dove strategie di investimento, anche recenti, non abbastanza lungimiranti possono contribuire a creare uno scenario se non da incubo, quasi. «Piaccia o no, è una situazione da affrontare – afferma Carlo Baffè, country manager di Suse in apertura del Suse Expert Day di Milano –. Significa affrontare sfide come rivedere i modelli di deployment, adattare le configurazioni e anche i modelli di programmazione. Senza dimenticare le implicazioni sulla sicurezza».

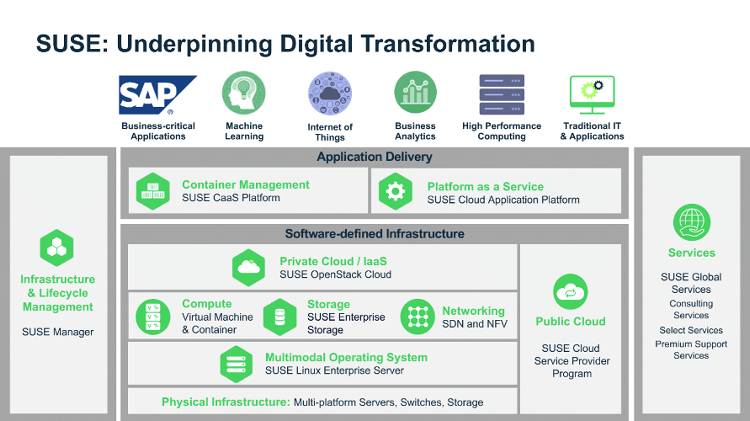

La tantissime sfaccettature di uno scenario ormai costantemente orientato verso soluzioni miste, come ha insegnato la via del cloud ibrido, rendono indispensabile trovare soluzioni a monte. Affidarsi cioè a strumenti il più possibile neutrali e inseguire la massima automazione.

«La realtà impone di rimuovere ogni barriera tra ambienti core, cloud ed edge – prosegue Baffè -. Deve risultare semplice e lineare spostare applicazioni e ripartire i carichi. Un obiettivo raggiungibile solo via software. Oltre agli strumenti però, serve cambiare mentalità».

Serve un’accelerata verso l’intelligenza artificiale

Come facile intuire, uno scenario inquadrato su misura per spianare la strada a un’adozione a tutto campo di software open source. Dietro i prevedibili interessi Suse però, gli spunti rilevanti non mancano.

A partire dalla potenza di calcolo extra indispensabile per assecondare un’intelligenza artificiale ormai in cima alle richieste del management verso il dipartimento IT. «Impatterà comunque i sistemi aziendali – conferma Alessandro Festa, product manager GPU computing, AI, machine learning di Suse -. Bisogna prima di tutto individuare ciò che porta valore, quindi decidere passi non affrettati, ma il linea con la velocità del mercato».

Tre i passaggi fondamentali individuati dall’azienda. Prima di tutto, accelerare. Nel senso letterale, con strumenti espressamente dedicati a semplificare l’accesso ai chip Nvidia. Non gli unici, ma attualmente stimati al 95% del mercato. In prospettiva di un maggiore riequilibrio, l’attenzione è comunque rivolta anche a Intel e AMD. In pratica, rendere più accessibili driver e configurazioni, liberando dagli oneri di doverli inseguire, sfruttando strumenti come Partner Hub.

«Disponibile la capacità, bisogna adattare anche il modello di business – riprende Castelli -. Al riguardo, mettiamo a disposizione gli strumenti utili a sviluppare il progetto. Non realizziamo noi i progetti, ma mettiamo in condizione di farlo al meglio». L’impegno Suse in questo caso è supportare i maggiori framework di machine learning, con l’obiettivo di costruire una piattaforma al servizio dei data scientist in modo da nascondere le complessità infrastrutturali. Entra in gioco al riguardo la disponibilità di Container scaricabili e pienamente supportati, in modo da ridurre il lavoro di configurazione.

A questo punto, è realmente possibile puntare all’innovazione, inseguire cioè il valore aggiunto. «Sempre in riferimento al caso dell’intelligenza artificiale, non va considerata un prodotto o una soluzione, quanto invece una commodity – precisa Castelli -. Dovrebbe essere all’interno dei prodotti senza variarne la natura, aumentandone le capacità e quindi produttività».

Nello specifico, il modulo SES 6.0, può rivelarsi utile in una situazione sempre delicata come la gestione dei log, per prevedere gli errori di sistema prima che accadano così da aumentare l’efficienza dell’ecosistema aziendale.

Tutta la flessibilità dell’edge computing

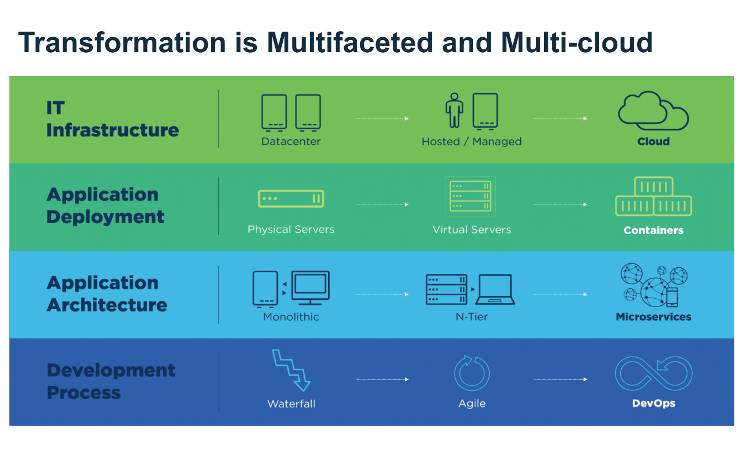

Ripensare i sistemi significa anche rivedere il modo di sviluppare applicazioni. Sulla scia di quanto avvenuto solo pochi anni fa con il passaggio al cloud e relativa generazione di software, ora è il momento di spingersi ancora oltre. «Il modello di monolite con tutte le funzioni all’interno non è più sostenibile – osserva Flavio Castelli, software engineer manager di Suse -. Per supportare adattamenti, modifiche e aggiornamenti servono cicli di vita molto più corti, quasi settimanali».

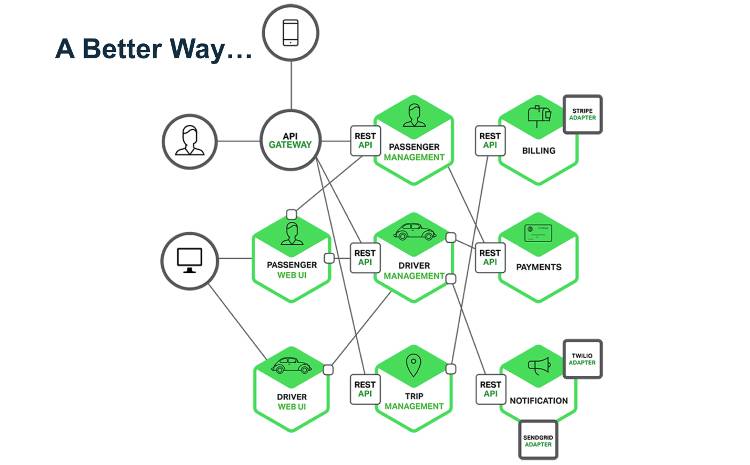

La soluzione in questo caso passa per i microservices, dove ogni modulo è responsabile di una sola funzionalità. Una volta messo a punto, deve naturalmente comunicare e integrarsi con gli altri, scambiare dati e interagire con l’utente finale.

Una combinazione troppo grande per le possibilità umane. La risposta in questo caso passa per gli Application container, il passo successivo alla virtualizzazione con un salto di qualità anche in termini di agilità. «La risposta ideale secondo noi è Kubernetes – sottolinea Castelli -, la soluzione open source intorno alla quale abbiamo costruito Suse CaaS Platform e in grado di supportare ogni fase dalla progettazione alla manutenzione».

Basato su Cloud Foundry e opportunamente rivisitato nel rispetto delle certificazioni, garantisce anche la massima libertà d’azione, scongiurando il sempre più temuto lock-in. «Lo sviluppatore può concentrarsi sul suo mestiere, scrivere codice – ribadisce Castelli -. Non serve adattarsi a funzioni di basso livello. Si scelgono i Build Pack Foundry, disponibili per diversi linguaggi e in grado di importare le dipendenze. Tutto il resto, distribuzione, installazione, patch, è automatico».

Anche Microsoft fa rima con open source

Quanto tutto questo sia in linea con la realtà, e quanto sia determinante il ruolo dell’open source è confermato da un punto di vista per nulla scontato. «La partnership con il mondo open source per noi è diventata completamente trasparente – ammette Mattia De Rosa, cloud enterprise business group lead di Microsoft -. Non abbiamo interesse a rendere complicato l’adozione di questi software o a combinarli con in nostri, perché a loro è legata una parte importante del nostro business».

Individuate le potenzialità, Microsoft ha affidato ad Azure il grosso potenziale e adeguato di conseguenza l’offerta. «Ci sono tante realtà dove il cloud puro non può essere la soluzione – sottolinea De Rosa -. In realtà ibride, dove per esempio si gestiscono diversi TB di dati al giorno, non è pensabile trasferire tutto. Per questo, servono partnership trasparenti, aperte a tutte le tecnologie. Non avremmo alcun interesse a rendere complicata l’adozione o l’integrazione di un software open source».

Come dimostra tra l’altro il 40% di server virtuali Linux caricati su Azure o il 60% di soluzioni open source presenti sul marketplace. Oltre naturalmente alla stretta collaborazione con Suse per fornire soluzioni cloud complete.

L’energia dell’edge alimenta anche Enel

Per quanto preciso e rigoroso, un lungo percorso teorico alla fine del quale è indispensabile aggiungere concretezza. «Il nostro primo approccio a Linux risale al 2004 – ricorda Jacopo Longhini, IT cloud architect di Enel -. Dopo diverse prove, nel 2012 abbiamo migrato migliaia di sistemi. Oggi è ormai completato anche il passaggio al cloud avviato nel 2015 da subito accompagnati da Suse».

Il risultato più visibile, la scomparsa dei data center interni, con relativi costi e incombenze gestionali per una realtà particolarmente distribuita. Lo sguardo però, è già al passo successivo. «Pochi mesi fa abbiamo concluso anche la migrazione all’edge computing, da noi ribattezzato Beyond Cloud Computing – riprende Longhini -. Dai rack con svariate componenti, siamo passati all’adottare localmente hardware generico gestito centralmente».

L’impostazione aiuta prima di tutto di ridurre i costi complessivi degli apparati, liberandosi anche di vincoli con carrier e fornitori. Il controllo centrale via software permette di comunicare, inviare e installare aggiornamenti senza preoccuparsi delle singole configurazioni hardware. «In assenza di una vera ridondanza, potrebbe servire qualche giorno per intervenire sull’hardware – precisa Longhini -. Per questo abbiamo previsto una piccola scheda SSD con tutto il necessario all’installazione. All’occorrenza, si attiva da remoto, senza prevedere ingenti trasferimenti di dati».

Oltre ai benefici del consolidamento, importante sottolineare anche i tempi di migrazione ridotti a pochi minuti. L’adozione di una piattaforma aperta inoltre, viene considerata la più adatta a supportare velocemente qualsiasi ulteriore sviluppo o anche solo il passaggio tra software. «Parliamo di una infrastruttura distribuita ormai su oltre mille uffici locali in 21 Paesi – conclude Longhini -. In Italia soprattutto ma anche in Spagna, con 16 punti di WAN aggregation».